【HDFS入门】HDFS数据冗余与容错机制解析:如何保障大数据高可靠存储?

目录

1 HDFS冗余机制设计哲学

1.1 多副本存储策略的工程权衡

1.2 机架感知的智能拓扑算法

2 容错机制实现原理

2.1 故障检测的三重保障

2.2 数据恢复的智能调度

3 关键场景容错分析

3.1 数据中心级故障应对

3.2 数据损坏的校验机制

4 进阶优化方案

4.1 纠删码技术实践

4.2 混合存储策略

5 监控与调优指南

5.1 关键监控指标

5.2 性能调优参数

6 总结

1 HDFS冗余机制设计哲学

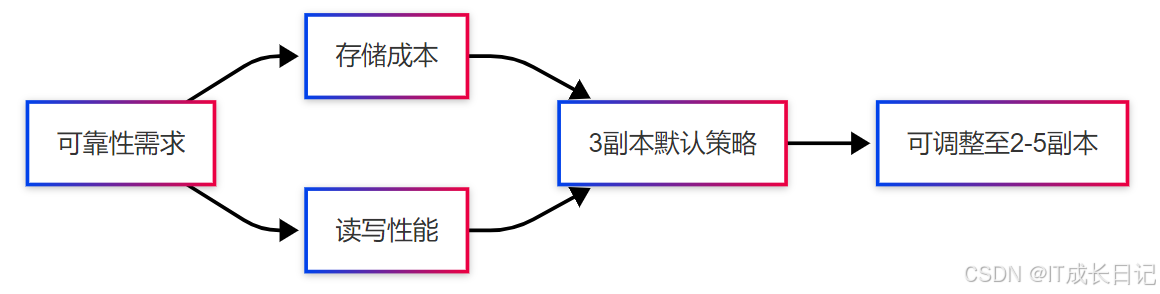

1.1 多副本存储策略的工程权衡

- 副本策略选择矩阵

| 副本数 | 可靠性 | 存储开销 | 适用场景 |

| 2 | 99.99% | 2x | 测试环境 |

| 3 | 99.9999% | 3x | 生产环境(默认) |

| 5 | 99.999999% | 5x | 核心数据 |

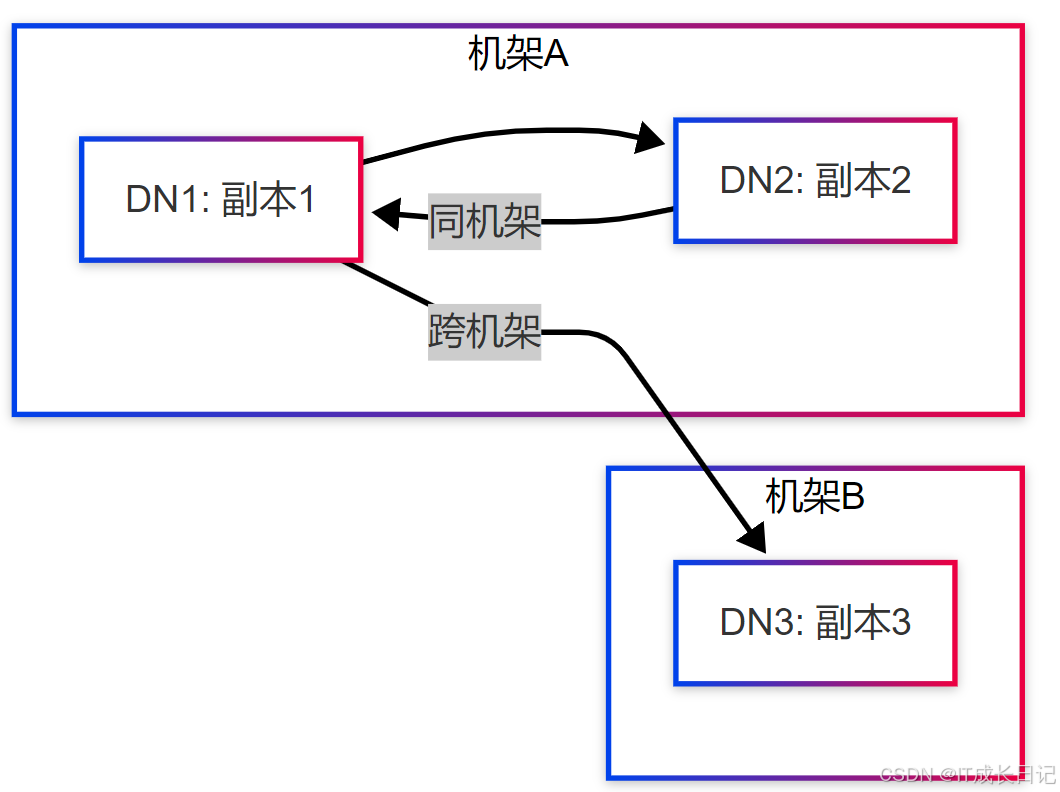

1.2 机架感知的智能拓扑算法

- 副本放置策略演进

经典策略(Hadoop 1.x):

- 第1副本:写入节点本地

- 第2副本:随机同机架节点

- 第3副本:随机跨机架节点

改进策略(Hadoop 2.x+):

- 第3副本优先选择不同电源域的机架

- 考虑网络带宽拓扑(核心/边缘交换机)

2 容错机制实现原理

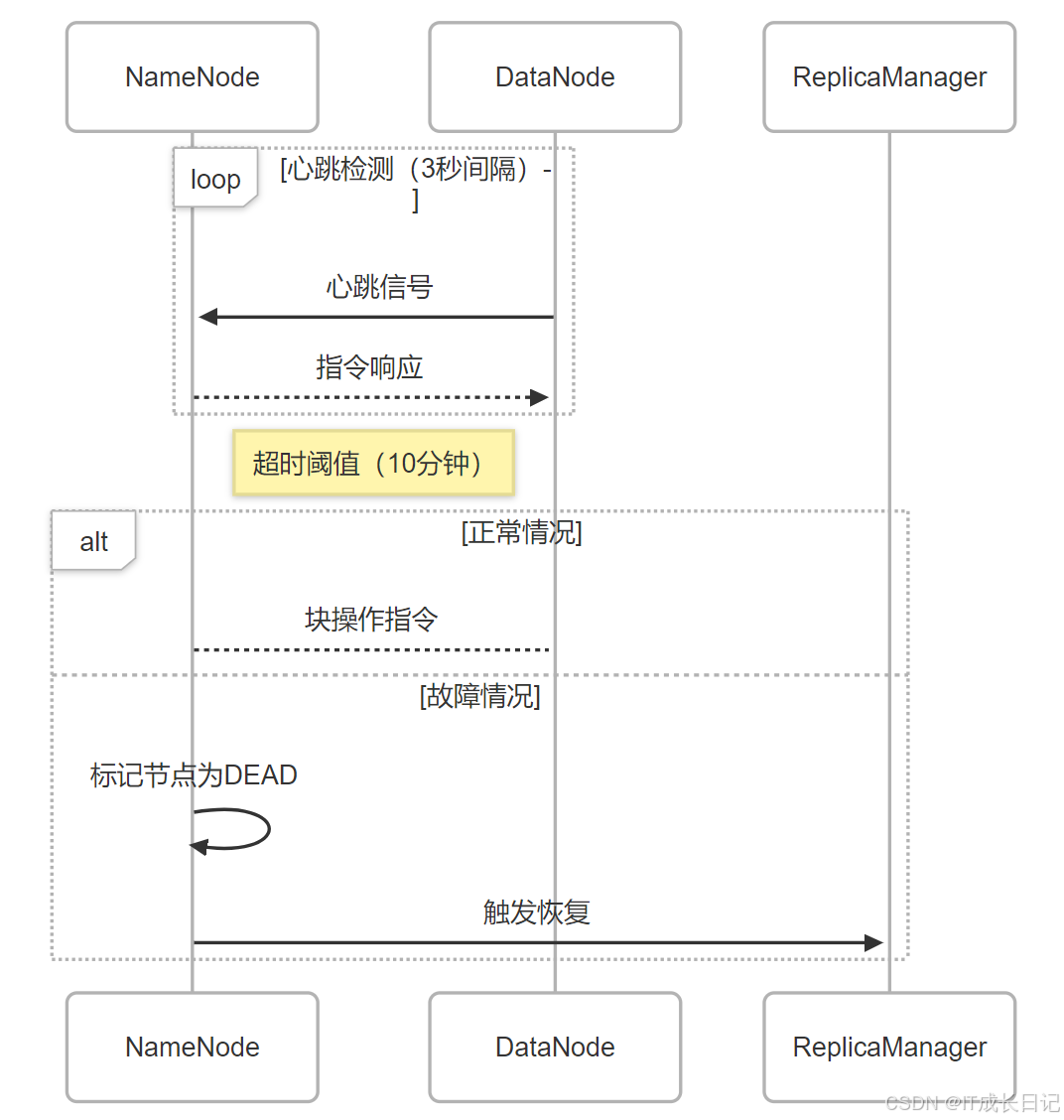

2.1 故障检测的三重保障

| 机制 | 触发条件 | 检测粒度 | 耗时 |

| 心跳检测 | 无响应>10分钟 | 节点级 | 10分钟 |

| 块报告 | 校验和失败 | 块级(128MB) | 即时 |

| 写管道监控 | 写入失败>3次 | 操作级 | 秒级 |

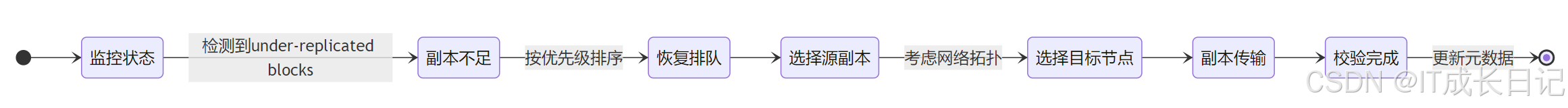

2.2 数据恢复的智能调度

- 恢复策略优化点

带宽限制:恢复过程不超过集群带宽的30%

<property><name>dfs.datanode.balance.bandwidthPerSec</name><value>10MB</value>

</property>优先级策略:

- 系统关键块(如fsimage)优先恢复

- 近期访问热点数据提高优先级

3 关键场景容错分析

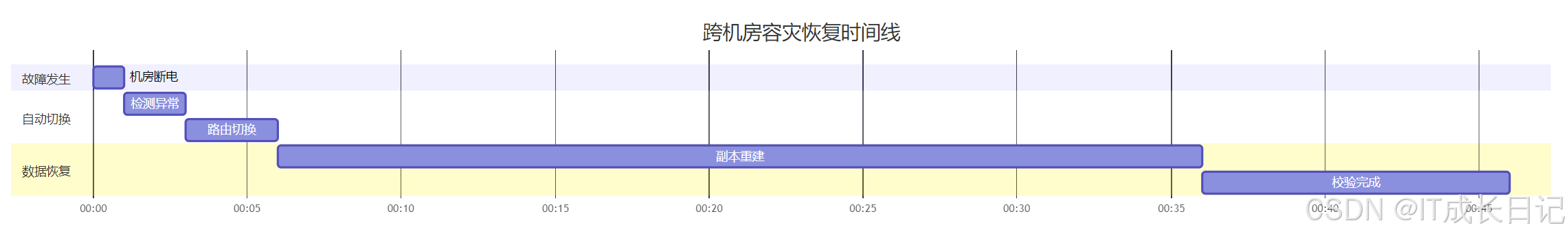

3.1 数据中心级故障应对

- 多机房部署建议:

副本分布:

- 主机房:2副本

- 备机房:1副本

网络配置:

- 专线带宽≥1Gbps

- 延迟≤5ms

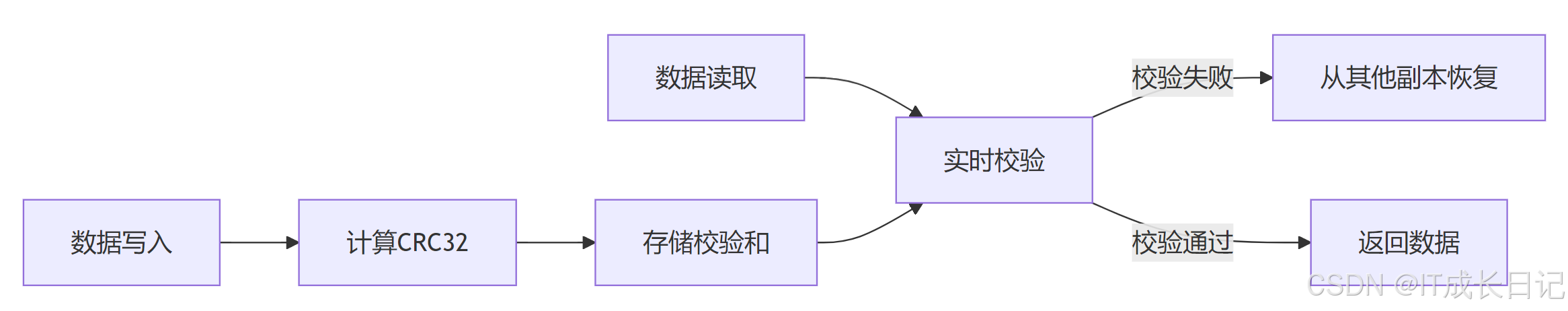

3.2 数据损坏的校验机制

- 校验和配置参数

<!-- 校验和类型 -->

<property><name>dfs.checksum.type</name><value>CRC32C</value> <!-- 比CRC32快15% -->

</property><!-- 校验字节数 -->

<property><name>dfs.bytes-per-checksum</name><value>512</value> <!-- 默认512字节 -->

</property>4 进阶优化方案

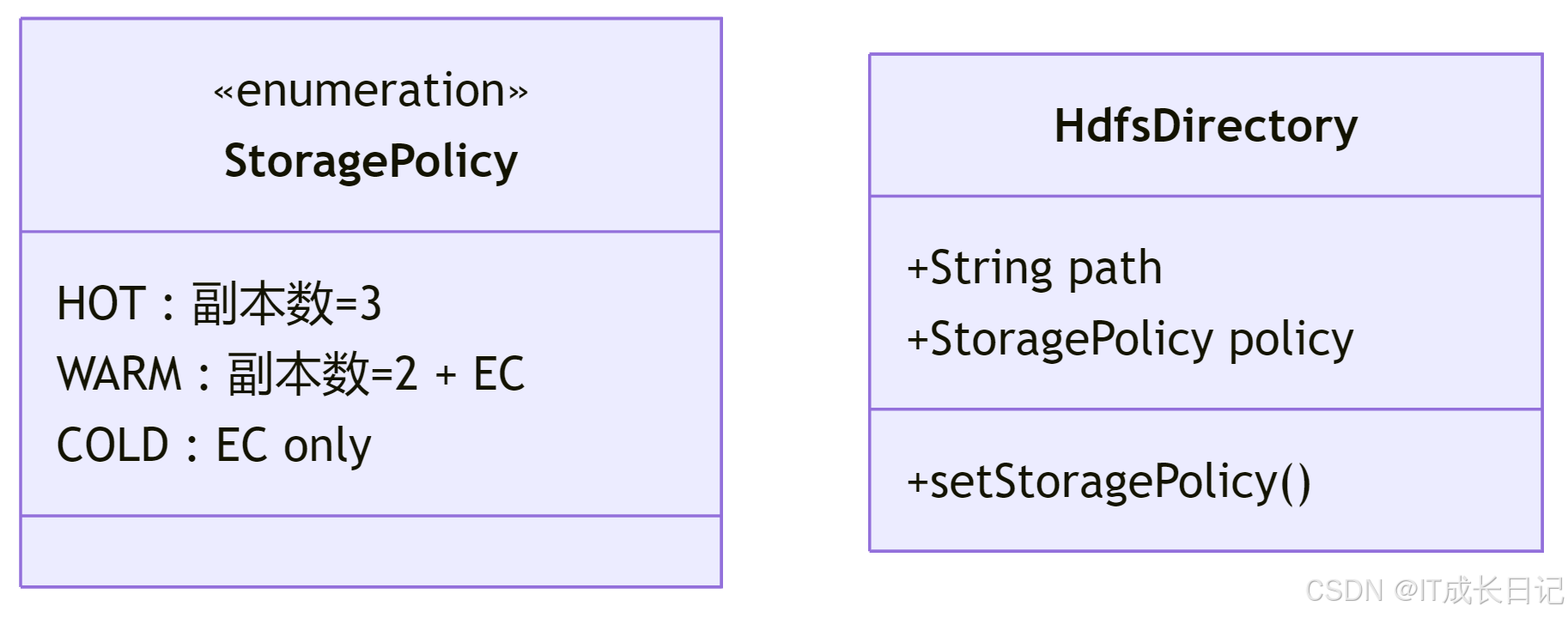

4.1 纠删码技术实践

- 纠删码配置示例

# 创建纠删码策略

hdfs ec -enablePolicy -policy RS-6-3-1024k# 应用到目录

hdfs ec -setPolicy -path /data/ec_data -policy RS-6-3-1024k适用场景选择:

- 适合EC:冷数据、归档日志

- 适合副本:热数据、实时计算

4.2 混合存储策略

- 策略配置示例

# 设置热数据策略

hdfs storagepolicies -setStoragePolicy -path /hot_data -policy HOT# 查看策略

hdfs storagepolicies -getStoragePolicy -path /hot_data5 监控与调优指南

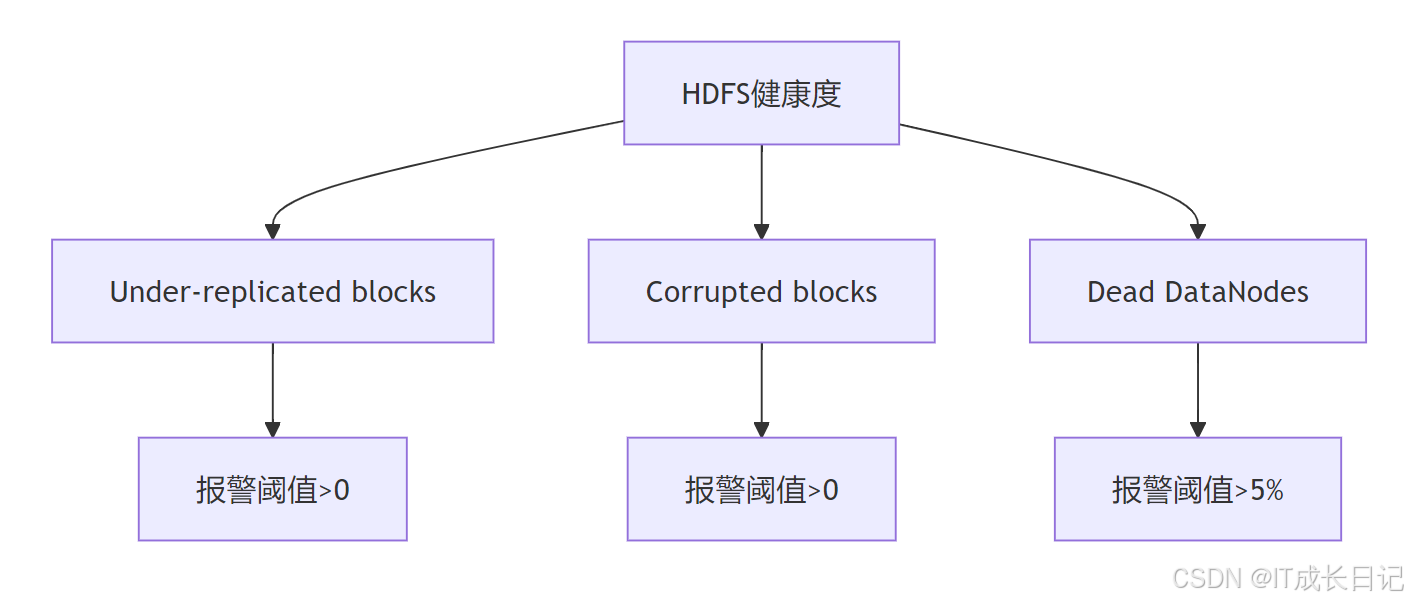

5.1 关键监控指标

5.2 性能调优参数

- 核心参数推荐

<!-- 控制恢复速度 -->

<property><name>dfs.namenode.replication.work.multiplier</name><value>4</value> <!-- 默认2,可提升并行度 -->

</property><!-- 重试策略 -->

<property><name>dfs.client.block.write.retries</name><value>6</value> <!-- 默认3,适应不稳定网络 -->

</property>6 总结

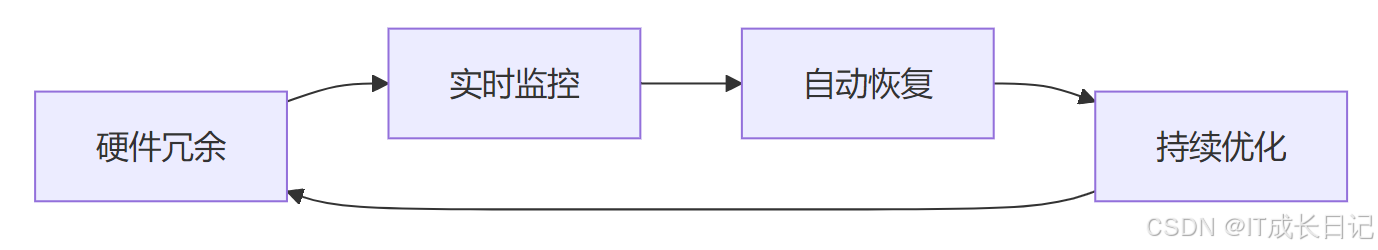

HDFS容错设计的精妙之处在于:分层防御:

- 硬件级:多副本分布

- 系统级:心跳检测+校验和

- 架构级:机架感知+跨机房

自适应恢复:

- 动态调整恢复速率

- 智能选择恢复源

- 优先级调度机制

通过本文深度解析,了解了HDFS可靠性机制,根据业务需求定制存储策略,构建兼顾可靠性与成本效益的大数据存储体系。