1.kafka消息发送的流程?

生产者:

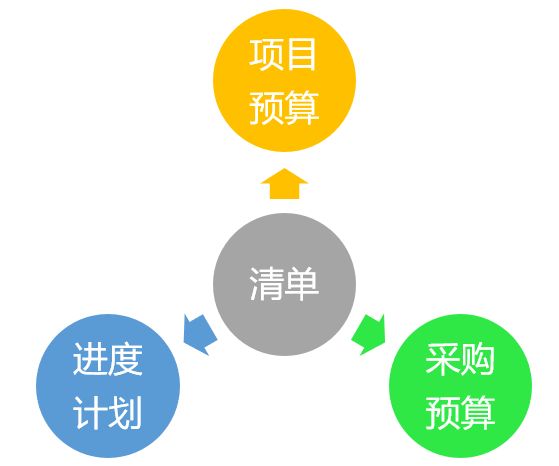

在消息发送的过程中涉及到了两个线程:main线程和sender线程。在main线程中创建了一个双端队列RecordAccumulator(默认32m)。main线程将消息发送到RecordAccumulator,sender线程不断地从RecordAccumulator中拉取数据到KafkaBroker。如下图:

batch.size:只有数据积累到batch.size之后,sender才会发送数据,默认为16k。

linger.ms:如果数据迟迟未到16k,sender等待linger.ms设置的时间到了之后会发送数据,单位为ms默认为0ms。

另外kafka生产者可通过设置ack的以下参数来控制发送消息流程:

0: 生产者发送的数据,不需要等数据落盘应答。

1:生产者发送过来的数据,Leader收到数据后应答。

-1:(all):生产者发送过来的数据,Leader 和 ISR 队列里面的所有节点收齐数据后应答。 -1 和 all 是等价的。

消费者:

消费方式主要有推(push)和拉(pull)两种模式:

消费者总体工作流程如下图所示:

一个消费者组中的多个消费者,可以看作一个整体,一个组内的多个消费者是不可能去消费同一个分区的数据的,要不然就消费重复了。

2.ISR、OSR、AR 是什么?

ISR里存放的是存活的broker 比如broker[0,1,2]表示服务器上id为0,1,2的kafka服务存活。OSR里存放的是停止的broker,与broker类似。AR表示的是选举的顺序例如AR[2,0,1]表示kafka集群首选leader为2次为0最后为1。

三者关系:

AR=ISR+OSR

3.Kafka 的设计架构

1)Producer:消息生产者,就是向 Kafka broker 发消息的客户端。

2)Consumer:消息消费者,向 Kafka broker 取消息的客户端。

3)Consumer Group(CG):消费者组,由多个 consumer 组成。消费者组内每个消 费者负责消费不同分区的数据,一个分区只能由一个组内消费者消费;消费者组之间互不影响。所有的消费者都属于某个消费者组,即消费者组是逻辑上的一个订阅者。

4)Broker:一台 Kafka 服务器就是一个 broker。一个集群由多个 broker 组成。一个 broker 可以容纳多个 topic。

5)Topic:可以理解为一个队列,生产者和消费者面向的都是一个 topic。

6)Partition:为了实现扩展性,一个非常大的 topic 可以分布到多个 broker(即服务器)上,一个 topic 可以分为多个 partition,每个 partition 是一个有序的队列。

7)Replica:副本。一个 topic 的每个分区都有若干个副本,一个 Leader 和若干个 Follower。

8)Leader:每个分区多个副本的“主”,生产者发送数据的对象,以及消费者消费数据的对象都是 Leader。

9)Follower:每个分区多个副本中的“从”,实时从 Leader 中同步数据,保持和 Leader 数据的同步。Leader 发生故障时,某个 Follower 会成为新的 Leader。

具体架构如下图所示:

4.Kafka 分区的目的

(1)便于合理使用存储资源,每个Partition在一个Broker上存储,可以把海量的数据按照分区切割成一块一块数据存储在多台Broker上。合理控制分区的任务,可以实现负载均衡的效果。

(2)提高并行度,生产者可以以分区为单位发送数据;消费者可以以分区为单位进行消费数据。

5.Kafka 是如何做到消息的有序性

.将kafka分区数和如下图所示的生产者发送消息的sender线程中的队列设为一个。kafka可以保证发送消息时在单个分区内的有序性但是有多个分区时顺序会出现乱序的情况,因此只设置一个分区可以防止分区发送时乱序,而在sender线程kafka生产者发送消息未得到应答后后将该消息调整到最后一个队列发送,因此应当队列调整为一个当发送消息得不到应答时继续发送,直至最大重试次数(默认很大但可以自行调整)。

6.Kafka 在什么情况下会出现消息丢失

当ack的参数设置为0时,在sender队列里发送消息后不需要得到任何应答就进行下一条消息的发送,此时很可能就会出现消息丢失。

当ack参数设置为1时,在Kafka生产者sender队列里发送消息后leader应答后就会清理该条消息,进行下一条消息的发送,但此时follower是否已经同步leader上面的消息未知(leader接受到消息后可能会挂掉),也会造成消息丢失。

当ack参数设置为-1时,在kafka生产者sender队列里发送消息后需要得到leaderLeader和ISR队列里面的所有节点收齐数据后应答。如果一个副本由于网络故障或某些原因无法同步,而 Kafka 中没有足够的副本来满足“所有副本确认”要求,Kafka 就不能在规定时间内完成所有副本的确认,这时生产者会收到一个失败的响应,数据可能会丢失。

最终可靠性不丢失数据方案:

数据完全可靠条件 = ACK级别设置为-1 + 分区副本大于等于2 + ISR里应答的最小副本数量大于等于2

![[ARM-2D 专题]6.脏矩形定义的宏使用技巧和分析](https://i-blog.csdnimg.cn/direct/0150b9d5698547d5a83c9377899f5990.png)