大数据测试 Elasticsearch — 详细教程及实例

- 1. Elasticsearch 基础概述

- 核心概念

- 2. 搭建 Elasticsearch 环境

- 2.1 安装 Elasticsearch

- 2.2 配置 Elasticsearch

- 3. 大数据测试的常见方法

- 3.1 使用 Logstash 导入大数据

- 3.2 使用 Elasticsearch 的 Bulk API

- 3.3 使用 Benchmark 工具

- 4. 性能调优

- 4.1 增加分片数

- 4.2 配置硬件资源

- 4.3 使用 Bulk 索引

- 5. 常见问题与解决方案

- 5.1 索引速度慢

- 5.2 查询性能差

Elasticsearch 是一个开源的分布式搜索和分析引擎,广泛应用于日志分析、全文检索和大数据分析等领域。本文将介绍如何进行大数据量的测试,帮助您更好地理解 Elasticsearch 的性能表现,并通过实例演示相关操作。

1. Elasticsearch 基础概述

Elasticsearch 是基于 Lucene 构建的分布式搜索引擎,通常用作数据存储、索引和搜索的引擎。它支持高效的全文检索、聚合查询和多维度分析,能够处理 PB 级别的大数据量。

核心概念

- Index: 数据库类似的结构,包含一组文档。

- Document: 单条记录,相当于关系型数据库中的一行。

- Field: 文档中的字段,相当于关系型数据库中的列。

- Shard: 索引分片,Elasticsearch 将一个索引分为多个分片进行存储和计算。

- Replica: 副本,为了容错性,可以提高查询性能。

2. 搭建 Elasticsearch 环境

在进行大数据测试之前,首先需要搭建一个 Elasticsearch 环境。下面是一个基本的安装和配置过程。

2.1 安装 Elasticsearch

-

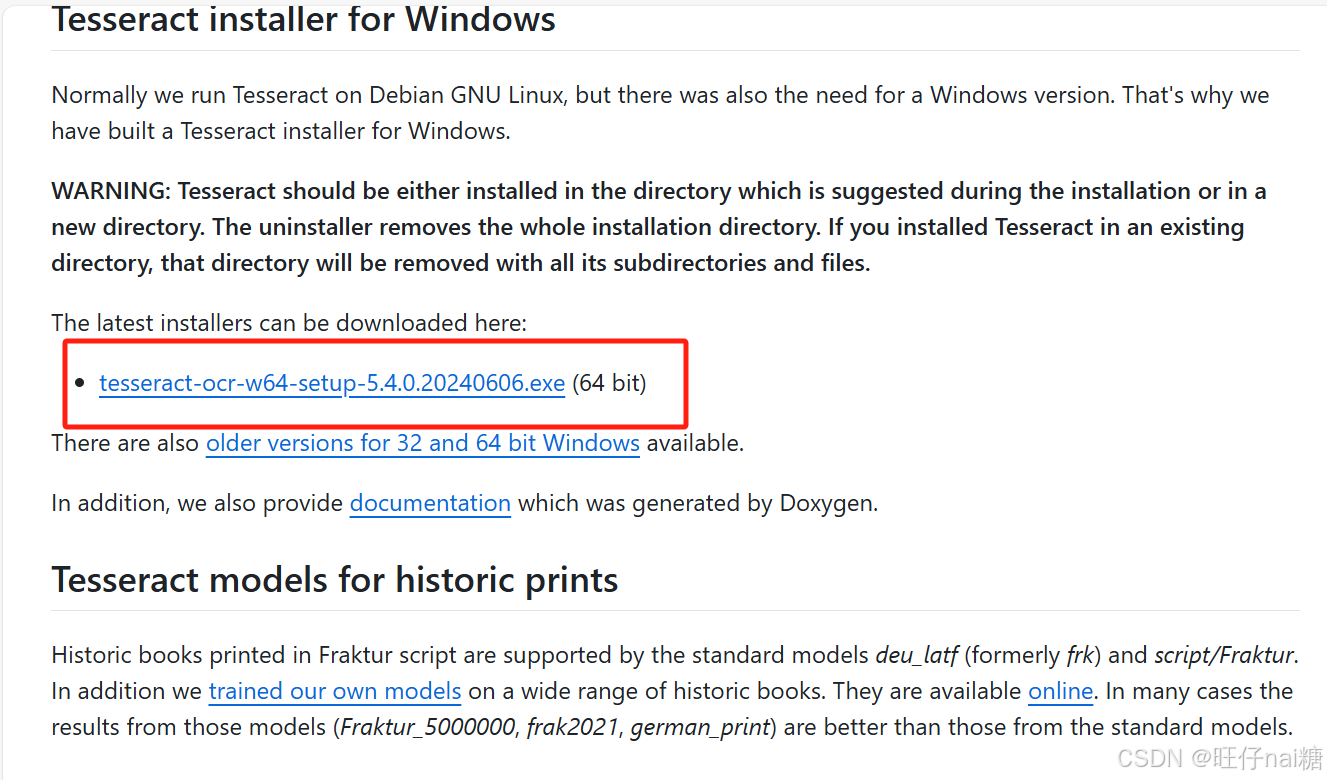

下载并解压 Elasticsearch

访问 Elasticsearch 官方下载页面,下载适合你系统的版本,并解压。tar -xzf elasticsearch-7.17.0-linux-x86_64.tar.gz cd elasticsearch-7.17.0 -

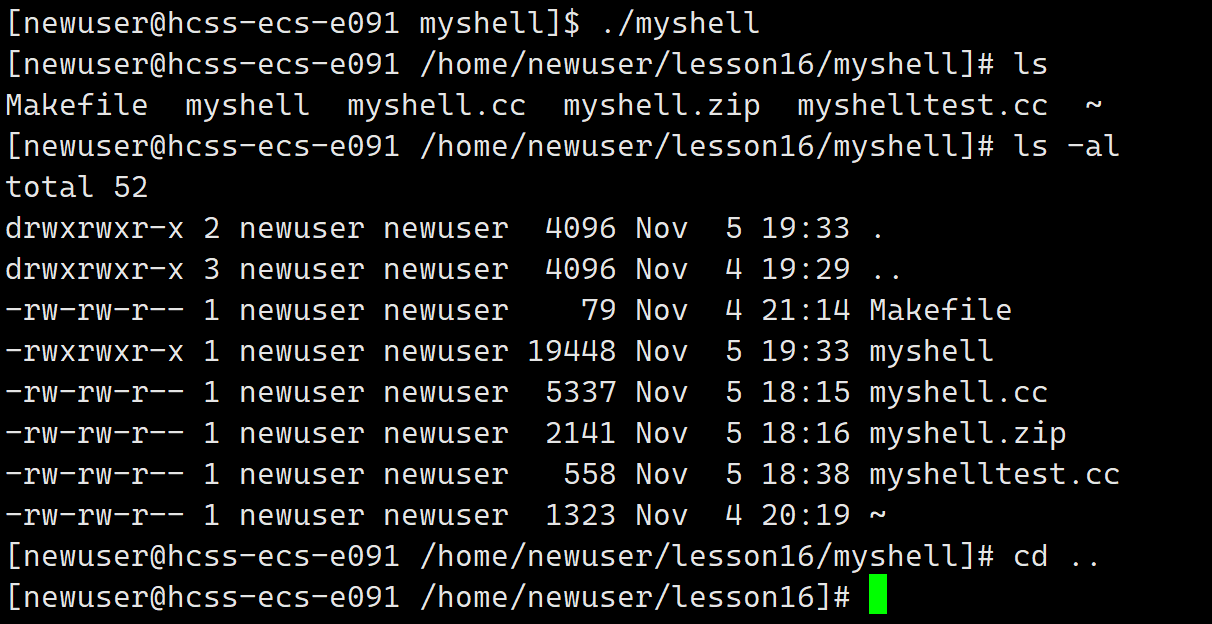

启动 Elasticsearch

执行以下命令启动 Elasticsearch 服务:

./bin/elasticsearch -

验证启动成功

在浏览器中访问

http://localhost:9200,如果成功启动,你应该会看到类似以下的响应:{"name" : "node-1","cluster_name" : "elasticsearch","cluster_uuid" : "QXt1DbR6QhuFU5fK3kpEhw","version" : {"number" : "7.17.0","build_flavor" : "default","build_type" : "tar","build_hash" : "47c6ff5","build_date" : "2021-10-05T08:21:09.741407Z","build_snapshot" : false,"lucene_version" : "8.9.0","minimum_wire_compatibility_version" : "6.8.0","minimum_index_compatibility_version" : "6.0.0"},"tagline" : "You Know, for Search" }

2.2 配置 Elasticsearch

配置文件位于 config/elasticsearch.yml,你可以根据需要修改如下参数:

cluster.name: 设置集群名称node.name: 设置节点名称network.host: 设置网络绑定地址discovery.seed_hosts: 设置集群发现的其他节点

3. 大数据测试的常见方法

大数据测试通常涉及对 Elasticsearch 集群的负载、吞吐量、延迟、资源消耗等方面进行压力测试。以下是几种常见的方法:

3.1 使用 Logstash 导入大数据

Logstash 是 Elastic Stack 的一部分,适用于从各种来源(如数据库、文件、消息队列等)导入数据。你可以使用 Logstash 导入大量数据,进行大数据测试。

-

安装 Logstash

从官网 Logstash 下载页面 下载并安装。

-

配置 Logstash 数据导入

创建一个简单的 Logstash 配置文件

logstash.conf:input {file {path => "/path/to/your/big_data_file.csv"start_position => "beginning"} }filter {csv {separator => ","columns => ["id", "name", "timestamp", "value"]} }output {elasticsearch {hosts => ["http://localhost:9200"]index => "big_data_index"} } -

运行 Logstash

执行以下命令启动 Logstash:

bin/logstash -f logstash.conf

通过这种方式,你可以轻松地将大量数据导入到 Elasticsearch 中,进行性能和查询测试。

3.2 使用 Elasticsearch 的 Bulk API

Elasticsearch 提供了 Bulk API 来进行批量插入操作,这对于大数据测试非常有用。以下是如何使用 Bulk API 导入数据:

-

构造 Bulk 请求

Bulk API请求由一系列操作组成,每个操作都是一个 JSON 格式的请求。下面是一个例子:{ "index": { "_index": "big_data_index", "_id": 1 } } { "name": "Alice", "age": 30, "city": "New York" } { "index": { "_index": "big_data_index", "_id": 2 } } { "name": "Bob", "age": 25, "city": "San Francisco" } -

执行 Bulk 请求

使用

curl或者通过客户端进行请求:curl -X POST "localhost:9200/_bulk" -H 'Content-Type: application/json' -d @bulk_data.json其中

bulk_data.json是上面构造的 JSON 请求文件。

3.3 使用 Benchmark 工具

Elasticsearch 自带一个性能测试工具叫做 Rally。通过 Rally 可以模拟各种负载进行性能测试。

-

安装 Rally

在 Elasticsearch 安装目录下运行以下命令安装 Rally:

bin/elasticsearch-plugin install org.elasticsearch.plugin:rally -

运行 Rally 测试

运行以下命令来启动一个简单的基准测试:

bin/elasticsearch-rally --track=geonames这将会模拟一组针对地理数据的查询和索引操作,来测试 Elasticsearch 的性能。

4. 性能调优

在进行大数据量测试时,你可能需要根据测试结果调整 Elasticsearch 的配置,以提高性能。以下是一些常见的优化方法:

4.1 增加分片数

默认情况下,Elasticsearch 为每个索引创建 5 个主分片(shards)。对于大数据量的索引,适当增加分片数可以提高索引和查询性能。

index:number_of_shards: 10 # 增加分片数量

4.2 配置硬件资源

- 内存:Elasticsearch 通常需要大量内存,可以通过调整

jvm.options文件中的堆内存大小来配置 JVM 的内存分配。 - 磁盘:确保使用 SSD 来提高磁盘 I/O 性能,尤其是在处理大数据时。

- 网络:Elasticsearch 是分布式的,节点之间的网络带宽非常重要。如果使用多节点集群,确保节点之间的网络速度足够快。

4.3 使用 Bulk 索引

Bulk 操作比单个文档的逐一插入更高效。尽量使用 Bulk API 或者 Logstash 批量导入数据。

5. 常见问题与解决方案

5.1 索引速度慢

如果你在导入大量数据时遇到索引速度慢,可以尝试以下方法:

-

关闭副本:临时关闭副本可以提高索引速度,待数据导入后再开启副本。

curl -X PUT "localhost:9200/index_name/_settings" -H 'Content-Type: application/json' -d '{"index": {"number_of_replicas": 0} }'

5.2 查询性能差

对于查询性能差的问题,你可以:

- 优化查询:避免使用不必要的复杂查询,简化查询逻辑。

- 调整映射:根据数据的使用模式调整字段类型和索引策略。

推荐阅读:《大数据 ETL + Flume 数据清洗 — 详细教程及实例》