目录

1.引言

2.什么是强化学习?

3.深度学习和强化学习的结合

4.深度强化学习的主要方法

5.深度强化学习的应用领域

6.深度强化学习的挑战与未来

7.总结

1.引言

深度强化学习(Deep Reinforcement Learning,DRL)是近年来人工智能领域的热门话题。它结合了深度学习和强化学习的优势,不仅可以在复杂的环境中自主学习策略,还能在无人驾驶、金融市场分析、游戏AI等多个领域展示强大的性能。

2.什么是强化学习?

在强化学习中,智能体(Agent)通过在环境中采取一系列行动,以最大化其累积奖励。环境会对智能体的行动给予反馈(即奖励或惩罚),智能体则会基于这些反馈调整策略。

强化学习问题通常可以用“马尔可夫决策过程”(Markov Decision Process, MDP)来描述,包含以下四个元素:

- 状态(State, S):描述当前环境的情况。

- 动作(Action, A):智能体可以在当前状态下执行的操作。

- 奖励(Reward, R):环境在智能体采取某个动作后返回的反馈值,用于评估该动作的好坏。

- 策略(Policy, π):一种策略或规则,定义了智能体在每个状态下应采取的行动。

3.深度学习和强化学习的结合

传统的强化学习在处理高维状态空间时面临挑战。深度学习的引入使得强化学习能够更好地应对图像、文本等复杂输入。深度强化学习主要依靠深度神经网络来逼近价值函数或策略,从而更好地决策。

4.深度强化学习的主要方法

-

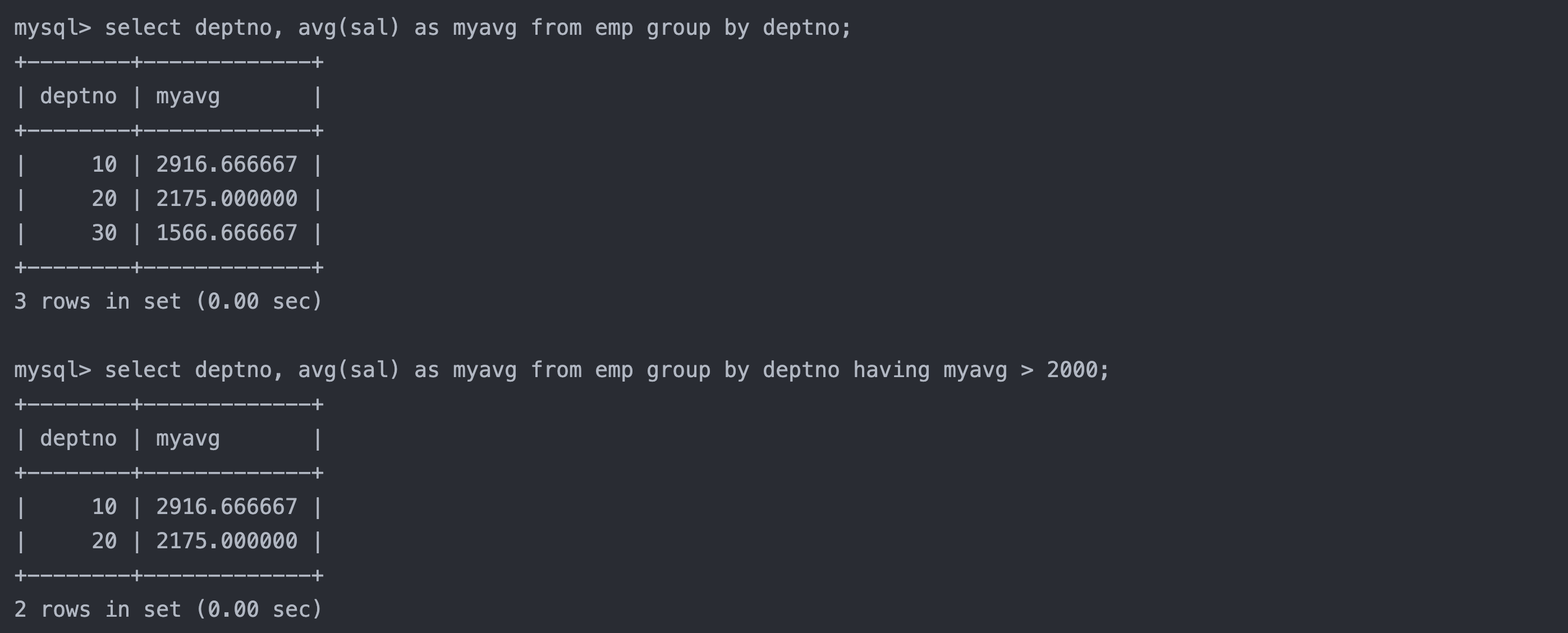

值函数方法:这类方法使用深度神经网络逼近“状态-动作值函数”(Q函数),即“Q-Learning”。通过不断优化网络的输出,使其逐渐接近最优Q值。代表性算法是深度Q网络(DQN),其中深度Q网络使用神经网络来逼近Q值。

图2 DQN结构示意图 -

策略梯度方法:与值函数方法不同,策略梯度方法直接优化策略函数,以提高累积奖励。策略梯度方法通过更新策略参数来改进策略,使智能体倾向于采取可以获得更高奖励的动作。代表性算法包括策略梯度法(PG)、**深度确定性策略梯度(DDPG)**等。

图3 Policy Gradient的梯度更新示意图 -

Actor-Critic方法:结合了值函数方法和策略梯度方法的优点,Actor-Critic方法将策略更新(Actor)和值函数更新(Critic)分开,从而在策略更新中更好地利用价值函数的反馈。代表性算法包括**A3C(异步优势演员-评论家)和PPO(近端策略优化)**等。

图4 Actor-Critic架构图

5.深度强化学习的应用领域

-

游戏:深度强化学习在游戏中取得了显著成绩,如AlphaGo、Dota2和Atari游戏。通过DRL,AI可以在极短时间内超越人类玩家的水平。

-

自动驾驶:深度强化学习在自动驾驶中用于车辆的导航和决策。车辆通过分析环境图像和传感器数据,逐步学习如何安全高效地行驶。

-

机器人控制:机器人使用深度强化学习来实现自主运动和操控物体。通过在模拟环境中学习,机器人可以更快适应现实环境的变化。

-

金融和投资:DRL在股票和商品交易等领域应用广泛,通过对市场数据的分析,DRL算法可以自主制定投资策略,以实现收益最大化。

6.深度强化学习的挑战与未来

-

样本效率:深度强化学习需要大量样本进行训练,在某些应用场景中,样本的获取成本较高。

-

探索-开发平衡:DRL中探索和开发的平衡非常重要,过度探索会浪费资源,而过度开发则可能导致智能体陷入局部最优解。

-

环境的随机性和不确定性:在许多应用中,环境具有很强的随机性(如金融市场),DRL在应对这些复杂环境时仍有很大挑战。

尽管如此,随着硬件的发展和算法的不断创新,DRL仍具有巨大的潜力。未来,DRL可能会在更多领域产生深远影响,如个性化推荐、医疗健康等。

7.总结

深度强化学习结合了深度学习和强化学习的优势,是一种强大而灵活的决策方法。尽管面临挑战,但其在多个领域的应用展示了其巨大的潜力和价值。对于从事AI研究的人而言,深入理解DRL的基本原理、算法和应用,不仅可以拓宽知识面,也能为未来的创新打下坚实基础。