目的:

进行了一系列实验来证明,在没有任何全连接层的情况下,具有扩展卷积的 DCNN 的性能并不比广泛使用的具有包含收缩(无零填充)卷积层和多个全连接层的混合结构的深度神经网络差。

DCNN:Deep convolutional neural networks

关注点:

为深度神经网络配备卷积结构的深度卷积神经网络(DCNN),对由一维卷积(使用一维卷积层Conv1D来提取特征)、单通道(模型的输入是一个一维信号,输入层的通道数为1)和ReLU活函数引起的 DCNN 感兴趣。

假设与前提:

DCNN没有采用全连接层

一维离散卷积的两种类型:

滤波器:

滤波器是一个序列,用向量表示,其元素

只在有限的范围内非零,即从

到

。这意味着滤波器的长度是

,因为它包括了从0到

的所有索引。

,

向量:

是一个包含

个分量的列向量,每个分量都有一个特定的值

,其中

的范围是从1到

。这个向量通常用来表示一个在整数集

上的离散信号或数据序列,其中的每个元素对应于序列中的一个特定位置。

扩张卷积(也称为零填充卷积)和收缩卷积(或不进行零填充的卷积)都是滤波器 与向量

之间的操作。

扩展卷积(零填充卷积):

扩张卷积涉及将向量 进行零填充,以便滤波器

可以应用于

的每个位置。

新向量长度:

:

的长度

:滤波器

的长度

:滤波器

的元素

:向量

的元素

求和是在从1到

的范围内进行的,这意味着滤波器

被滑动到

上的每个位置,并计算加权和。

得到的矩阵

计算过程:

收缩卷积(不进行零填充的卷积):

收缩卷积不涉及零填充,因此结果向量的长度为。这种卷积只考虑滤波器

和向量

重叠的部分。

收缩卷积的第个分量由下式给出:

这里,求和是在从

到

的范围内进行的,这意味着滤波器

被滑动到

上,并且只有当滤波器的元素与

的元素重叠时才计算加权和。

得到的矩阵

计算过程:

模型定义:

稀疏Toeplitz:

的矩阵

表示扩展卷积

的矩阵

表示收缩卷积

ReLU激活函数:

定义了ReLU(Rectified Linear Unit)激活函数,这是一种常用的非线性激活函数,用于引入非线性特性,使得DCNN能够学习复杂的函数。

DCNN的定义:

给定一组滤波器,一组偏置向量

,以及一个输出向量

,可以通过如下方式定义:

①表示输入层,即

是输入数据

②表示第k层的输出,

表示卷积操作(扩张卷积或收缩卷积),

是ReLU激活函数,

是第k层的滤波器,

是第k层的偏置向量

③表示最后一层的输出,其中

是一个权重向量,

是最后一层的激活输出

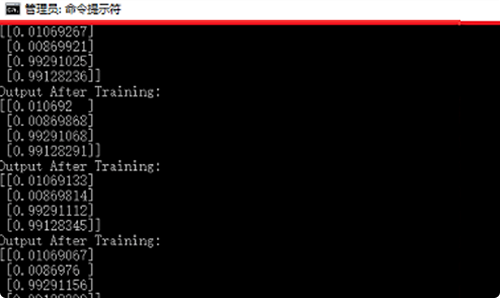

实验:

DCNN 可以被视为特殊的深度全连接神经网络

与上面给出的推导相对应

表明没有任何全连接层的eDCNN可以将任何连续函数逼近到任意精度,只要有足够多的层 。

由于 ReLU 的分段线性特性,导出了对自由参数没有任何限制的深度 ReLU 网络的严格伪维数估计。 由此,我们使用伪维度和覆盖数之间的经典关系,然后成功推导了在 eDCNN 上实现经验风险最小化(ERM)的普遍一致性。