TwinCL: A Twin Graph Contrastive Learning Model for Collaborative Filtering

摘要

在推荐和协同过滤领域,图对比学习(Graph Contrasive Learning,GCL)已经成为一种有影响的方法。然而,对比学习有效性的原因还没有得到很好的理解。本文对传统的随机扩充图结构或嵌入空间的方法提出了质疑,因为这些方法可能会破坏图神经网络的结构和语义信息.此外,固定速率的数据增强被证明与具有自适应速率的增强相比效率较低。在初始训练阶段,较大的扰动更适合,而随着训练接近收敛,较温和的扰动产生较好的结果。我们引入了一个双编码器来代替随机增强,证明了传统增强技术的冗余性。双编码器更新机制确保在早期阶段生成更多样的对比视图,随着训练的进行过渡到具有更大相似性的视图。此外,我们还从超球面上的对齐和均匀性的角度研究了学习表示,以更有效地进行优化。我们提出的孪生图对比学习模型- TwinCL -在保持超球面上嵌入的一致性的同时,对齐用户和项目嵌入的正对以及来自孪生编码器的表示。

引言

为了克服这些挑战,我们在本文中提出了一个双图对比学习模型的建议,称为TwinCL。关于第一个挑战,在追求简化GCL的协同过滤,我们放弃了传统的随机扩增应用到图结构或嵌入空间。受CL中动量更新机制[9,17]的启发,我们采用了一种使用动量更新的孪生编码器与主图编码器进行对比学习的策略。双编码器从主编码器迭代地更新自身,实现历史参数值与主编码器的当前梯度之间的平衡。这种基于孪生的模型具有在稀疏的用户-项目交互图中保留关键信息并以减少的计算操作有效地细化表示的优点。此外,它提供了不同的对比视图在初始阶段,过渡到更相似的视图在后期阶段,由于其更新机制,这被证明是有效的,以加强对比学习。关于第二个挑战,我们从[32]中推导出对齐和均匀性损失,并直接优化推荐任务,而无需负采样[44]。通过优化用户和项目嵌入内的对齐和均匀性属性,训练过程获得更快的收敛,同时表现出对过拟合的敏感性降低,从而增强鲁棒性。此外,对准和均匀性的设计,与双编码器相结合,协同有助于实现增强的性能。在最初的几个时期,模型受益于对齐和均匀性的优化,允许图形编码器更新到更合适的参数。通过从图形编码器获取更高质量的参数,双编码器可以通过从主图形编码器提取知识来迭代地细化其自身的参数,从而生成上级节点表示。

贡献:

- 我们提出了一种新的图对比学习范式TwinCL,它使用动量更新的孪生编码器,而没有对图和节点嵌入进行任何随机扩增。

- 我们将对齐和一致性的优化与我们的双图对比学习模型相结合,提高了性能,效率和对流行偏见的鲁棒性

孪生图对比学习

TwinCL利用孪生编码器生成有效的对比视图,而无需对图结构或节点表示进行扩充。此外,TwinCL利用对齐和一致性的特性来测量表示的质量,从而提高了双编码器的有效性。

现有的基于图的推荐方法通常依赖于随机扩增,这可能引入噪声并干扰图的结构和语义信息,特别是当图稀疏且用户-项目交互很少时。此外,这些方法需要反复试验选择增强方法和参数。我们需要选择一种具有适当扰动幅度的增强方法,例如辍学率[38]或噪声率[42,48]。然而,我们注意到,增强的最佳丢弃率或噪声率根据训练时期和迭代而不同。在训练的初始阶段,采用较高的丢弃率或扰动导致增强的对比学习结果。然而,随着模型达到一定数量的时期,为了减轻过拟合并促进进一步的改进,降低丢失率变得合乎需要,从而促进增强视图之间的更大相似性并实现上级结果。为了减轻固定丢弃率的不利影响,另一种方法涉及使用可学习的神经生成器[16]来创建对比视图。然而,这种方法在协同过滤场景中可能不是有效的,因为训练额外的生成器可能是繁重的。我们的目标是确定一种计算效率高的方法,并允许在训练的早期阶段进行较大的扰动,在后期阶段过渡到较稳定的扰动。

此外,GCL模型中对齐和一致性优化的未充分利用代表了改进推荐性能的未开发机会。大多数现有的GCL方法[23,42,48]只是分析学习表示的对齐和一致性,而没有利用这些属性。因此,我们的研究致力于设计一种GCL模型,该模型放弃了随机增强,有利于直接优化对齐和均匀性,寻求克服数据稀疏性,并在训练的早期阶段受到显著扰动时增强鲁棒性。

预备知识

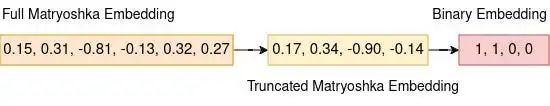

1. 对齐、均匀

在对比学习领域,对齐和均匀性被认为是衡量表征质量的两个关键属性。给定一个正对的分布,对齐被定义为对比学习中正对的归一化嵌入之间的期望距离。

换句话说,均匀性是嵌入分布均匀程度的度量。

对齐和一致性度量非常适合对比学习的中心目标:正实例的嵌入应该彼此靠近,而随机实例的嵌入应该分散在超球面上。此外,这两个指标同样与协同过滤密切相关[32],其中用户感兴趣的项目可以与用户形成正对。这里类似地,正用户-项目对的归一化嵌入应该保持接近,而所有用户和项目的归一化嵌入应该均匀分布在超球体上:

孪生图对比学习

动机

现有的基于图的推荐方法通常依赖于随机增强,这会引入噪声并干扰图的结构和语义信息,特别是当图稀疏且用户-项目交互很少时。此外,这些方法需要反复试验选择增强方法和参数。我们需要选择一种具有适当扰动幅度的增强方法,例如丢弃率[38]或噪声率[42,48]。然而,我们注意到,用于增强的最佳丢弃率或噪声率取决于训练时期和迭代而不同。在训练的初始阶段,采用较高的丢弃率或扰动导致增强的对比学习结果。然而,随着模型达到一定数量的时期,为了减轻过拟合并促进进一步的改进,降低丢失率变得合乎需要,从而促进增强视图之间的更大相似性并实现上级结果。为了减轻固定丢弃率的不利影响,另一种方法涉及使用可学习的神经生成器[16]来创建对比视图。然而,这种方法在协同过滤场景中可能效率不高,因为训练额外的生成器可能很繁重。

我们的目标是确定一种计算效率高的方法,并允许在训练的早期阶段进行较大的扰动,在后期阶段过渡到较温和的扰动。此外,GCL模型中对齐和一致性优化的未充分利用代表了改进推荐性能的未开发机会。大多数现有的GCL方法[23,42,48]只是分析学习表示的对齐和一致性,而没有利用这些属性。因此,我们的研究致力于设计一种GCL模型,该模型放弃了随机增强,有利于直接优化对齐和均匀性,寻求克服数据稀疏性,并在训练的早期阶段受到显著扰动时增强鲁棒性。

双编码器

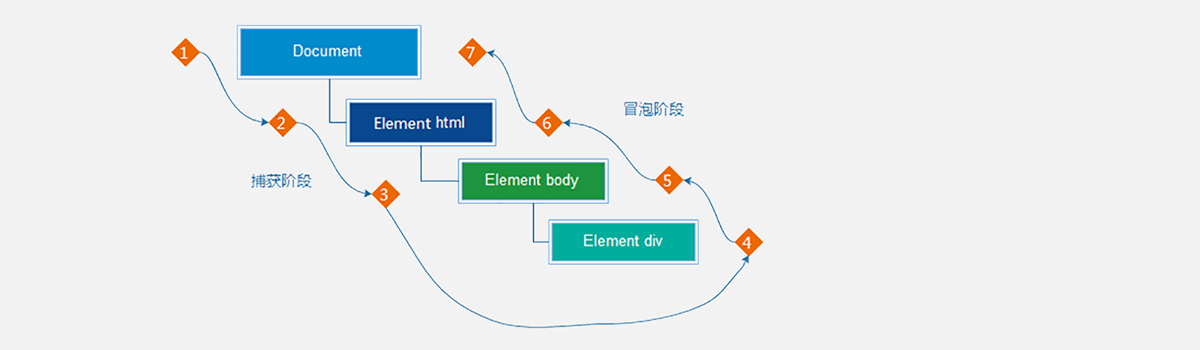

双编码器更新机制

主编码器通过梯度来训练模型参数,孪生网络不需要训练,每次从主网络中来拷贝部分参数来优化孪生网络。

双编码器更新机制保证了双编码器之间的多样性,并在训练的早期阶段生成对比视图。随着模型接近收敛,双编码器之间的相似性显著增加。与固定速率扰动方法相比,该功能增强了对比学习的性能,同时还确保了对比视图的有效生成。

主编码其和其孪生网络通过图编码器生成用户、物品嵌入,用于对比学习。

对比学习

主编码器和孪生编码器之间的对比学习是为了最大化由双编码器和双编码器生成的正对的表示之间的相似性,同时鼓励嵌入空间中的均匀性。

对齐和均匀性优化

本文深入研究了如何为我们的协同过滤模型调整对齐和一致性的优化的细节。在传统的推荐系统中,贝叶斯个性化排序(BPR)[28]损失是优化项目排序的流行选择。但是,它也有自己的一系列限制,主要是由于它对负采样的敏感性以及捕获复杂的用户-项目交互的困难。负采样的性能可能会受到采样负样本的低质量和缓慢收敛的影响。为了克服这些限制,我们的模型采用了两种主要的优化损失。对齐损失确保了图中相似用户和项目的嵌入在表示空间中更接近,从而导致更准确的推荐。均匀性损失确保嵌入均匀地分布在表示空间上,从而减少模型过度拟合特定项目或用户类别的机会,并使模型更加稳健和可推广。

bpr损失

当用户和项目的正对表示具有完美对齐且所有表示在超球面上均匀分布时,BPR损失最小.因此,对齐和均匀性损失可以替代BPR损失来优化推荐模型。通过直接优化对齐损失Lalign和均匀性损失Luniform,该模型在保证正用户-项目对的均匀分布的同时,内在地对齐了正用户-项目对的嵌入,从而得到了比依赖于BPR损失的传统方法更丰富的表示。

TwinCL 算法