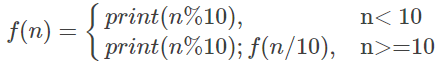

在 Spark 中,RDD 的 checkpoint 是一种容错机制,用于将 RDD 的数据保存到可靠的存储系统(如 HDFS)中,以便在节点故障时可以从存储中重新加载数据,而不是重新计算依赖链。

RDD Checkpoint 数据的保存格式

-

数据保存格式

- 默认格式:序列化文件(Sequence File 格式)

- Checkpoint 数据以 Spark 的序列化形式存储在存储系统中。

- 底层实现采用 Hadoop 的 Sequence File,这是一种键值对存储格式。

- Key:表示 RDD 的分区索引。

- Value:表示该分区中存储的数据。

- 默认格式:序列化文件(Sequence File 格式)

-

序列化方式

- 数据会按照 Spark 的 序列化机制保存(如 Kryo 或 Java 序列化)。

- 具体使用哪种序列化方式,取决于 Spark 配置中的

spark.serializer参数:- Java 序列化:默认的序列化方式。

- Kryo 序列化:推荐的高效序列化方式,需要用户在配置中显式启用。

-

存储位置

- 数据会被存储到配置的 checkpoint 目录中。

- 默认使用的存储系统通常是 HDFS 或其他可靠的分布式文件系统(如 S3)。

Checkpoint 数据保存的机制

-

触发保存

- 当对 RDD 调用

RDD.checkpoint()方法时,Spark 会在行动操作(如count()或collect())触发计算时将 RDD 的数据写入 checkpoint 目录。

- 当对 RDD 调用

-

存储过程

- Spark 在对每个分区数据完成计算后,将该分区的数据序列化并保存到 checkpoint 目录下的文件中。

- 每个 RDD 分区对应一个单独的文件,文件名中包含分区 ID。

-

文件命名

- Checkpoint 数据的文件名通常遵循以下模式:

<checkpointDir>/<RDD_ID>/part-<partition_ID>- :用户配置的 checkpoint 目录。

- <RDD_ID>:该 RDD 的唯一标识。

- <partition_ID>:RDD 的分区 ID。

- Checkpoint 数据的文件名通常遵循以下模式:

-

持久化标记

- Checkpoint 完成后,RDD 的依赖关系会被丢弃,RDD 的父依赖链被替换为存储在 checkpoint 目录中的数据文件路径。

示例

以下是一个简单的示例,展示 RDD checkpoint 的工作过程:

代码

import org.apache.spark.{SparkConf, SparkContext}// 配置 Spark 和 checkpoint 目录

val conf = new SparkConf().setAppName("RDD Checkpoint Example").setMaster("local")

val sc = new SparkContext(conf)// 设置 checkpoint 目录

sc.setCheckpointDir("hdfs://localhost:9000/checkpoints")// 创建 RDD 并执行 checkpoint

val rdd = sc.parallelize(1 to 10).map(x => x * x)

rdd.checkpoint()// 执行动作操作,触发 checkpoint

println(rdd.collect().mkString(","))

生成的 checkpoint 文件

假设 checkpoint 目录为 hdfs://localhost:9000/checkpoints,可能的文件结构如下:

hdfs://localhost:9000/checkpoints/|- RDD_ID_1/|- part-00000|- part-00001

RDD_ID_1是 Spark 自动分配的 RDD 唯一标识。- 每个

part-XXXXX文件存储一个分区的数据,使用序列化格式。

与 Persist 的区别

| 特性 | Checkpoint | Persist |

|---|---|---|

| 存储位置 | 持久化到可靠存储系统(如 HDFS)。 | 存储在内存或磁盘中(节点本地)。 |

| 序列化方式 | 默认采用 Sequence File 格式。 | 可以基于存储级别选择是否序列化。 |

| 依赖链 | Checkpoint 后会丢弃 RDD 的依赖链。 | Persist 保留 RDD 的依赖链。 |

| 容错能力 | 支持重新加载(从 checkpoint 目录恢复)。 | 如果节点失败,可能需要重新计算依赖链。 |

优化与注意事项

-

选择合适的存储系统

- 推荐使用 HDFS 或其他可靠的分布式文件系统作为 checkpoint 目录。

- 本地文件系统可以用于测试,但不建议用于生产环境。

-

与 Persist 配合使用

- RDD 在 checkpoint 之前需要被计算,使用

persist()(如 MEMORY_AND_DISK)可以避免重复计算开销。

- RDD 在 checkpoint 之前需要被计算,使用

-

序列化优化

- 配置高效序列化机制(如 Kryo),提升序列化与存储的性能:

spark.serializer=org.apache.spark.serializer.KryoSerializer

- 配置高效序列化机制(如 Kryo),提升序列化与存储的性能:

-

性能权衡

- Checkpoint 会引入 I/O 开销,仅在需要容错能力时使用。

- 对于容错需求不高的场景,可以仅使用 persist 或 cache。

总结:RDD checkpoint 的数据以 Sequence File 格式存储,序列化后的数据会保存在可靠的分布式存储系统中。它适用于需要高容错性的场景,同时对计算成本较高的 RDD 提供了中间结果保存的能力。