Abstract

大多数视觉注意力模型旨在预测自上而下或自下而上的控制,这些控制通过不同的视觉搜索和自由观看任务进行研究。本文提出了人类注意力变换器(Human Attention Transformer,HAT),这是一个能够预测两种形式注意力控制的单一模型。HAT采用了一种新型的基于变换器的架构和简化的视网膜模型,这些共同构建了一种类似于人类动态视觉工作记忆的时空意识。HAT不仅在预测目标呈现和目标缺失视觉搜索中的注视扫描路径以及“无任务”自由观看中表现出色,成为新一代最先进的技术,还使人类注视行为变得可解释。与依赖粗略网格的注视单元并由于注视离散化而导致信息丢失的先前方法不同,HAT采用了顺序密集预测架构,并为每个注视点输出密集热图,从而避免了注视离散化。HAT设定了计算注意力的新标准,强调了其有效性、通用性和可解释性。HAT的广泛适用性和应用范围有望激发新型注意力模型的开发,这些模型能够更好地预测人类在各种需求注意力的场景中的行为。代码可在 GitHub - cvlab-stonybrook/HAT: CVPR 2024 "Unifying Top-down and Bottom-up Scanpath Prediction Using Transformers"

Introduction

注意力是一个认知过程,使人类能够将有限的认知资源选择性地分配到视觉世界的特定区域,这在人体感知系统中发挥着至关重要的作用。理解和预测人类(视觉)注意力将带来许多应用,例如:能够预测个人需求和意图的辅助技术,能够优先处理人类关注区域的感知系统,提升各种视觉任务(如物体检测)的准确性和速度,以及图像/视频压缩技术,能够将更多资源分配给编码和传输高关注区域,从而优化带宽的使用。

人类注意力控制可以分为两种广泛的形式。一种是自下而上的注意力,这意味着注意力显著性信号是从视觉输入中计算出来的,并用于优先考虑注意力的转移。因此,相同的视觉输入应导致相同的自下而上的注意力转移。第二种注意力是自上而下的,这意味着任务或目标用于控制注意力。以厨房场景为例,搜索钟表或微波炉时,人们的注视点会有所不同。这两种类型的注意力控制产生了两种不同的注视点预测文献,一种使用自由观察任务研究自下而上的注意力,另一种使用目标导向任务(通常是视觉搜索)研究自上而下的注意力控制。因此,大多数模型旨在解决自下而上或自上而下的注意力,而不是两者兼顾。一个模型架构能否预测这两种注意力控制?

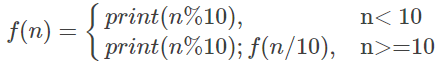

图1。给定图像,所提出的HAT能够在目标存在预测扫描路径;目标不存在扫描路径;自由观看。重要的是,HAT 在三个设置中在多个数据集上优于以前的最先进的扫描路径预测方法:目标存在、目标缺失视觉搜索和自由观看,分别进行了研究。

我们对这个问题的回答是HAT(人类注意力变换器),它能够预测注视路径,即可以应用于自上而下的视觉搜索和自下而上的自由观察任务(图一)。设计一个能够预测自下而上和自上而下注意力控制的统一模型架构并非易事:1)预测人类注视路径需要模型对注视图像内容及其与外部目标的关系具有时空理解;2)预测自上而下和自下而上的注意力需要模型捕捉输入图像的低级特征和高级语义。HAT通过采用一种新型变换器设计和简化的中心凹视网膜来解决这些问题。结合这两个组件,形成了一种新的范式,构成一种动态更新的视觉工作记忆。传统方法依赖循环神经网络(RNN)来维持动态更新的隐藏向量,从而在注视之间传递信息。然而,这些方法存在缺陷:RNN牺牲了解释性,而多分辨率模拟在捕捉对注视路径预测至关重要的时间和空间信息方面表现不佳。

为了解决这些挑战,我们利用计算注意力机制动态地将每次注视获取的空间、时间和视觉信息整合到工作记忆中。这使得HAT能够辨别一组特定任务的注意力权重,以整合工作记忆中的信息并预测人类的注意力控制。这一创新机制揭示了人类注意力与工作记忆之间复杂的关系,使HAT不仅在认知上合理,而且确保了其预测的可解释性。此外,与之前的方法相比,HAT将注视路径预测视为一系列密集预测任务,采用每像素监督,成功避免了注视离散化的需求。这提高了该方法在高分辨率图像场景中的有效性。为了展示HAT的通用性,我们在三种设置下预测注视路径:目标存在(TP)、目标缺失(TA)视觉搜索和自由观察(FV),涵盖了自上而下和自下而上的注意力。在之前的工作中,预测搜索路径时,为TP和TA设置分别训练了不同的模型。而HAT是一个单一模型,在TP和TA搜索路径预测中都建立了新的最先进的水平。当用FV路径训练时,HAT相对于基准模型也取得了顶尖表现。在COCO-Search18数据集和COCO-FreeView数据集上,HAT在TP、TA和FV设置下的cNSS(注意力神经信号)分别提高了95%、94%和104%。

我们的贡献可以总结如下:

- 我们提出了HAT,一种新型的变换器架构,通过整合两种不同偏心度的视觉信息(近似视网膜中心凹)来预测人类注意力的空间和时间分配。

- 我们将扫描路径预测问题形式化为一个顺序密集预测任务,避免了注视离散化,使得HAT可以应用于高分辨率输入。

- HAT架构可以广泛应用于不同的注意力控制任务,且在视觉搜索和自由观看任务中的扫描路径预测达到了最先进水平。

- HAT的注意力预测具有很高的可解释性,适用于研究注视行为。

Related Work

注意力显著性预测:预测和理解人类注视控制在心理学中已经是一个关注了数十年的主题,但最近才引起计算机视觉领域研究者的关注。特别是Itti的开创性工作引发了计算机视觉社区对人类注意力建模的广泛兴趣,并推动了许多研究,识别和建模图像的显著视觉特征(即显著性预测)。然而,这些研究通常狭隘地集中在无特定视觉任务的自然眼动预测(即自由观看),忽视了另一种重要的注意力控制形式——目标导向注意力。此外,显著性模型仅建模注视的空间分布,而不预测注视之间的时间顺序。扫描路径预测是一个更具挑战性的问题,因为它不仅需要预测注视的位置,还需要预测注视的时间。

扫描路径预测:许多现有的扫描路径预测深度神经网络主要集中于预测自由观看的扫描路径,这主要是由于其与显著性建模的紧密联系。然而,这些模型在捕捉人类注意力控制的完整谱系方面受到限制,尤其是目标导向注意力——一种基础的认知过程,支持日常视觉任务,如导航和运动控制。尽管目标导向人类注意力在认知科学中研究已久(主要是在视觉搜索的背景下),但针对目标导向扫描路径预测的深度神经网络的发展滞后于自由观看任务模型,部分原因是缺乏数据。为了解决这一问题,Chen等人创建了第一个大型目标导向注视数据集COCO-Search18。在相关研究中,一种逆强化学习模型在COCO-Search18上展示了对目标存在扫描路径的优秀预测性能。随后,Chen等人展示了一种直接优化扫描路径相似度指标的强化学习模型,可以预测视觉问答(VQA)扫描路径以及目标存在的搜索扫描路径。最近,Gazeformer,一个基于变换器的扫描路径预测模型,进一步提升了COCO-Search18上目标存在搜索扫描路径的预测性能。然而,这些研究都未能展示对三种设置(即目标存在、目标不存在和自由观看)的普遍性。在本工作中,我们设计了一种通用的扫描路径模型,能够推广到自由观看和视觉搜索任务。

扫描路径变换器:变换器的变革性影响在自然语言处理及其他领域被广泛认可。在计算机视觉中,变换器在图像识别、目标检测和图像分割等任务中表现出色。Mondal等人介绍了Gazeformer,一个专门设计用于零-shot视觉搜索扫描路径预测的变换器模型。相比之下,我们提出的模型是通用的,能够预测视觉搜索和自由观看的扫描路径。此外,我们的模型与其他基于变换器的架构不同,受到人类视觉系统的启发,包含一个新颖的视网膜模块,模拟简化的中央凹视网膜,从而建立一个动态视觉工作记忆,以增强扫描路径预测。

Human Attention Transformer

在本节中,我们首先将扫描路径预测公式化为一系列密集预测任务,使用行为克隆的方法。然后,我们介绍我们提出的基于变换器的模型 HAT,用于扫描路径预测。最后,我们描述如何训练 HAT 以及如何进行快速推断

Preliminaries

为了避免先前注视预测方法中由于网格离散化导致的精度损失 [10, 62, 63, 66],我们将扫描路径预测公式化为像素坐标的序列预测。给定一个 H×W 的图像和一个可选的初始注视点 f0(通常设为图像的中心),扫描路径预测模型预测一系列类似人类的注视位置 f1, ···, fn,其中每个注视点 fi 是图像中的一个像素位置。需要注意的是,n 是可变的,对于不同的人类受试者,由于终止标准不同,可能会有不同的值。

为了建模人类注意力分配的不确定性,现有方法 [10, 62, 63, 66] 通常在每一步预测一个粗糙网格上注视位置的概率分布。HAT 采用相同的思路,但输出一个密集的注视热图。具体来说,HAT 输出一个热图 Yi ∈ [0, 1]H×W,每个像素值表示下一个注视中该像素被注视的概率。此外,HAT 还输出一个终止概率 τi ∈ [0, 1],表示模型在当前步骤 i 终止扫描路径的可能性。为了采样一个注视点,我们对 Yi 应用 L1 归一化。以下内容中,我们为了简洁起见省略下标 i。

Network Architecture

图2. HAT概述。

1. 特征提取编码器-解码器 CNNs:使用这种结构来提取图像的特征图。特征图 P1 和 P4:分别代表不同的空间分辨率。P4:通常是高分辨率特征图,捕捉图像的细节信息。P1:较低分辨率特征图,提供更广泛的背景信息。

2. 工作记忆工作记忆容量:设计为 λ 个标记(tokens),模拟人类的短期记忆,能够存储与当前视觉任务相关的信息。信息结合:来自 P1 的特征向量:更广泛的背景信息。来自 P4 的特征向量:源自之前注视的位置。中央注视点与周边视野:通过结合这两类信息,模型能够更好地理解当前场景的上下文。

3. 动态更新机制变换器编码器:每当新的注视点出现时,模型使用变换器编码器来动态更新工作记忆。这意味着模型可以根据视觉输入的变化迅速调整其对环境的理解。

4. 任务特定查询生成 N 个查询:针对不同的任务(例如,寻找时钟或鼠标),模型生成多个查询。查询的维度 C:表示每个任务特定的特征。聚合任务特定信息:每个查询会从共享的工作记忆中提取与其任务相关的信息,从而更准确地预测相应的注视点。

5. 热图生成卷积处理:更新后的查询与 P4 进行卷积操作,以生成注视热图。多层感知器(MLP)层:经过 MLP 层处理后,热图显示了可能的注视点位置。终止概率的投影:热图进一步被转换为终止概率,表示在特定位置停止注视的可能性。

6. 适用范围视觉搜索与自由观看:虽然该图主要展示了视觉搜索的情况,但 HAT 模型同样适用于自由观看任务。这种灵活性表明模型能够适应多种视觉任务,展现出广泛的应用潜力。

Training and Inference