当输入一系列向量,想要考虑其中一个向量与其他向量之间的关系,决定这个向量最后的输出

任意两个向量之间的关系计算

计算其他向量对a1的关联性

多头注意力机制

图像也可以看成一系列的向量,交给自注意力机制处理,CNN是特殊的自注意力机制。

RNN跟自注意力机制也有关。

seq2seq model

multi-class classification 从多个类中选择一个类

multi-lable classification 一个物体可能属于多个类

FC:fully connect

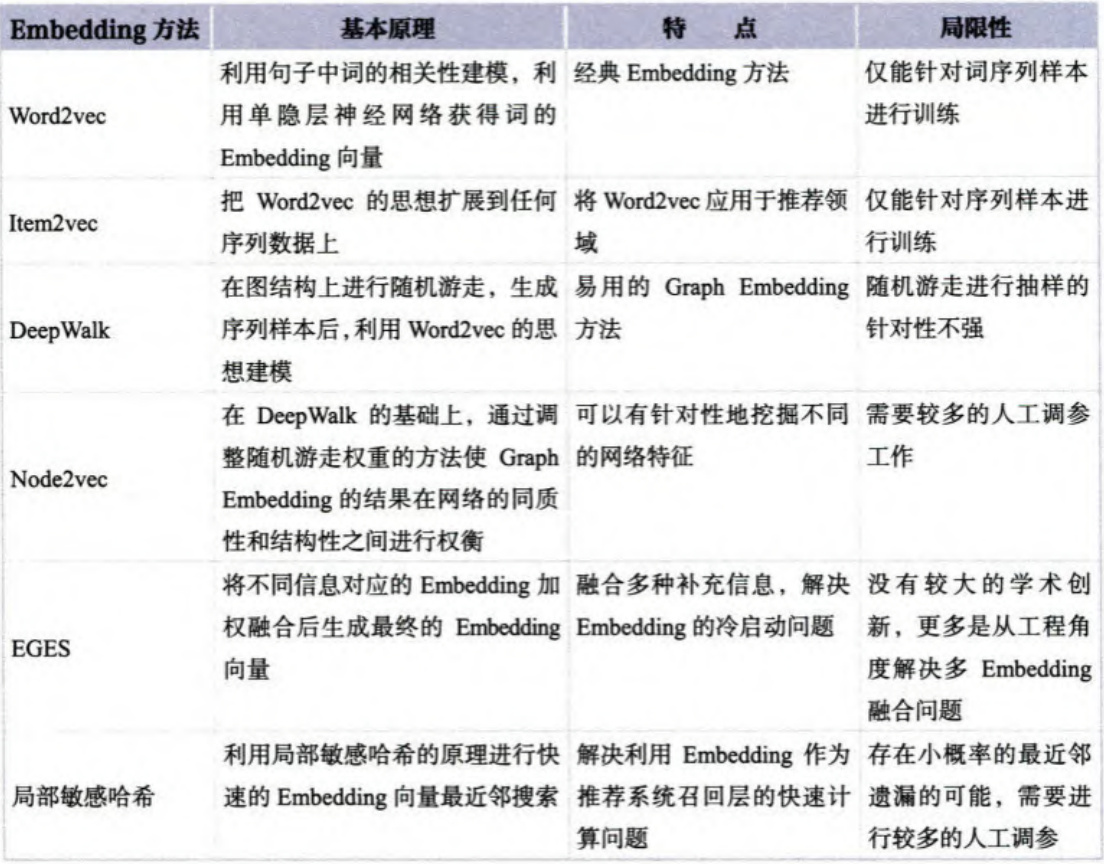

transformer encoder 架构

最初的编码模型:

变形:

解码:需要自己决定输出的长度

解码器会将自己在前一个阶段的输出当作输入。

编码器和解码器之间的差距:

masked的区别在于,对于目标向量,只考虑其左边的,因为解码器是一个一个输出的,在没有前面数据的时候,后边数据不可能出现。

自回归编码和非自回归编码(AT/NAT)

编码器和解码器之间的连接:

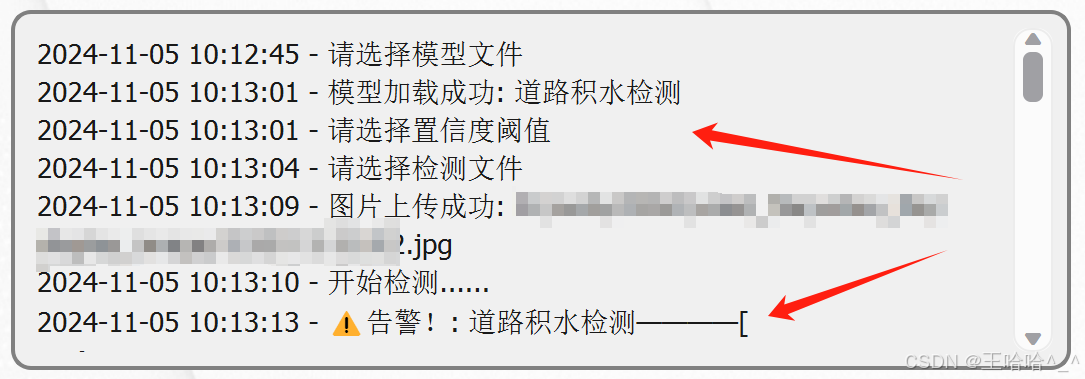

训练的时候:teacher forcing:用真实数据作为输入,为了防止解码器在测试阶段,容错率低,可以在真实数据中加入一点错误。