一、介绍

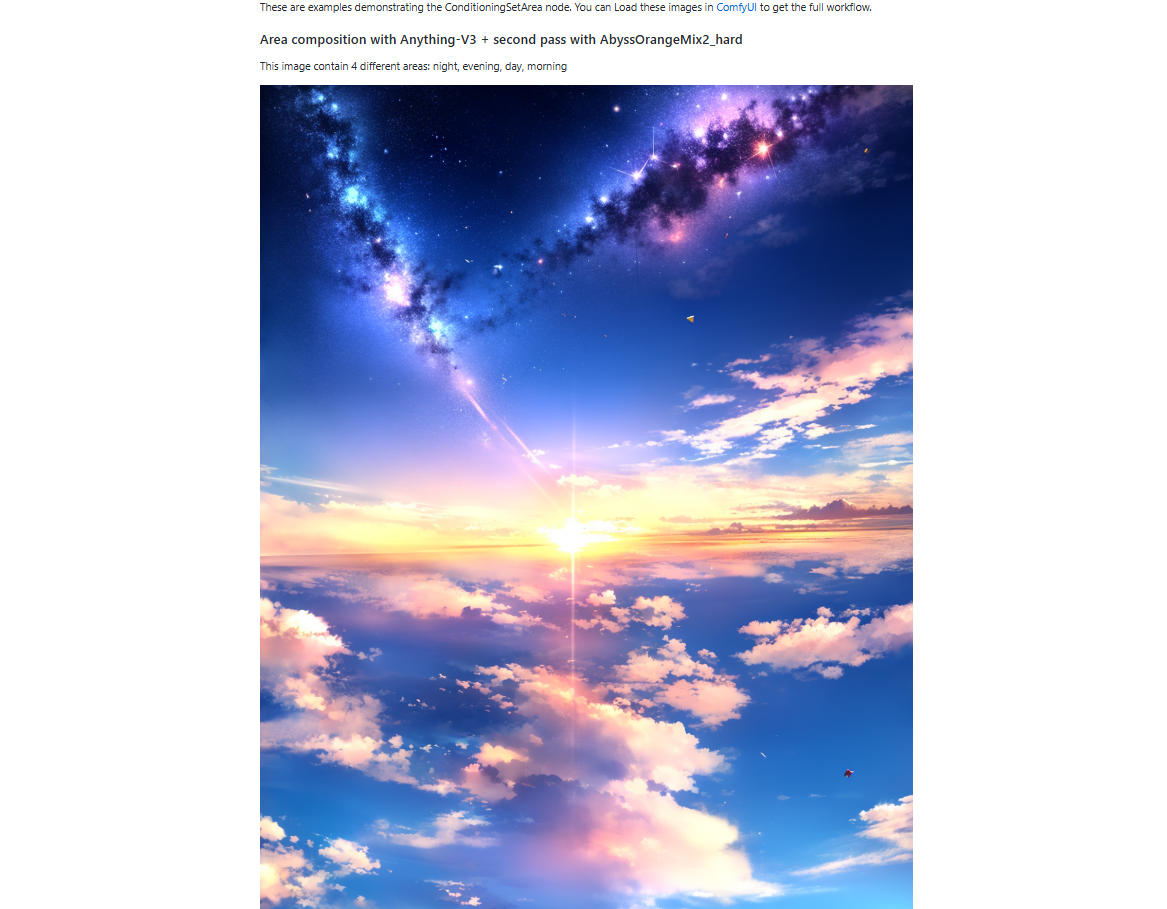

本模型可以通过输入不同的提示词,然后根据各部分提示词进行融合生成图片。如下图:

此图像包含 4 个不同的区域:夜晚、傍晚、白天、早晨

二、部署

环境要求:

最低显存:10G

1. 部署ComfyUI

本篇的模型部署是在ComfyUI的基础上进行,如果没有部署过ComfyUI,请按照下面流程先进行部署,如已安装请跳过该步:

(1)使用命令克隆 ComfyUI

git clone https://github.com/comfyanonymous/ComfyUI.git

cd ComfyUI

(2)安装 conda(如已安装则跳过)

下面需要使用 Anaconda 或 Mimiconda 创建虚拟环境,可以输入 conda --version 进行检查。下面是 Mimiconda 的安装过程:

- 下载 Miniconda 安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

- 运行安装脚本

bash Miniconda3-latest-Linux-x86_64.sh

- 遵循安装提示并初始化

按 Enter 键查看许可证条款,阅读完毕后输入 yes 接受条款,安装完成后,脚本会询问是否初始化 conda 环境,输入 yes 并按 Enter 键。

- 运行

source ~/.bashrc命令激活 conda 环境 - 再次输入

conda --version命令来验证是否安装成功,如果出现类似conda 4.10.3这样的输出就成功了。

(3)创建虚拟环境

输入下面的命令:

conda create -n comfyui

conda activate comfyui

(4)安装 pytorch

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu121

(5)安装项目依赖

pip install -r requirements.txt

此时所需环境就已经搭建完成,通过下面命令进行启动:

python main.py

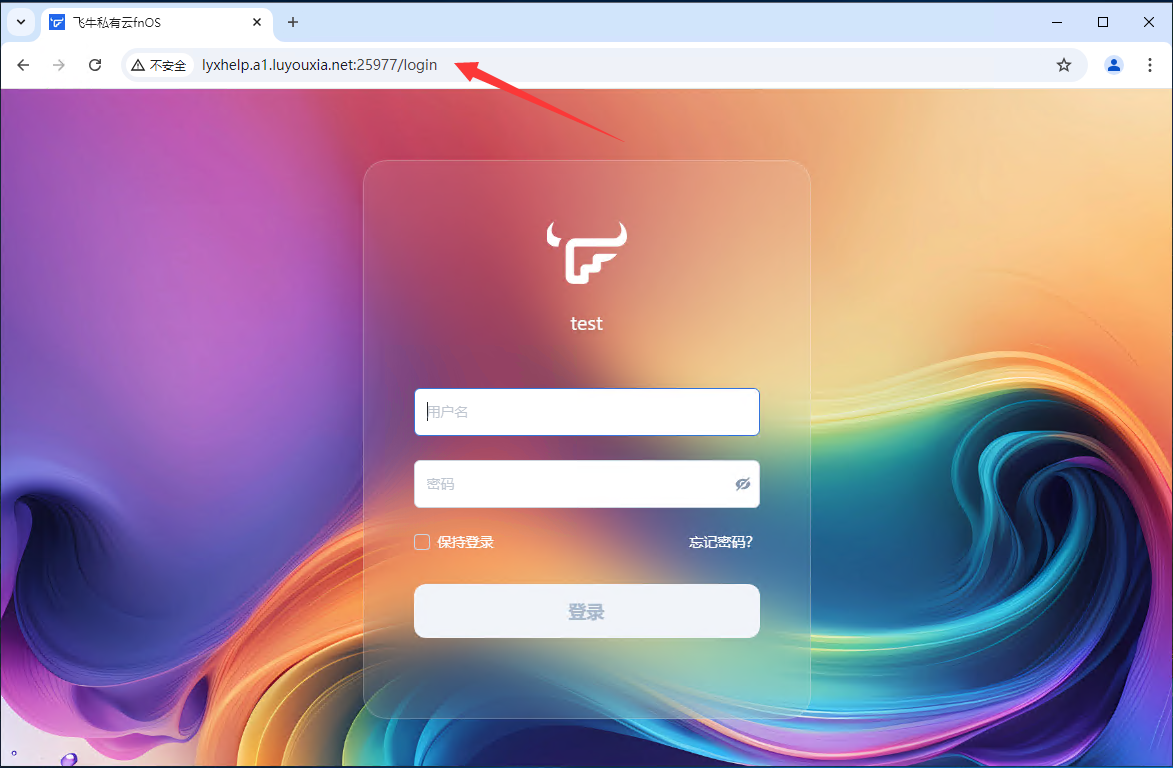

访问网址得到类似下图界面即表示成功启动:

到这里Comfy UI就初步搭建好了(这里只是简单实现ComfyUI的基础功能,如果想要安装更多细节,请看我“Comfy UI”部署教程)

2. 部署Area Composition模型

(1)下载模型

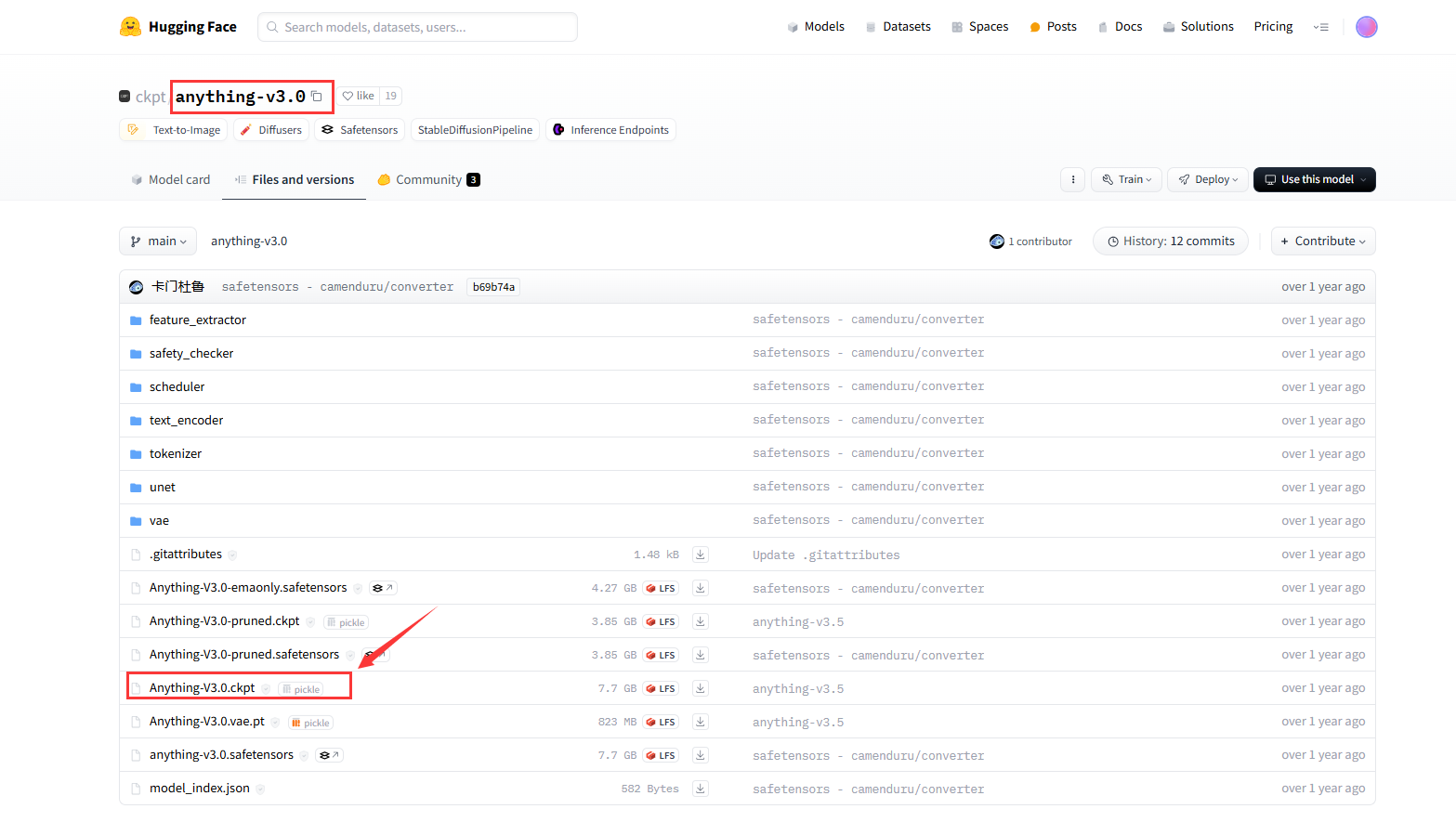

在hugging face搜索“anything-v3.0”然后下载图中模型到 /ComfyUI/model/chekpoints/下

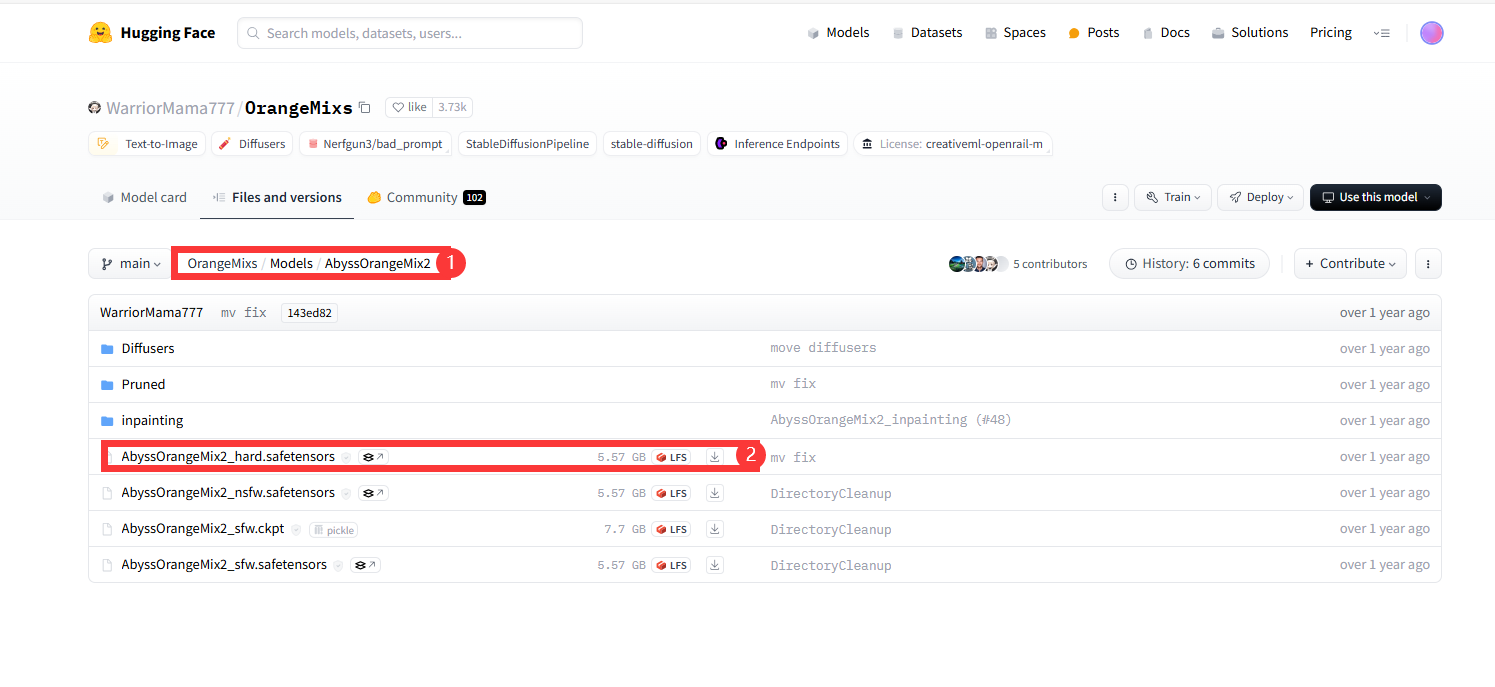

在hugging face搜索“WarriorMama777/OrangeMixs”然后按下图中①的路径找到模型②并下载到 /ComfyUI/model/chekpoints/下

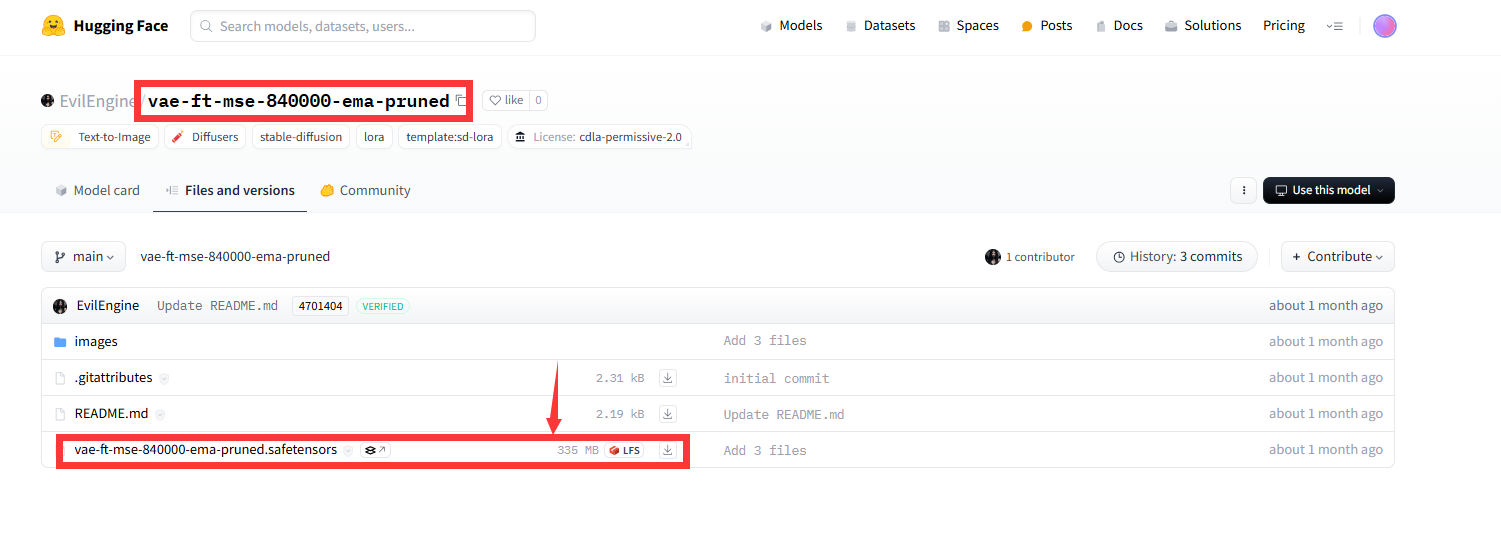

在hugging face搜索“EvilEngine/vae-ft-mse-840000-ema-pruned”然后按下图中模型下载到 /ComfyUI/model/VAE/下

(2)下载工作流

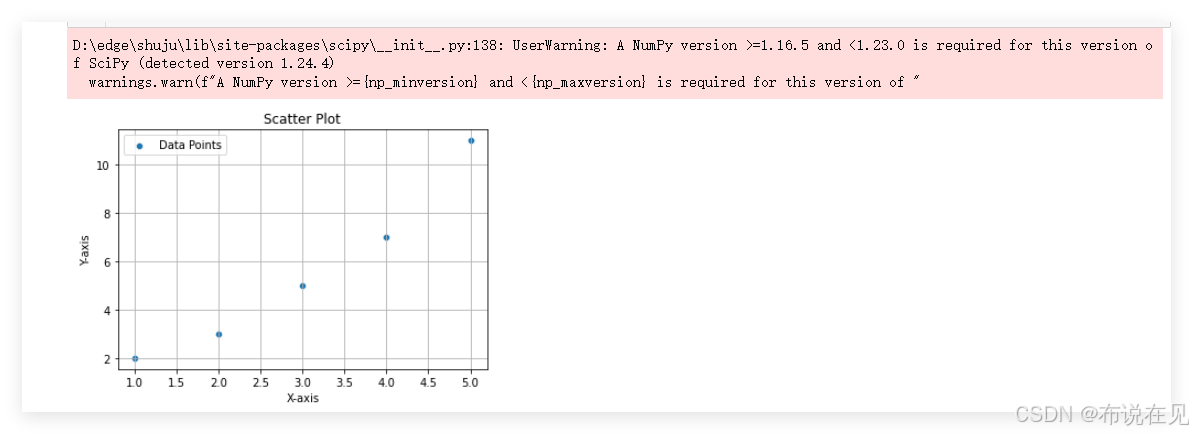

进入网站:Area Composition Examples | ComfyUI_examples (comfyanonymous.github.io))并将下图下载,然后拖入Comfy UI中:

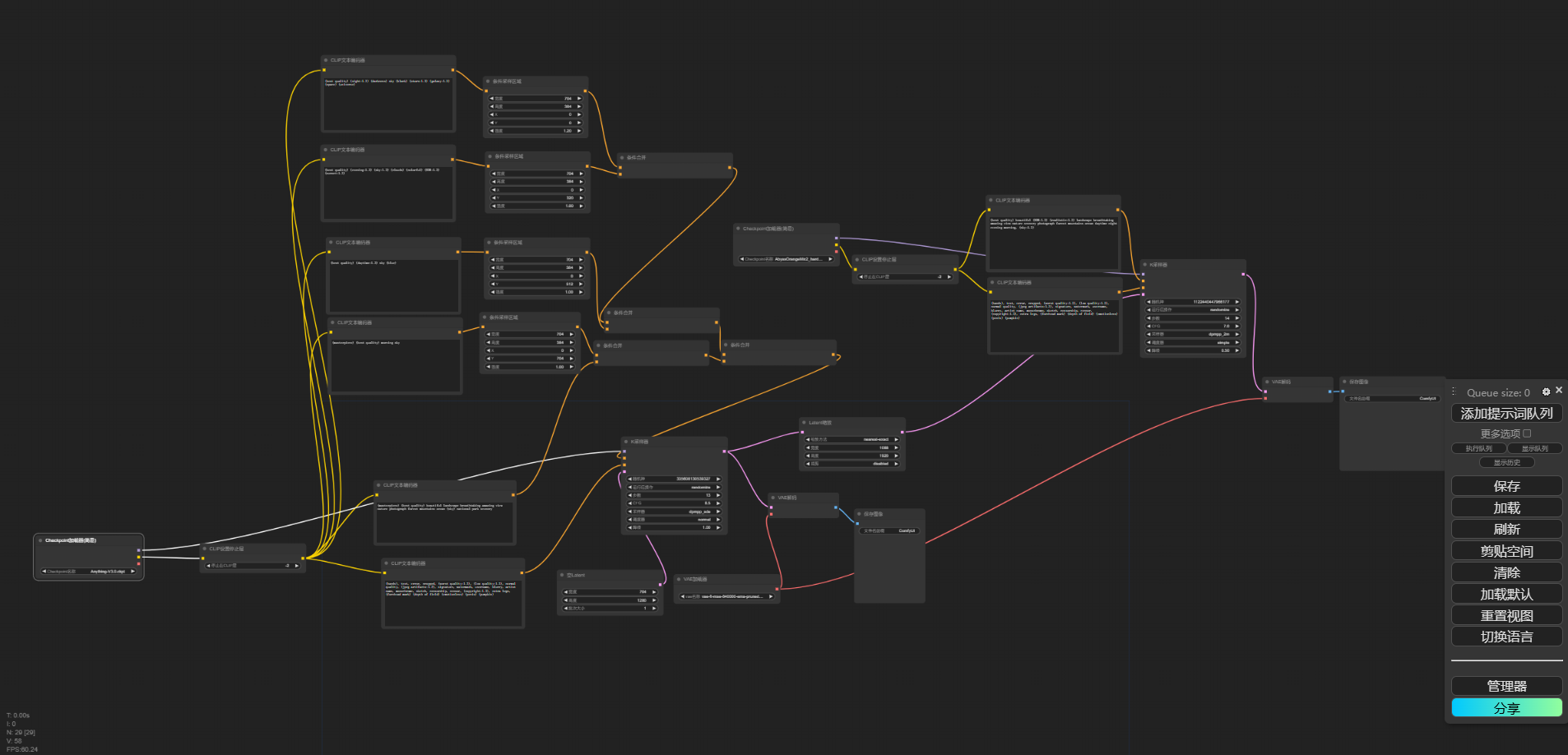

然后你的ComfyUI中应该会出选相应的工作流,类似下图:

至此模型就部署完成。