一、前言

1.1 Ollama介绍

Ollama是一个专为在本地环境中运行和定制大型语言模型而设计的工具。它提供了一个简单而高效的接口,用于创建、运行和管理这些模型,同时还提供了一个丰富的预构建模型库,可以轻松集成到各种应用程序中。Ollama的目标是使大型语言模型的部署和交互变得简单,无论是对于开发者还是对于终端用户。

1.2 支持的操作系统

Ollama支持多种操作系统和Docker,包括但不限于:

macOS:适用于所有现代版本的macOS。

Linux:支持多种Linux发行版,如Ubuntu、Fedora等。

Windows:支持Windows 10及更高版本。

Docker:通过Docker容器,Ollama可以在几乎任何支持Docker的环境中运行。

这种广泛的操作系统支持确保了Ollama的可用性和灵活性,使得不同环境下的用户都能轻松使用。当然如果想在linux下部署Ollama,可以去我的另一篇博文亲测:windows系统本地Docker部署LLM应用开发平台dify加实战详细教程

里查看,里面有介绍到

二、Ollama的安装

2.1 方法一:官网渠道安装文件获取

我们去官方网页:https://ollama.com/download/windows

直接点击 按钮下载Windows版本

注:官方的windows包不是很稳定,没登录下载容易报错。一直这种情况,可以试试更换梯子。一直解决不了请采用 方法二:百度网盘下载

2.2 方法二:百度网盘获取安装文件

文件我放在我的百度网盘了,有需要的朋友,可以关注的我公众号【终极量化数据】,回复ollama下载

2.3 运行安装

运行安装程序:下载完成后,运行安装包,按照提示完成安装即可,没有需要特别注意的地方。

这里诟病的是 不能选安装路径

2.4 验证安装成功

安装成功后,我们打开cmd命令行或者 power shell 执行 ollama --version

正常显示版本,安装成功了

三、Ollama的使用

3.1 修改配置

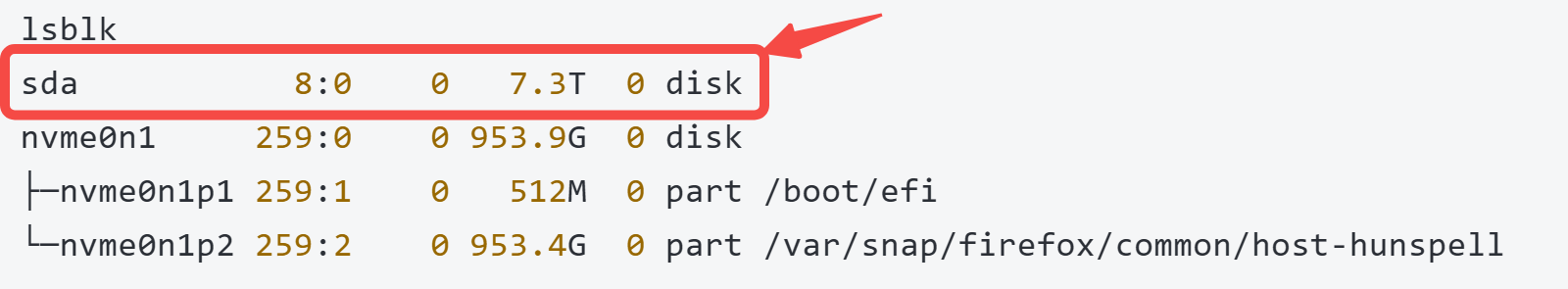

在使用Ollama前,我们要修改模型存放位置,因为模型都比较大,不然默认c盘,很快就把系统盘占用满了。

ollama默认的模型保存路劲是:C:\Users\%username%\.ollama\models

我们在电脑或服务器容量充足的磁盘,新建一个文件夹 olamaCache

然后打开系统设置 新建环境变量OLLAMA_MODELS,填入刚创建的文件夹地址

接下来,我们打开任务管理器,结束Ollama的2个进程

结束进程后,我们在开始菜单找到Ollama,打开即可使用了

3.2 拉取并运行模型

我们在power shell执行 拉取命令,这里我拉取的模型是 llava

如果遇到超时报错,就多试几次

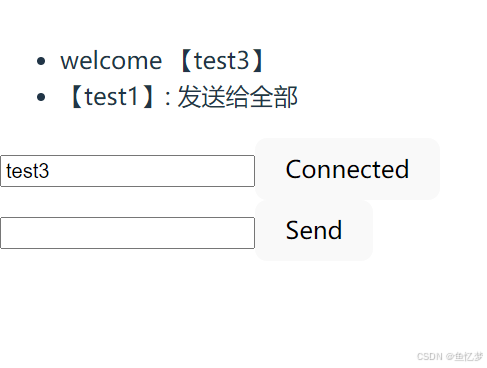

可以看到 我打招呼 有回应了

这里可以看到知识库数据不是最新的,但是有包含历史数据。

如果我们需要了解模型的详细信息,目标模型有多少B,以及如何查看ollama支持哪些模型,可以在ollama的models界面找模型,点进去可以看到每个模型的介绍以及有多少种型号:https://ollama.com/library

常用方法:

查询目前ollama已下载的模型

ollama list

查询模型信息

ollama show llava

删除模型

ollama rm llava今天的大模型介绍就到这里了,感谢能看到这里的朋友😉

本次的分享就到这里,【终极量化数据】致力于为大家分享技术干货😎

如果以上过程中出现了任何的纰漏错误,烦请大佬们指正😅

受益的朋友或对技术感兴趣的伙伴记得点赞关注支持一波🙏

也可以搜索关注我的微信公众号【终极量化数据】,留言交流🙏