LLamaFactory如何在Windows系统下部署安装训练(保姆级教程)

注意:以下教程编写和灵感来源均来自eogee开源作者(EOGEE_岳极技术_大模型与AI知识技术共享社区),大家有需要学习AI方面的知识可以关注他。

另我个人此次环境部署所用的显卡是5070ti16G显存,系统是Windows11。

如有问题,敬请指正。

B站视频:LLamaFactory如何在Windows系统下部署安装训练(保姆级教程)_哔哩哔哩_bilibili

1、Windows系统前置环境准备

(一)启用Windows功能

打开控制面板——程序——启用和关闭Windows功能

分别点击勾选以下功能(勾选完点击确定,然后重启电脑)

- Hyper-V:提供一些帮助创建和运行虚拟机及其资源的服务个管理工具

- 容器:提供服务和工具来创建和管理Windows Server容器及其资源

- 适用于Linux的Windows子系统:提供服务和环境以在Windows上运行本机用户模式Linux shel和工具

- 虚拟机平台:为虚拟机启用平台支持

(二)开启WSL2

-

电脑搜索框搜索PowerShell,以管理员身份运行

-

进入命令行分别输入下面两个命令

# 更新Windows Subsystem for Linux (WSL)的内核 wsl —update # 将 WSL 2 设置为默认版本 wsl --set-default-version 2

(三)Ubuntu系统安装(确保电脑的微软商店能正常打开)

-

命令行安装(建议使用第二种)

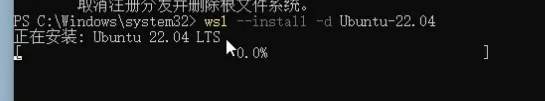

# 查看当前可安装的有效分发的列表 wsl -l -o # 安装Ubuntu22.04版本 **(注意:安装快慢视电脑网络而定,需要在好的网络环境下安装)** wsl --install -d Ubuntu-22.04

-

微软商店安装(打开微软商店,按照如下操作点击下载等待下载完成即可)

-

安装完成我们就可以打开Ubuntu了

-

首次进入需要设置用户名和密码

-

到此Windows系统前置环境准备完毕

# 关于wsl2的官网参考

https://learn.microsoft.com/zh-cn/windows/wsl/install-manual# 关于Windows设置环境的开源作者eogee老哥的参考

https://www.eogee.com/article/detail/15

2、显卡驱动和CUDA的匹配安装

前言:因为llamafactory训练出的绝大多数问题是CUDA未检测,即驱动版本不适配,本次主要匹配显卡驱动和CUDA的版本匹配,后面Python环境安装的时候还会有个CUDA和pytorch的匹配。

(一)显卡驱动安装

# 官网

https://www.nvidia.cn/drivers/lookup/# 下载安装完显卡驱动打开电脑命令行

win+R

# 输入cmd 后 再按回车

cmd

# 查看显卡驱动是否安装完成

nvidia-smi

(二)CUDA的安装

# CUDA下载官网

https://developer.nvidia.com/cuda-toolkit-archive

-

电脑搜索 NVIDIA Control Panel 打开

-

点击系统信息——组件——查看显卡CUDA不高于什么版本(这里是不高于12.9)

-

进入CUDA下载官网,我这里下载CUDA12.8安装即可

-

查看CUDA安装完成(win+R,输入cmd,再点击回车,输入nvcc -V 即可)

3、LlamaFactory下载,工具安装,环境部署,训练测试

前言:所有材料可去开源作者eogee老哥官网的云盘下载(夸克网盘分享),或者官网下载相关资料,以下内容参考eogee作者(使用llamafactory进行模型训练与微调-环境准备与工具部署-EOGEE_岳极技术_大模型与AI知识技术共享社区)

(一)Llamafactory下载

-

官网下载

https://github.com/hiyouga/LLaMA-Factory

-

eogee作者网盘下载

https://pan.quark.cn/s/c881f12f78e6#/list/share/6f157c5a233d40418bed0655a3d913e3-%E6%A8%A1%E5%9E%8B%E8%AE%AD%E7%BB%83%E4%B8%8E%E5%BE%AE%E8%B0%83# 两个都下载

注意:下载完后解压即可

(二)相关工具安装

-

VS code下载安装

# 官网链接,复制到浏览器打开即下载,后续正常安装即可 https://code.visualstudio.com/docs/?dv=win64user# 安装完成打开,点击vscode左边下方的拓展,下载安装 Chinese和WSL拓展(搜索——然后点击安装即可) Chinese (Simplified) (简体中文) WSL# 打开我们(一)下载解压的Llamafactory文件夹(下图二所示,或者点击左上角文件,也有打开文件夹的选项)# 打开完毕,**点击上方终端—— 新建终端**# 点击下标,再点击Ubuntu终端即可

-

Git下载安装(拉取deepseek模型文件)

# 官网下载64位即可 https://git-scm.com/downloads/win

-

拉取所需deepseekr1的镜像(过程很久,建议按照视频操作)

git clone https://hf-mirror.com/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B

-

(三)环境部署

-

conda安装

-

在Ubuntu(wsl)终端下,Llamafactory文件夹下,依次输入以下命令

#安装miniconda3 wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh #运行安装脚本 # 按要求,回车 输入yes 点击空格, 输入yes 回车等,看到successful即可 bash Miniconda3-latest-Linux-x86_64.sh # 刷新环境变量 source ~/.bashrc #验证安装 (显示版本号即安装成功) conda --version

-

-

创建Python运行环境(必须创建python3.9及以上的版本)

你可以使用

conda创建多个Python运行环境,每个环境可以有不同的Python版本、依赖包等(即可以做多个不同的python环境)。# 创建名为demo的Python运行环境,版本为3.10 conda create -n demo python=3.10# 激活刚刚创建的环境 conda activate demo# 其他python环境命令 #查看已创建的环境 conda env list #删除环境 conda remove -n demo --all

-

单独下载与CUDA匹配的Pytorch(下载时间较久,请耐心等待)

# Pytorch官网 https://pytorch.org/get-started/locally/ # 指定版本下载(我的是CUDA12.8)(静待安装完成即可) pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu128

-

最后下载metrics(监控和量化训练过程)(下载时间较久,请耐心等待)

pip install -e ".[metrics]" -i <https://pypi.tuna.tsinghua.edu.cn/simple>

-

启动Llamafactory

# 启动 llamafactory-cli webui # 打开浏览器输入localhost:7860 localhost:7860

(四)训练测试

-

模型设置(前提下载好DeepSeek-R1-Distill-Qwen-1.5B,前面有提过如何操作)

# 因为我们是在Ubuntu 终端下操作,所以Windows系统的路径和Ubuntu系统的路径需要映射即 # Windows下 D:\\Study\\AI\\Models\\DeepSeek-R1-Distill-Qwen-1.5B # 等于Ubuntu /mnt/d/Study/AI/Models/DeepSeek-R1-Distill-Qwen-1.5B# 设置好模型路径,模型名称也需要选择 DeepSeek-R1-1.5B-Distill

-

选择数据集,进行训练测试