解锁Python编程的无限可能:《奇妙的Python》带你漫游代码世界

《Python OpenCV从菜鸟到高手》带你进入图像处理与计算机视觉的大门!

生成对抗网络(GAN)是深度学习中用于生成数据的前沿技术,通过两个神经网络的对抗训练实现逼真图像的生成。本文深入介绍GAN的基本原理,并使用Python从头构建一个简单的GAN模型。文章将涵盖GAN的数学理论、网络结构、训练步骤、及如何使用GAN生成图像数据。通过详细的代码示例和中文注释,本文帮助读者深入理解GAN的实现过程,探索如何通过GAN在图像生成应用中创造出逼真效果。本文适合希望了解并动手实践GAN原理和实现的读者。

目录

- 引言

- 生成对抗网络(GAN)的基本原理

- 2.1 GAN的组成

- 2.2 GAN的训练过程

- 用Python实现简单的GAN

- 3.1 构建生成器网络

- 3.2 构建判别器网络

- 3.3 损失函数和优化器

- 训练GAN模型生成图像

- 模型训练结果分析与优化

- 结论

1. 引言

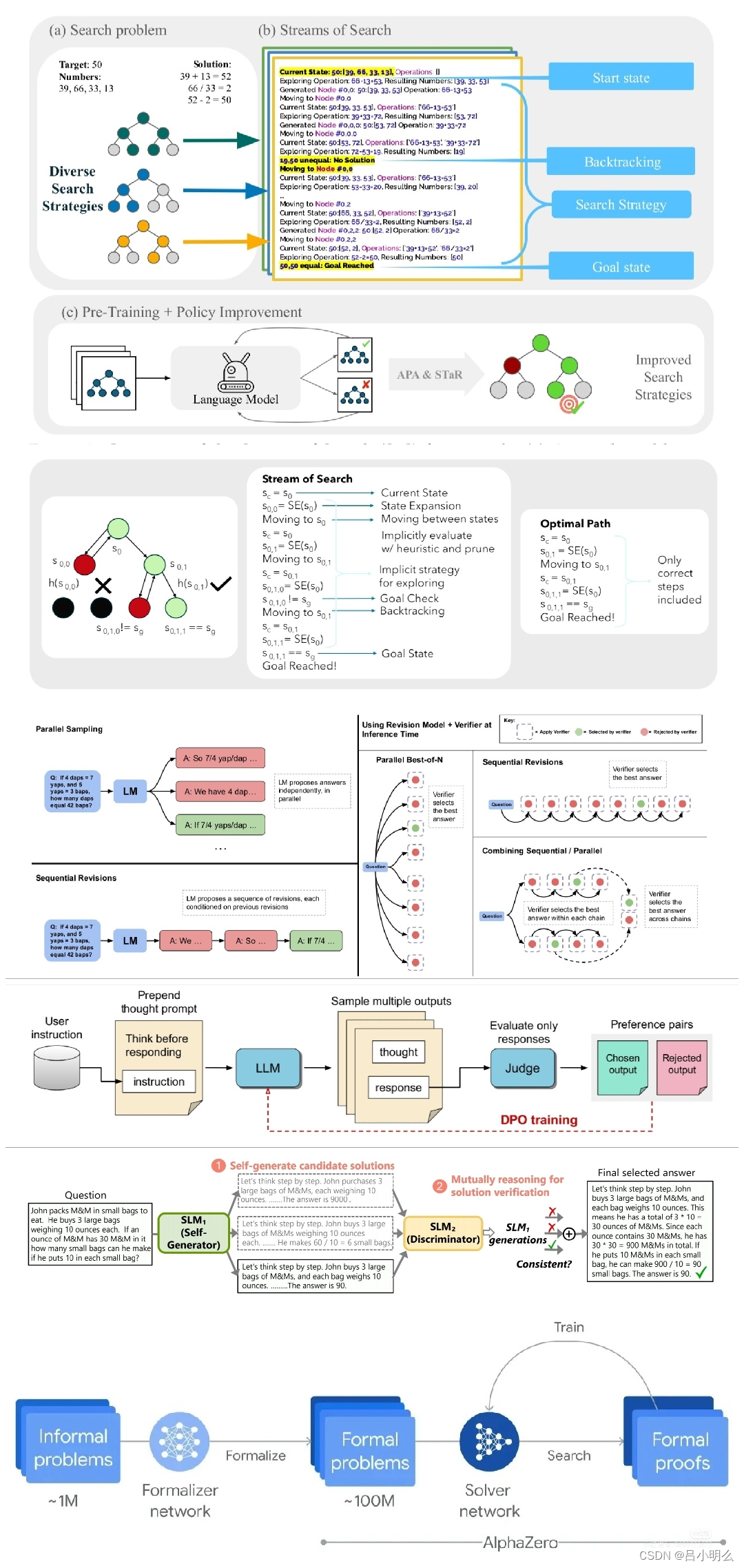

生成对抗网络(GAN)是一种通过两个神经网络对抗性训练生成数据的技术,广泛用于图像生成、图像修复、风格迁移等任务。GAN模型由生成器(Generator)和判别器(Discriminator)构成,通过交替训练,使生成器生成的数据能够逐渐接近真实数据。本文将带领读者从理论和实践出发,详细讲解GAN的工作原理,并使用Python从头实现一个简单的GAN模型以生成图像数据。

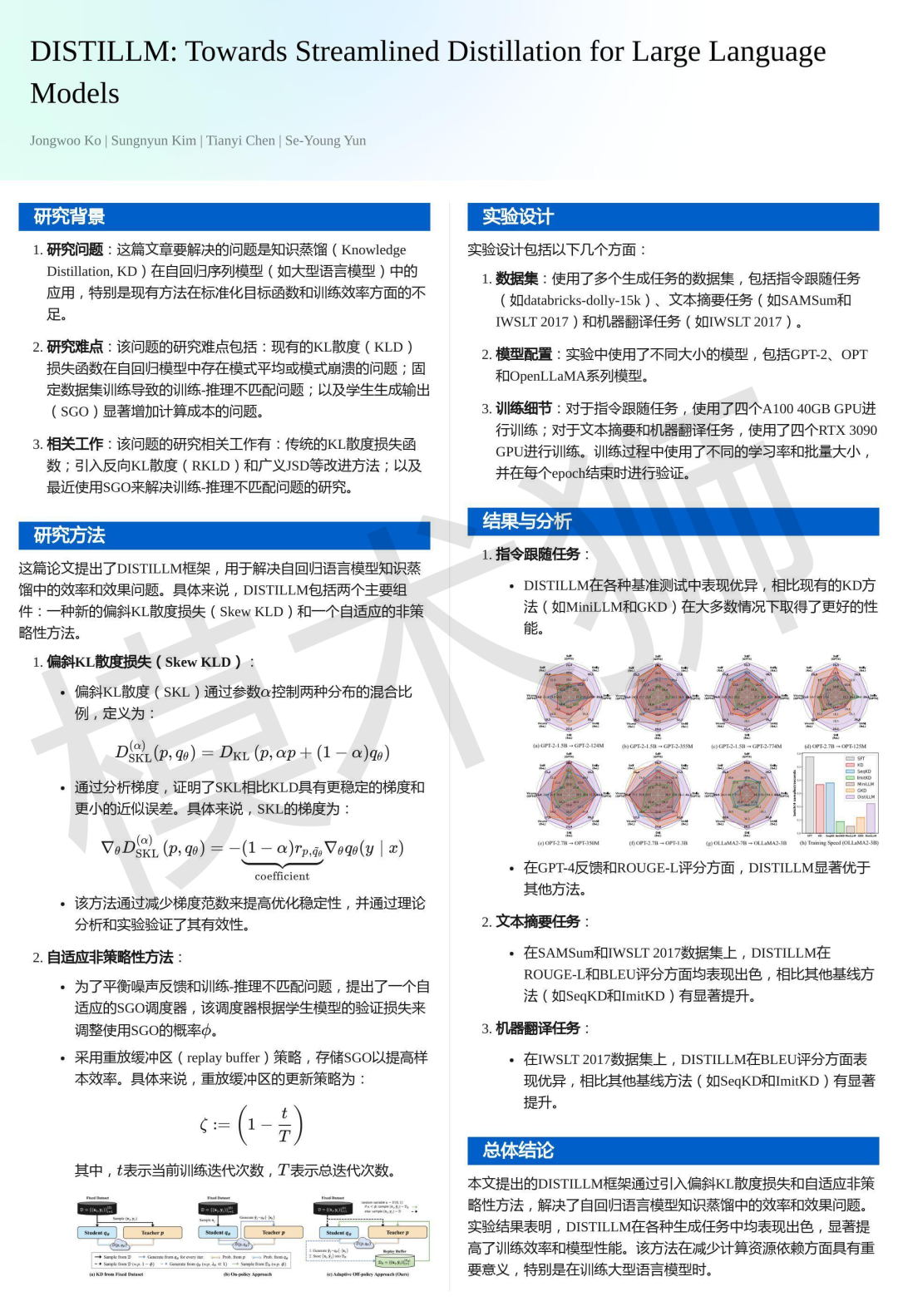

2. 生成对抗网络(GAN)的基本原理

2.1 GAN的组成

GAN模型主要由两个神经网络组成:

- 生成器(Generator):生成器接收随机噪声作为输入,并输出一个生成的数据样本(如图像)。它的目标是生成足够逼真的数据,骗过判别器,使其认为生成数据是真实数据。

- 判别器(Discriminator):判别器的任务是区分真实数据和生成数据,输出一个0到1之间的概率值,表示输入数据是真实数据的概率。

在GAN的对抗训练中,生成器和判别器不断竞争,从而提升各自的性能。生成器试图“欺骗”判别器,而判别器则试图准确区分真实数据和生成数据。这种相互博弈使得生成器生成的数据逐渐逼近真实数据的分布。

2.2 GAN的训练过程

GAN的训练过程可以表示为一个极小极大(minimax)优化问题,目标是让生成器生成的样本尽可能接近真实样本。数学上,可以定义GAN的损失函数为:

min G max D V ( D , G ) = E x ∼ p data ( x ) [ log D ( x ) ] + E z ∼ p z ( z ) [ log ( 1 − D ( G ( z ) ) ) ] \min_G \max_D V(D, G) = \mathbb{E}_{x \sim p_{\text{data}}(x)}[\log D(x)] + \mathbb{E}_{z \sim p_z(z)}[\log(1 - D(G(z)))] GminDmaxV(D,G)=E