人工智能咨询培训老师叶梓 转载标明出处

在图变换器领域,尽管其全局注意力机制在图结构数据处理上显示出了巨大潜力,但现有的图变换器模型却普遍较浅,通常不超过12层。这一现象引发了学者们对于“增加层数是否能进一步提升图变换器性能”的深入探讨。在北京大学和微软研究院的合作下,研究者们提出了一个关键问题:为何现有的图变换器在增加深度后,性能并未得到显著提升,甚至出现了性能瓶颈?通过深入分析,他们发现这一问题的核心在于全局注意力机制的“消失容量”,即随着模型深度的增加,图变换器越来越难以聚焦于图的关键子结构,从而限制了模型获取富有表现力特征的能力。图1展示了不同深度的图变换器在ZINC数据集上的性能。左侧展示了随着深度增加,基线模型的性能如何变化。右侧展示了不同深度下,模型对子结构的注意力容量。

为了解决这一问题,研究团队提出了一种名为DeepGraph的新型图变换器模型。该模型通过在编码表示中显式引入子结构标记,并在相关节点上应用局部注意力,以获取基于子结构的注意力编码。这种方法不仅增强了全局注意力对子结构的聚焦能力,还提升了表示的表达力,有效解决了随着图变换器深度增加时自注意力的局限性。

方法

DeepGraph模型提出的基于子结构标记的局部注意力方法与直接替换全局注意力不同,DeepGraph在保留节点间全局注意力的同时,为子结构引入了局部注意力,实现了全局与局部编码的更好平衡。这种方法首先对图的子结构进行采样,然后将这些子结构编码为标记,并在这些子结构上实施局部注意力。

子结构被分为两类:包含局部特征的邻居(如图2跳邻居和随机游走邻居)和代表图拓扑特征的几何子结构(如图2中的环、路径、星形等特殊子结构)。为了确保计算的可行性,模型在每次编码时对子结构进行采样。图2展示了这一过程,其中子结构通过图工具包进行有效匹配,并缓存以供重用。该框架首先通过子结构采样策略从图中提取关键子结构,然后利用子结构标记编码将这些子结构转换为模型可以理解的标记形式。最后,在局部注意力机制的辅助下,模型能够专注于与子结构相关的节点,从而获得更丰富的图表示。

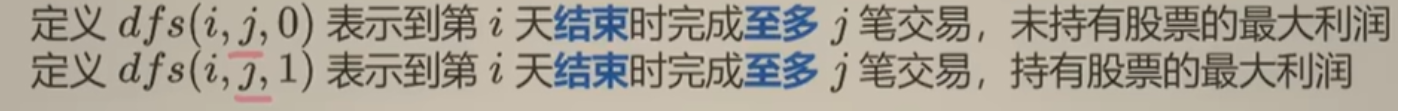

输入嵌入包括节点标记嵌入和子结构标记嵌入,分别由节点特征编码器和子结构编码器独立编码。子结构标记通过排列不变的结构编码直接编码子结构邻接矩阵。为了减少可能的排列组合数量,采用了深度优先搜索(DFS)算法,并在每一步中根据节点的度进行排序。公式:![]() 定义了子结构标记编码器,其中通过DFS采样代替了池化操作。

定义了子结构标记编码器,其中通过DFS采样代替了池化操作。

在子结构标记添加后,在子结构及其对应节点上应用局部注意力,通过在自注意力模块中添加掩码M来实现,其中掩码元素可以是0或负无穷大,从而在自注意力矩阵中实现稀疏性。公式:![]() 展示了如何通过定义掩码来引导模型对子结构标记和对应节点的局部注意力,其中子结构标记仅对相应节点应用局部注意力。这种注意力机制的结合不仅增强了模型对子结构的聚焦能力,还提升了子结构表示的区分度和表达能力。

展示了如何通过定义掩码来引导模型对子结构标记和对应节点的局部注意力,其中子结构标记仅对相应节点应用局部注意力。这种注意力机制的结合不仅增强了模型对子结构的聚焦能力,还提升了子结构表示的区分度和表达能力。

DeepGraph模型通过在保留全局注意力的同时引入基于子结构的局部注意力,有效地解决了大模型在处理图数据时对关键子结构特征捕捉不足的问题。通过子结构采样、编码和局部注意力的实施,模型能够更准确地学习和表示图数据的复杂结构特征。

想要掌握如何将大模型的力量发挥到极致吗?叶老师带您深入了解 Llama Factory —— 一款革命性的大模型微调工具(限时免费)。

1小时实战课程,您将学习到如何轻松上手并有效利用 Llama Factory 来微调您的模型,以发挥其最大潜力。

CSDN教学平台录播地址:https://edu.csdn.net/course/detail/39987

实验

实验验证旨在解答几个关键问题:DeepGraph与其他变换器在流行基准测试中的表现如何?随着深度的增加,DeepGraph的性能是否提高?DeepGraph是否能够缓解注意力容量缩小的问题?以及模型各个部分对整体性能的影响如何?

实验在四个流行的图数据集上进行验证,包括PCQM4M-LSC、ZINC、CLUSTER和PATTERN,这些数据集被广泛用于图变换器研究。涵盖了从分子属性预测到节点分类的不同任务。

表1展示了DeepGraph与现有最先进方法在图回归和节点分类任务上的比较。结果显示,即使是12层的DeepGraph模型也在多个数据集上超越了基线模型。随着模型深度的增加,性能持续改善,48层的DeepGraph在所有数据集上都优于基线模型,证明了增加深度的有效性。

图3展示了DeepGraph模型与通过不同深度变换方法增强的现有最先进(SOTA)方法的性能比较。这些方法包括对Graphormer和SAT模型进行深度扩展,并通过融合方法(fusion method)和重注意力方法(reattention method)进行优化。结果表明,无论在哪个数据集上,DeepGraph都能显著优于这些基线模型,即使在模型深度增加的情况下也能保持性能提升,证明了其在深层图变换器中的有效性和优越性。

实验还通过可视化方法展示了DeepGraph与深层基线模型在ZINC数据集上的注意力容量。图1(右)展示了结果,表明DeepGraph模型的注意力容量在所有层中都保持较高,这表明基于子结构的局部注意力是防止注意力缺陷的有效方法。另外子结构标记的容量远高于基于节点计算的注意力容量,这证明了使用子结构标记对子结构进行编码的好处。

消融研究见表2。通过在ZINC和CLUSTER任务上进行消融研究来验证模型的有效性,移除了局部注意力、子结构编码和deepnorm,以观察它们的影响。结果表明,没有局部注意力,性能显著下降,证明了所提方法的有效性。另外子结构编码也起到了关键作用,强调了结构信息的重要性。最后,deepnorm通过稳定优化过程也有助于模型性能,特别是对于48层模型。

表3展示了在ZINC数据集上对DeepGraph模型进行的敏感性分析,特别是针对不同类型的子结构。这项研究探讨了仅使用几何子结构或邻居子结构,以及同时使用两者时,模型性能的变化。分析结果表明,虽然所有配置在一定程度上都能提升性能,但结合使用几何和邻居子结构时,模型表现最佳。这强调了在图变换器中同时考虑局部和几何子结构的重要性,以及DeepGraph模型在灵活利用不同子结构信息方面的能力。

实验结果证明了DeepGraph模型在图数据任务中的有效性和优越性,特别是在处理更深层模型时的性能提升。

论文地址:https://arxiv.org/pdf/2303.00579v1

项目地址:https://github.com/zhao-ht/deepgraph