Tansformer

- 什么是注意力机制

- 注意力的计算

- 键值对注意力和多头注意力

- 自注意力机制

- 注意力池化及代码实现

- Transformer模型

- Transformer代码实现

什么是注意力机制

注意力机制的发展史

Attention Mechanism

Mnih V, Heess N, Graves A. Recurrent models of visual attention, 2014.

Vaswani A, et al. Attention is alyouneed, 2017. (Tansformer首篇文章)

生物学中的注意力

从众多信息中选择出对当前任务目标更关键的信息

深度学习中的注意力机制

让神经网络能够更加关注图像中的重要特征,而不是整张图像

编解码器架构

大多数注意力机制都附着在Encoder-Decoder框架下

注意力机制是一种思想,本身并不依赖于任何框架

编码器的信息被压缩到编码器和解码器之间固定长度的向量

会导致很多信息的损失

存在信息瓶颈的问题

解决办法:

NLP中的注意力机制

上下文向量c应可访问输入序列所有部分,而不仅是最后一个每一时刻产生不同的语言编码向量,表示不同的关注区域

注意力机制的类型

隐式注意力:非常深的神经网络已经学会了一种形式的隐式注意

显式注意力:根据先前输入的记忆“权衡”其对输入的敏感度

注意力机制的类型

软注意力:函数在其域内平滑变化,因此是可微的

硬注意力:用随机抽样模型代替了确定性方法,不可微的

编解码器架构中的注意力机制

注意力权重的计算:

建立编码器到解码器之间非线性的映射关系

把yi-1看作是一个查询向量,看和编码器中哪个隐状态hj最相关

注意力的可视化

对齐alignment

权重是动态计算的

允许一对多的关系

注意力的计算

编码器-解码器中的注意力

神经网络的输出

注意力就是衡量两种隐状态间对齐”程度的分数

输入是解码器先前的状态

以及各个时刻编码器的隐藏状态

输出就是一个权重

表示编码器和解码器2种状态间的关联关系。并且捕捉对齐关系

如何计算注意力

注意力就是衡量编码器隐状态与前一时刻解码器输出对齐的分数

第二种最常用,将注意力参数转化为小型的全连接网络

注意力相当于一组可以训练的权重

可以用标准的反向传播算法进行调整

解码器决定原来要输入注意句子中哪一部分

通过让解码器有注意力机制,减轻编码器必须将输入的序列语句中所有信息编码成固定长度向量的这种负担。

通过这种方法信息可以分布在整个序列中

解码器可以相应的选择检索这些信息

注意视角,是解码器来注意编码器中当中的隐状态序列,从他这里去关注重要信息

全局注意力和局部注意力

Global Attention:在整个输入序列上计算注意力分数

Local Attention:只考虑输入单元/标记的一个子集

注意力权重 是剧烈变化,不像全连接权重缓慢变化

而且注意力 的输入是隐状态,全连接输入的是前一层的神经元

自注意力机制

·Self-Attention:序列自身的注意力

把序列转化成一个新序列在输入

可以看作是对输入序列的一种预处理

注意力机制的优点

- 解决了编码器到解码器之间信息传递的瓶颈问题

- 建立编码器状态和解码器间直接联系,消除了梯度消失问题(RNN 级联 造成)

- 提供了更好的可解释性

注意力权重关系图

注意力与transformer

transformer:编码器到解码器两个序列之间的一个转换器

注意力机制某种程度上就是transformer

注意力机制是transformer模型的核心部分

主要处理信息序列的处理问题

通过学习不同位置之间的关系来决定对哪些位置进行重点的关注从而输出更加准确的结果

注意力机制的应用

通用的NLP模型,文本生成、聊天机器人、文本分类等任务

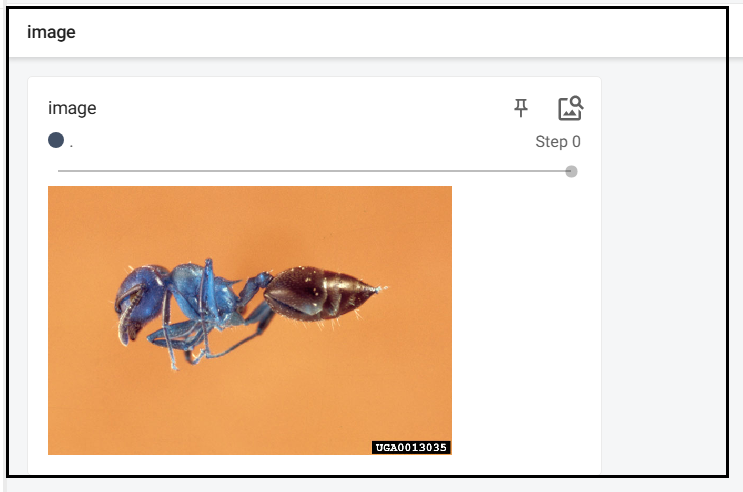

图像分类模型中也可以使用注意力机制,VisionTransformer

键值对注意力和多头注意力

经典注意力机制计算:

直接使用编码器隐状态计算注意力的局限:

注意力分数仅基于隐藏状态在序列中的相对位置而不是他们的内容,限制了模型关注相关信息的能力

故引入键值对

query可以看作是解码器上一回的输出

key value 由input 线性变化得来

value不参与计算 实现相似性和内容的分离

键值对注意力分数的计算:

dk是向量的维度

QK相当于求了相似性

Q、K、V本质都是输入向量的线性变换

W都是训练得到的

当key和value相等 就回到了前面的经典注意力机制

key value分离带来更多灵活性

多头注意力机制

Multi-Head Attention:多个查询向量

每个Q关注X不同的角度 不同部分

使模型学习到更加丰富的内容

捕获X更多信息

并行还能提高训练效率

自注意力机制

Self-Attention:

The animal didn’t cross the street it was too tired.because

it到底知道animal还是street呢

自注意

可以让模型聚焦在输入的重要部分,忽略不相关信息

能处理变长的信息 图像文本等

而且可以在不改变模型结构情况下,加强模型的表示能力

还能减少模型的复杂度,因为只对关键信息进行处理

获取输入向量的OKV值

三个权重矩阵训练得到

Query:查询

Key:键

Value:值

qkv分别由词嵌入向量与权重相乘得到

自注意力分数

查询向量q和各个单词的键向量求点积运算

Softmax归一化

除以key向量维度的平方根

使得梯度更加稳定

softmax求出来的注意力分布

表示每个词对各个位置的关注程度

注意力加权求和

保留想关注的词

淹没不相干的词

加权和为自注意力输出

汪意力矩阵计算

一次性计算出所有位置的的Attention输出向量

QK 相乘是求相似度

softmax是为获取自注意力分布

K和V分离是为了使模型更灵活捕获更多信息

V保存了输入的内容

Z表示序列自身内部不同元素间的注意力关系

自注意力机制的理解

计算输入序列每个元素与其余元素之间的相关性得分

注意力池化及代码实现

颜色越浅表示权重越大

注意力池化

Q与K的计算构成注意力池化

注意力池化对输入进行选择并生成最终输出

对信息筛选的本身其实就是池化

对输入进行选择并生成输出这一过程就是池化

非参数注意力池化

非参数就是不用训练

,

- 平均注意力池化

-

通用注意力池化公式

-

Nadaraya-Watson核回归公式

参数注意力池化

令查询O和键K之间的距离乘以可学习参数w

Transformer模型

RNN 和LSTM 都存在梯度爆炸的问题

transformer通过自注意力机制的建模避免了这一问题

模型结构

六个编码器串联

六个解码器串联

编解码器互联

编码器把输入变成一些向量

解码器则利用这些向量来输出序列

两者通过注意力机制交互,使得解码器能够根据输入序列生成输出序列

可以理解为 彼此通过多次非线性变化在不同空间提取更多特征

编码器的结构相同,但不共享权重

嵌入算法转化为向量

超参数:512

每个词都独立

词与词间的关系通过自注意力机制来表达

前向反馈没有相互之间的计算,因此前向反馈层可以并行运算

多头自注意力层

一个输入X会生成不同的Q、K、V

得到不同的Z

然后再拼接他们

扩展模型关注不同位置的能力

为注意力层提供了多个表示子空间

有点类似CNN中的不同卷积核

用于捕捉输入空间不同维度特征

不同颜色代表不同头

颜色深浅代表自注意力权重

以it为例,编码时关注重点

- The animal

- tired

一个头关注animal

一个头关注tired

位置嵌入

为了让模型了解单词的顺序,我们添加了位置编码向量

embedding 单词嵌入向量可以通过预训练的word2vector 或者 glove 获取 或者训练得到

位置编码 使用正余弦函数定义

transformer并不是RNN结构而是使用全局信息,无法利用单词顺序信息,所以要引入位置嵌入向量保存位置信息

残差结构

更容易学习复杂特征

避免梯度消失和爆炸

训练更稳定,收敛快

每一步解码都要编码器的输出来生成输出序列中下一个单词的表示

通过连接编码器和解码器,模型可以有效利用编码器对输入序列的理解,从而输出更有效输出序列

也可以避免信息丢失问题,从而提高模型整体性能

编解码器协同工作

线性层和softmax层

线性层:转化为logits向量

每个单元格对应一个单词分数

softmax层:转化为概率

选择具有最高概率的单词作输出

优缺点

与RNN相比更易并行化训练;本身无单词顺序,要加入位置嵌入

重点是自注意力结构OKV矩阵;多头注意力含多个自注意力模块

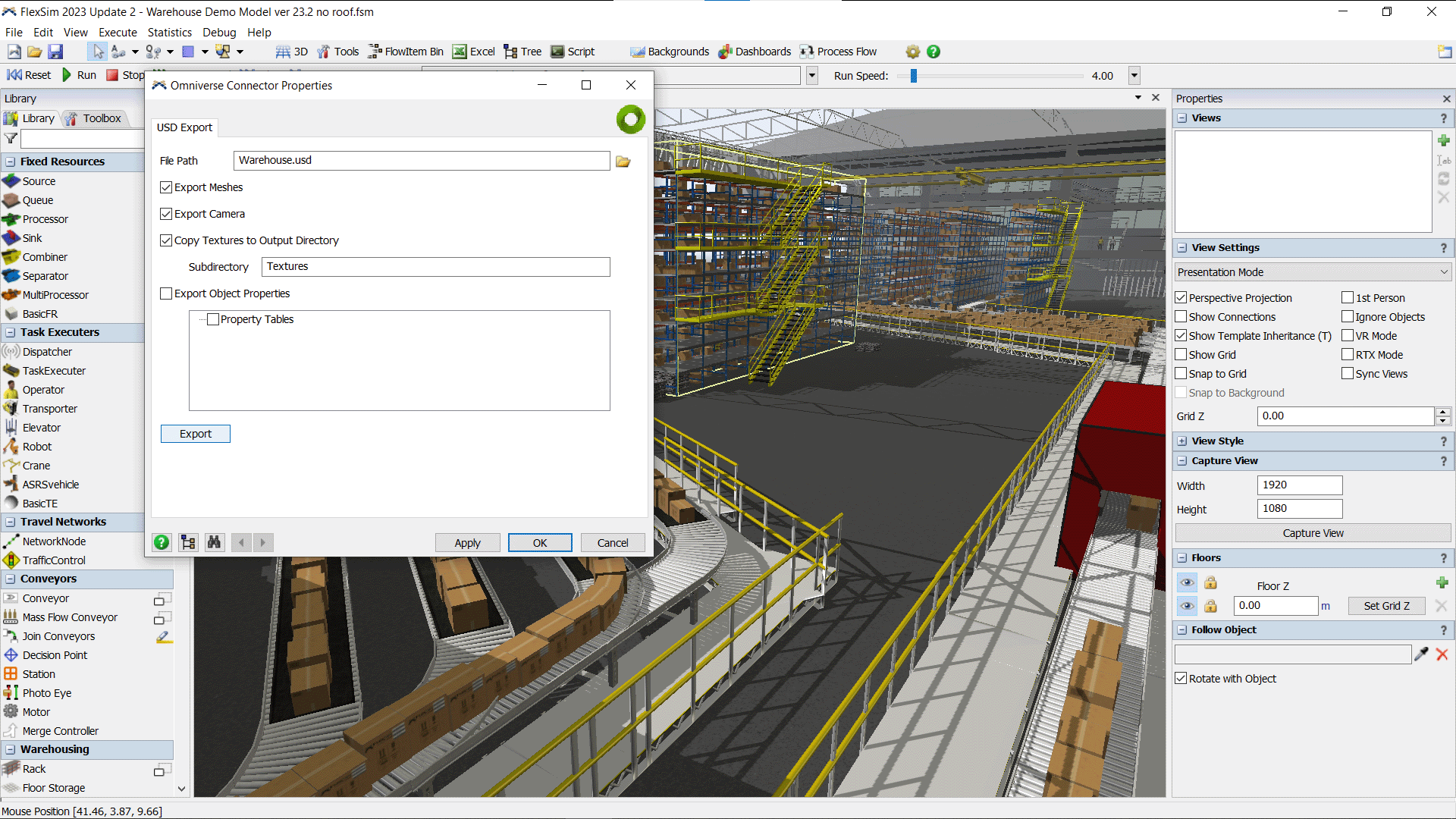

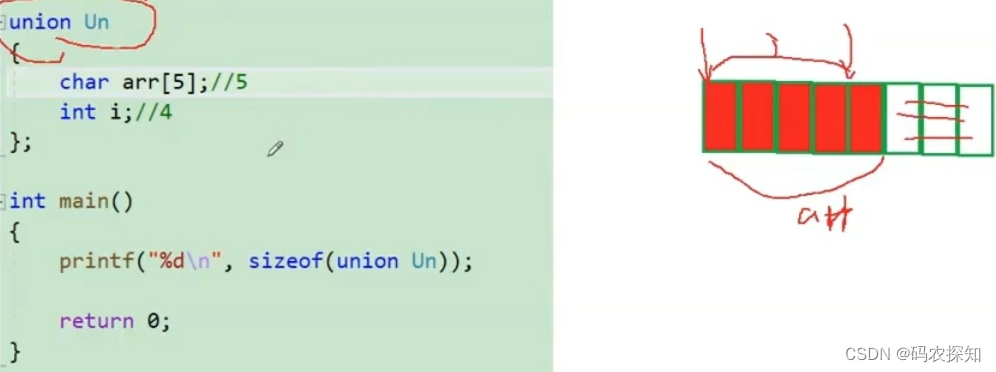

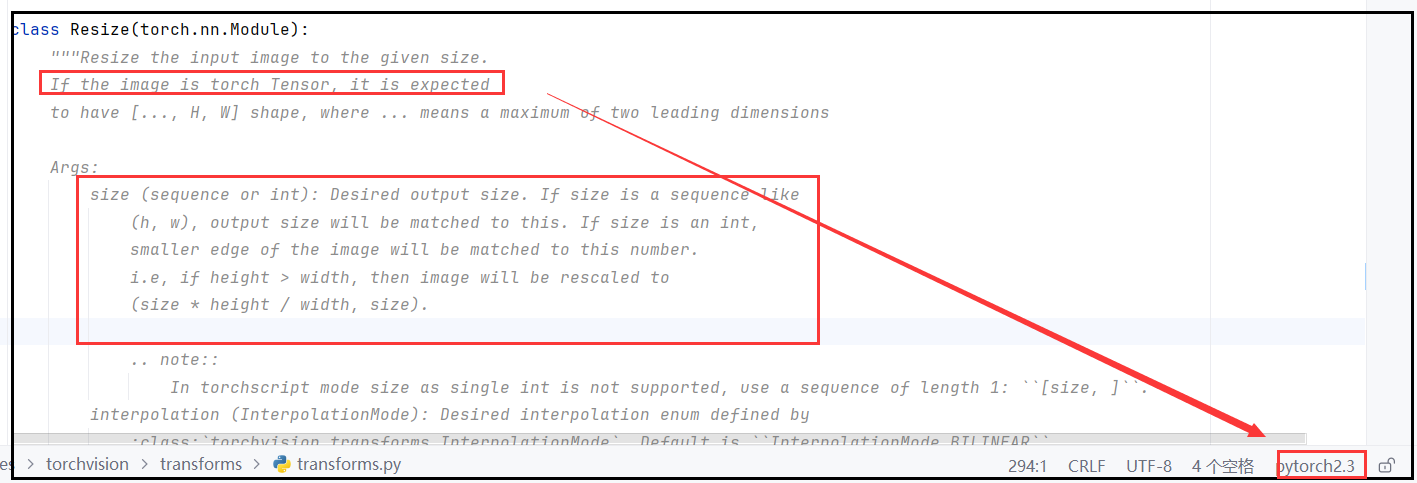

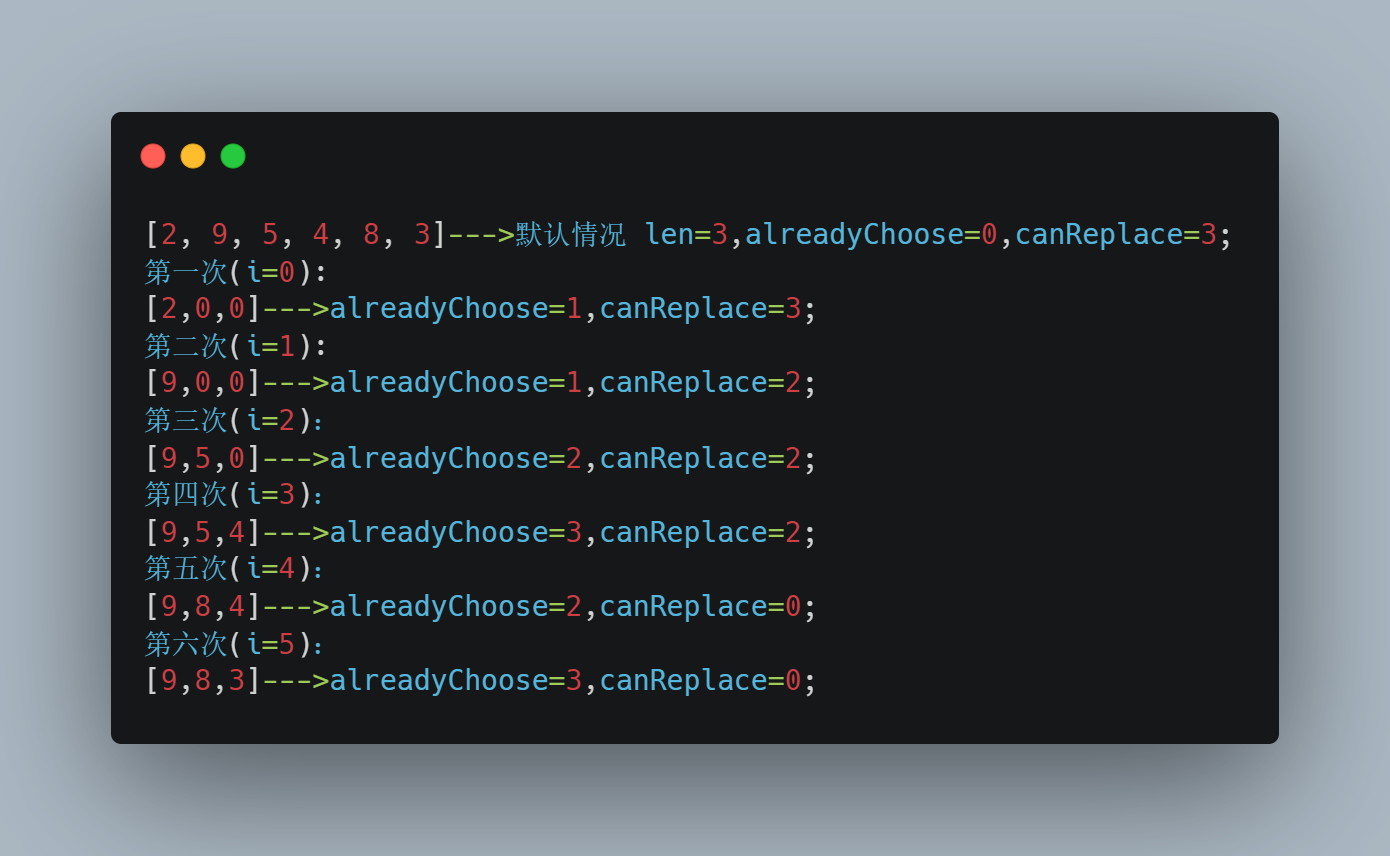

Transformer代码实现

在这里插入图片描述

数据太烂了,并不是说transformer不行

可以借鉴代码