网络技术----wireshark抓包出现1500以上的大包原因分析

- 背景描述

- 原因分析

- TSO(TCP segment offload,TSO)

- linux中关闭/开启TSO功能:

- 其他类似TSO的机制

- wireshark抓包来源

背景描述

我们在使用抓包工具的过程中,经常发现一些报文长度大于1500长度的报文,但是根据MTU的限制,这是不合理的,这是为什么呢?下面将详细探讨并分析这个问题。

原因分析

TSO(TCP segment offload,TSO)

抓包工具之所以能抓到大于MTU长度限制的报文,在于当前网卡开启了TSO机制。

在支持 TSO 的网卡上,为了降低报文切片给CPU带来的影响,CPU内核只负责将大包转发给网卡,而网卡负责把这些超大报文拆分成符合物理链路层限制的小包。简单来说就是,原本由内核处理的拆包,交给了网卡来处理,而我们通过 tcpdump 抓包工具抓取的是从内核到网卡路径上的数据包,所以会存在上述问题,如果在交换机处抓包,那么对应的大小为MSS值或小于 MSS 值。

-

提到 TSO(TCP Segmentation Offload),就不得不谈到分段卸载技术。随着网络带宽的飞速提升,以太网的速度从最初的 10M 发展到如今的 100G,提升幅度达到了 10000 倍。尽管 CPU 在这些年里也有显著进步,但单核 CPU 的频率增长并不明显。虽然 CPU 核心数目大幅增加,但将网络数据流分配给多个 CPU 核心进行处理仍然面临一定的挑战。此外,随着虚拟化技术的引入,计算机需要处理的任务变得更加复杂,不仅要运行应用程序,还需支持容器和虚拟机,这使得 CPU 的负担更加沉重。

-

在 TCP 双向通信的情况下,发送或接收 1 bit/s 的数据大约需要 1 Hz 的 CPU 处理能力。当发送和接收各为 10 Gbit/s 时,整体吞吐量达到 20 Gbit/s,相当于 20 GHz 的处理能力,这大约需要 8 个 2.5 GHz 的 CPU 核心。如果完全依赖 CPU 来进行校验、计算、验证、分包和组包,CPU 的消耗将非常可观。为了解决这个问题,越来越多的技术应运而生,以适应不断变化的技术环境,其中网卡能够支持将某些 Linux 内核协议栈的计算任务卸载到物理网卡上,从而减轻 CPU 的负担。

-

TSO 就是将 TCP Segmentation 的工作,卸载(offload)到网卡来完成。有了TSO,操作系统只需要传给硬件网卡一个大的 TCP 数据(当然是包在 Ethernet Header和IP Header内,且不超过64K )。网卡会代替 TCP/IP 协议栈完成 TCP Segmentation。这样,就消除了 TCP Segmentation 带来的 CPU 负担。支持TSO的网卡,仍然会按照TCP/IP协议将网络数据包生成好并发送出去,对于外界系统来说,感受不到TSO的存在。

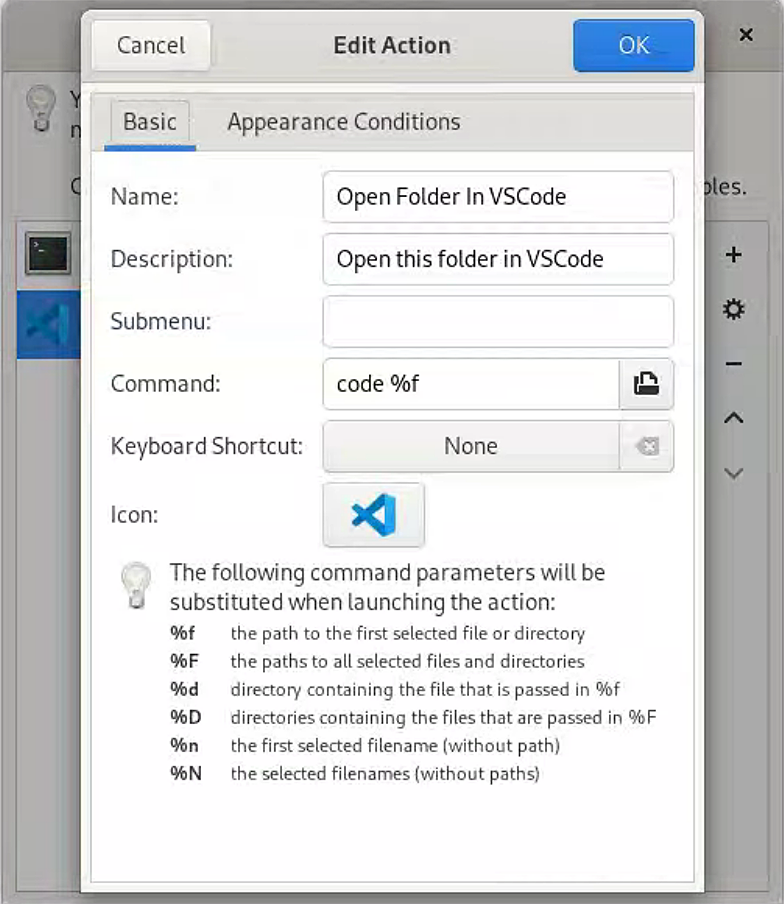

linux中关闭/开启TSO功能:

可以通过如下命令查看对应网卡此时TSO的状态:

[root@vm-os-centos7 ~]# ethtool -k eth0|grep tcp-segmentation-offload:

tcp-segmentation-offload: off

[root@vm-os-centos7 ~]#[root@vm-os-centos7 ~]# ethtool -K eth0 tso off

[root@vm-os-centos7 ~]#

其他类似TSO的机制

| 名称 | 全称 | 作用 | 原理 | 适用协议 | 应用场景 |

|---|---|---|---|---|---|

| TSO | TCP Segmentation Offload | 减少CPU处理小分段的负担 | 将大数据包交由网卡进行分段,再进行传输,减少CPU负荷 | TCP | 高流量传输,适用于服务器、虚拟化环境 |

| UFO | UDP Fragmentation Offload | 提高UDP大包处理效率 | 网卡负责分片和重组,减轻CPU分片/重组负担 | UDP | 大量数据传输的多媒体或VoIP应用 |

| GSO | Generic Segmentation Offload | 适用于多种协议的分片卸载机制 | 将大数据包在发送时交由网卡分段处理 | TCP、UDP等 | 支持多协议的高负载服务器和虚拟化环境 |

| LRO | Large Receive Offload | 接收端大包处理,减少CPU负担 | 将小包合并为大包后再交由操作系统处理 | TCP | 网络流量较高的服务器、虚拟化应用接收端 |

| LSO | Large Send Offload | 发送端大包处理,减少CPU负担 | 操作系统将大数据流交由网卡分段发送,减轻CPU负荷 | TCP | 大流量发送场景,如视频流、虚拟化传输 |

| LROv2 | Large Receive Offload v2 | 更高效的接收端大包处理 | 基于LRO,优化了分片处理的高效性 | TCP | 网络流量密集的高性能计算和虚拟化接收端 |

wireshark抓包来源

Wireshark捕获的数据包通常是系统发送给网卡之前或网卡接收并传给系统之后的数据包。具体取决于操作系统的网络堆栈和驱动程序的工作原理。简而言之,Wireshark通常是在操作系统的网络协议栈中捕获到数据包,而不是直接从网卡硬件发出或接收到的数据包。

因此:

-

发送过程:Wireshark通常捕获的是系统发送给网卡的数据,而不是网卡实际发送出去的物理数据包。这意味着在应用了一些硬件卸载(如TSO或GSO)后,Wireshark看到的可能是分段前的“虚拟”大包,而网卡会将它们进一步分片发送。

-

接收过程:Wireshark通常捕获的是网卡传给操作系统的数据包,因此如果硬件支持并启用了LRO(Large Receive Offload)等技术,Wireshark可能捕获到的是网卡已经重组好的较大数据包,而非网络上实际传输的小分片。

参考:https://www.modb.pro/db/50701

![[全网最细数据结构完整版]第六篇:3分钟带你吃透栈并模拟实现](https://i-blog.csdnimg.cn/direct/84e220d46fa84e4ab1e7dee6d2ec5e42.jpeg)