- 这是武汉大学一作单位的一篇发表在ECCV2024上的论文,文章代码开源,文章首页图如下所示,做混合图像干扰去除,还能分别去除,看起来很牛逼。

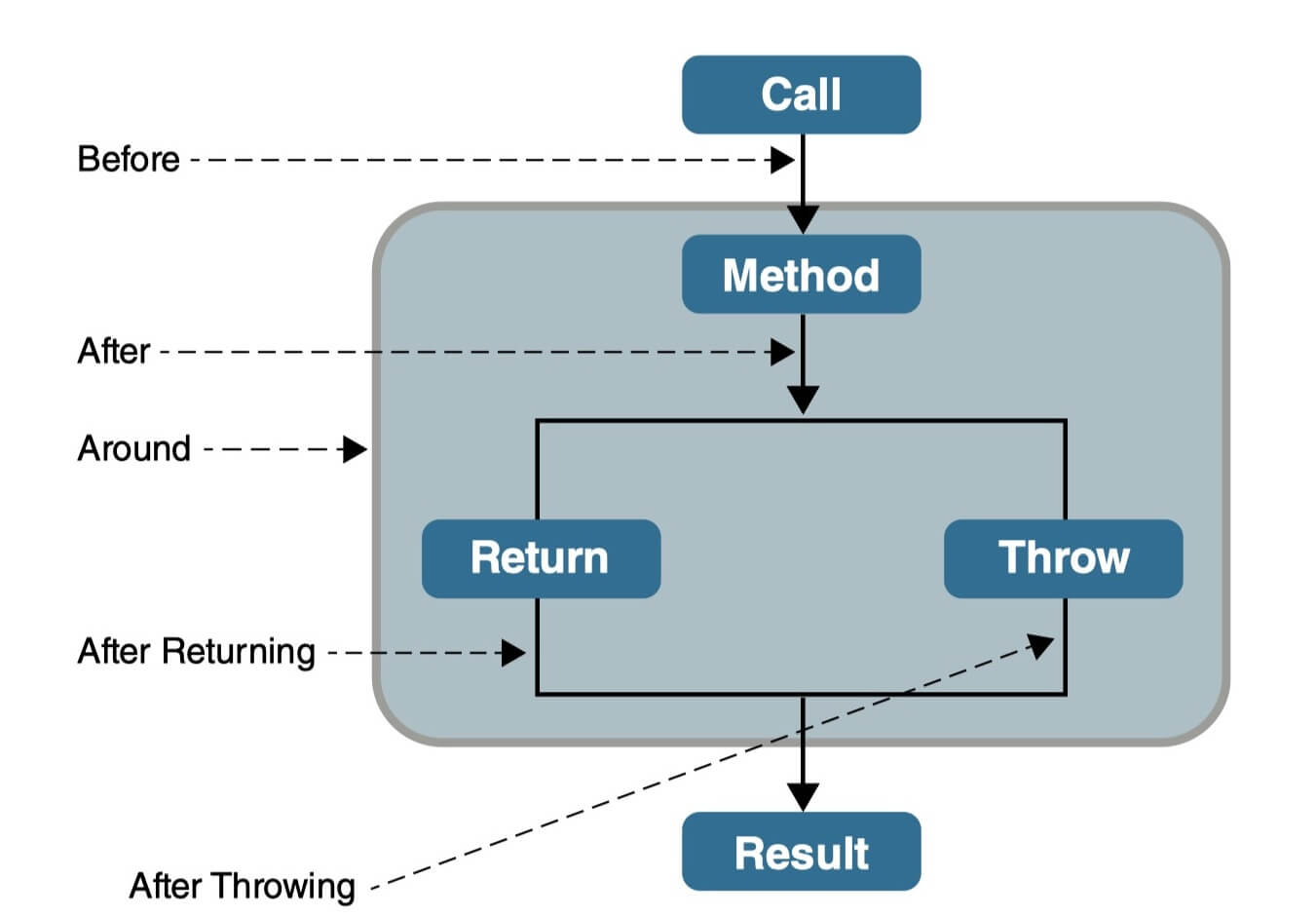

- 文章是少见的做混合图像干扰去除的,不过可惜只包含了3种degradation,而甚至不包含noise。三种分别是low-light,rain/snow,以及haze。文章认为一张degraded image,是由它对应的clear state通过以上提及的顺序叠加degradation生成的。其中low-light用retinex理论来分解,雨就直接加雨图,雪就用色差图来加权雪图,雾则用大气散射模型建模,如下所示:

- 基于上述假设,文章提出了一个叫Composite Degradation Dataset (CDD-11)的数据集,在RAISE数据集上得到一些干净的图像,加各种降质的组合,得到11种降质,得到最终的成对图像数据集。

- 网络结构如下图所示,还是老一套,在普通的restoration的网络中,加入degradation的embedding,进行交互。这里就是用交叉注意力进行交互,然后degradation的embedding通过语言模型提取或者image encoder提取,并算了个文本特征和图像特征之间的对比损失(余弦相似度加交叉熵,本质上是希望训练好一个能自动预测degradation type的image encoder):

- 此外还有个对比损失,是算修复结果与GT和LQ 图片之间的对比损失,这个损失不仅限于这个框架用。其实就是想要修复结果与GT之间更接近,与LQ之间更远。原有对比损失是这样做的,将图片用vgg提取特征,然后计算修复结果的特征与输入图片的特征之间的距离以及修复结果的特征与GT图片特征之间的距离,算一个triplet loss,但是文章提出这样的损失放在这个composite degradation的设定下可能导致修复结果与其它degradation之间的特征变得更接近(感觉这个解释有点牵强)。所以希望添加更多的negative sample,把其它degradation type的图片也提取特征,作为negative sample来算损失。示意图如下:

- 从消融实验结果可以看到,相比普通的CL,用多个negative sample的CL取得更好的结果。