OpenAI 12Days 第二天 强化微调(RFT):推动语言模型在科学研究中的应用

文章目录

- OpenAI 12Days 第二天 强化微调(RFT):推动语言模型在科学研究中的应用

- RFT的工作原理与应用领域

- 案例研究:基因突变预测

- 结果与评估

- RFT的未来与扩展

- 总结

强化微调(Reinforcement Fine-Tuning, RFT)是通过强化学习算法对语言模型进行优化,使其能够在特定任务中展现出专家级的推理能力。与传统的微调方法不同,传统微调通常通过提供一组示例调整模型行为,而RFT则侧重于通过与环境的互动来增强模型在特定情境中的表现,尤其是在生物学、医疗和法律等专业领域。

RFT的工作原理与应用领域

RFT的核心优势在于它能够使模型在特定任务上不断自我改进,发展出更加精准的推理能力。例如,在计算生物学领域,研究人员利用RFT优化了OpenAI的语言模型o1和o1-mini,帮助其更好地预测遗传疾病中的基因突变。在这种应用中,RFT不仅仅是简单地模仿现有的行为模式,它让模型通过强化学习掌握并推理复杂的医学数据。

案例研究:基因突变预测

在与伯克利实验室的计算生物学家贾斯汀(Justin)合作中,研究人员通过RFT训练了模型来识别与患者症状相关的遗传疾病基因。训练数据集包括约1,100个来自科学病例报告的示例,描述了患者症状及其相应的基因突变。为确保模型的泛化能力,使用了与训练数据集不同的验证数据集,避免了记忆训练集的情况发生。

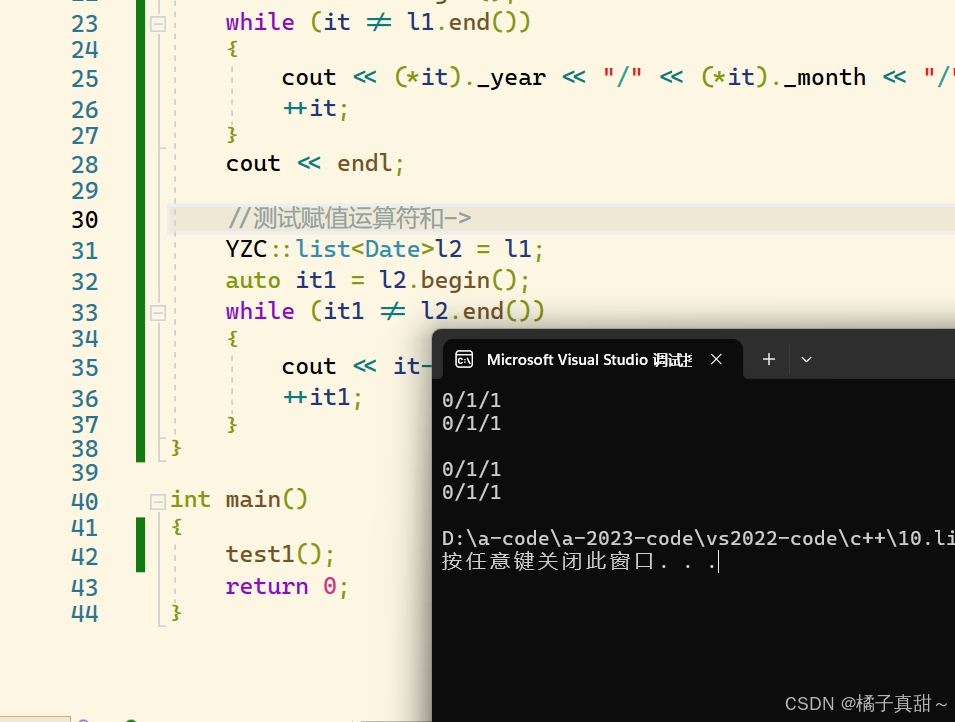

通过强化微调,模型能够在给定患者症状的情况下,列出可能的基因并附带每个基因的详细解释。评分机制通过评估模型输出的基因列表的准确性和排序,进一步优化模型的推理表现。

结果与评估

经过强化微调的o1-mini模型在基因预测的准确性和排名上表现优于基线模型,显示出RFT在提高模型推理能力方面的显著效果。研究人员还使用了可视化工具,将评估结果通过图表(如圣诞节主题图表)展示,进一步验证了模型在复杂数据集上的优越性。

RFT的未来与扩展

OpenAI目前正在扩展其Alpha计划,允许更多的研究人员和专业人士使用RFT进行模型微调。这一计划的推广意味着更多的领域(如人工智能安全、法律、医疗等)将能够充分利用强化微调带来的技术进步。OpenAI计划在明年初公开推出RFT产品,使其能够在更广泛的场景中应用。

总结

强化微调(RFT)通过强化学习算法显著提升了语言模型在专业领域中的推理能力,尤其是在医学和生物学等复杂领域的应用中。通过与领域专家的合作,RFT帮助解决了诸如遗传疾病基因预测等难题,展现了其强大的潜力。随着RFT在更多领域的推广,它将成为助力科学研究和专业决策的重要工具。