文章目录

- 前言

- 一、`model.cuda()`是什么?

- 二、使用步骤

- 1. 检查GPU是否可用

- 2. 选择设备

- 3. 移动模型到选定设备

- 4. 确保数据和模型在同一设备上

- 三、注意事项

- 总结

前言

本文旨在详细解释在PyTorch框架中model.cuda()方法的使用,以及与之相关的torch.cuda.device和torch.device的使用方式。这包括它们的作用、如何操作以及相关的注意事项,确保初学者能够完全理解并正确地将模型或数据移动到GPU上进行加速计算。

一、model.cuda()是什么?

model.cuda()是PyTorch框架中的一个方法,用于将模型(model)从CPU移动到GPU上,以便利用GPU的并行计算能力来加速深度学习模型的训练和推理过程。在PyTorch中,GPU通常被称为CUDA设备,因为NVIDIA的CUDA(Compute Unified Device Architecture)是广泛使用的GPU编程接口。

二、使用步骤

1. 检查GPU是否可用

在尝试将模型移动到GPU之前,首先需要检查是否有可用的GPU。这可以通过torch.cuda.is_available()函数来实现。

import torchif torch.cuda.is_available():print("GPU is available!")

else:print("GPU is not available. Using CPU instead.")

2. 选择设备

在PyTorch中,可以使用torch.cuda.device或torch.device来明确指定要使用的设备。torch.cuda.device是一个表示CUDA设备的对象,而torch.device则是一个更通用的设备表示,它可以表示CPU或GPU。

# 使用torch.cuda.device指定GPU设备

if torch.cuda.is_available():cuda_device = torch.cuda.device('cuda:0') # 指定编号为0的GPU# 使用torch.device指定设备,可以是CPU或GPU

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

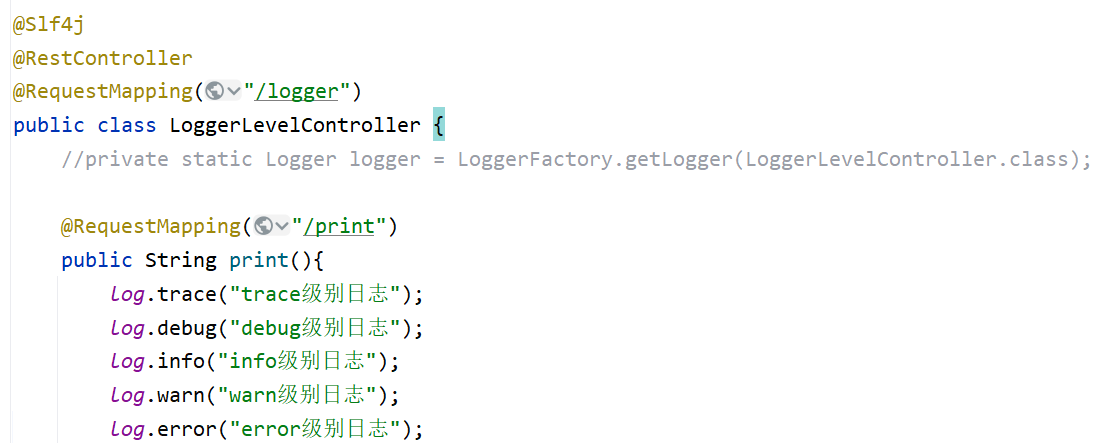

3. 移动模型到选定设备

使用.to(device)方法将模型移动到选定的设备上。这是比.cuda()更推荐的方式,因为它更加灵活,可以轻松地在CPU和GPU之间切换。

# 假设已经定义了一个模型

model = MyModel()# 将模型移动到选定的设备上

model = model.to(device)

4. 确保数据和模型在同一设备上

在进行计算时,需要确保数据和模型都在同一设备上(CPU或GPU)。这可以通过将数据也移动到选定的设备上来实现。

# 假设有一个数据张量data

data = torch.randn(3, 3)# 将数据移动到与模型相同的设备上

data = data.to(device)

三、注意事项

-

设备兼容性:确保你的GPU支持CUDA,并且已经安装了与PyTorch版本兼容的CUDA驱动程序和CUDA Toolkit。

-

内存管理:GPU的内存资源有限,因此在将大量数据或模型移动到GPU之前,需要评估内存需求,以避免内存溢出。

-

设备选择:在多GPU环境中,使用

torch.device来明确指定要使用的设备,这样可以避免混淆和错误。 -

代码可移植性:为了保持代码的可移植性,建议使用

.to(device)方法代替.cuda()方法,因为.to(device)方法更加灵活。 -

错误处理:在尝试将模型或数据移动到GPU时,务必添加错误处理逻辑,以处理可能出现的设备不可用或内存不足等异常情况。

-

设备名称:在

torch.device中,CPU设备可以用'cpu'表示,而GPU设备可以用'cuda'、'cuda:0'、'cuda:1'等表示,其中数字表示GPU的编号。

总结

本文详细介绍了在PyTorch中使用model.cuda()方法以及与之相关的torch.cuda.device和torch.device的使用方式。通过检查GPU可用性、选择设备、移动模型和数据到选定设备以及注意设备兼容性、内存管理、设备选择、代码可移植性和错误处理等方面,初学者可以轻松地掌握这一技能,并有效地利用GPU资源来加速深度学习模型的训练和推理过程。使用.to(device)方法是更加灵活和推荐的方式,因为它可以轻松地在CPU和GPU之间切换,并提高代码的可移植性。