DIFY教程第一集:安装Dify配置环境

一、Dify的介绍

https://dify.ai/

Dify 是一款创新的智能生活助手应用,旨在为您提供便捷、高效的服务。通过人工智能技术, Dify 可以实现语音

助手、智能家居控制、日程管理等功能,助您轻松应对生活琐事,享受智慧生活。简约的界面设计,让操作更加便

捷;丰富的应用场景,满足您多样化的需求。 Dify ,让生活更简单!

二、Dify的安装方式

1. 在线体验

速度比较慢。不推荐

2. 本地部署

2.1 Docker 安装

安装 Docker 环境

bash <(curl -sSl

https://cdn.jsdelivr.net/gh/SuperManito/LunuxMirrors@main/DockerInstallation.sh) 安装 Docker Compose

curl -L "https://github.com/docker/compose/releases/latest/download/docker-compose-$(uname -

s)-$(uname -m)" -o /usr/local/bin/docker-compose && chmod +x /usr/local/bin/docker-compose 执行查看 Docker-compose 版本

docker-compose --version

说明安装成功了

docker-compse 拉取镜像很慢

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": [

"https://do.nark.eu.org",

"https://dc.j8.work",

"https://docker.m.daocloud.io",

"https://dockerproxy.com",

"https://docker.mirrors.ustc.edu.cn",

"https://docker.nju.edu.cn"

]

}

EOF 执行上面的代码

sudo systemctl daemon-reload # 重新加载 systemd 的配置文件

systemctl restart docker # 重启docker 然后去 GitHub 上拉取 dify 的代码。解压后进入到 docker 目录中

docker-compose up -d 执行即可

2.2 DockerDeskTop

在 Windows 环境下我们可以通过 DockerDesktop 来安装。直接去官网下载对应的版本即可。同样的我们需要拉

取 dify 的 GitHub 的代码。然后进入到 Docker 目录,同样的执行这个代码

docker-compose up 然后在地址栏中输入 http://localhost/install 就可以访问了

然后在地址栏中输入 http://localhost/install 就可以访问了 我们先设置管理员的相关信息。设置后再登录

我们先设置管理员的相关信息。设置后再登录

3. Ollama

https://ollama.com/

我们已经把 Dify 在本地部署了。然后我们可以通过 Ollama 在本地部署对应的大模型,比如 deepseek-r1:1.5b 这

种小模型

Ollama 是一个让你能在本地运行大语言模型的工具,为用户在本地环境使用和交互大语言模型提供了便利,具有以下

特点:

1 )多模型支持: Ollama 支持多种大语言模型,比如 Llama 2 、 Mistral 等。这意味着用户可以根据自己的需求和场

景,选择不同的模型来完成各种任务,如文本生成、问答系统、对话交互等。

2 )易于安装和使用:它的安装过程相对简单,在 macOS 、 Linux 和 Windows 等主流操作系统上都能方便地部署。

用户安装完成后,通过简洁的命令行界面就能与模型进行交互,降低了使用大语言模型的技术门槛。

3 )本地运行: Ollama 允许模型在本地设备上运行,无需依赖网络连接来访问云端服务。这不仅提高了数据的安全性

和隐私性,还能减少因网络问题导致的延迟,实现更快速的响应。

搜索 Ollama 进入官网 https://ollama.com/download ,选择安装MAC版本的安装包,点击安装即可

下载完成后直接双击安装即可

命令:ollama,出现下面内容,说明安装成

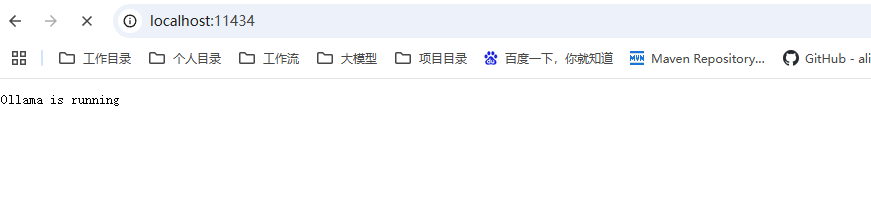

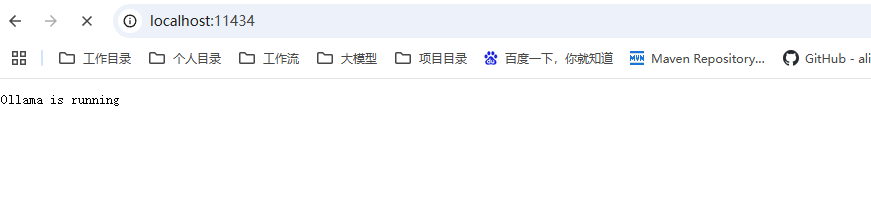

启动 Ollama 服务

输入命令【 ollama serve 】,浏览器打开,显示running,说明启动成功

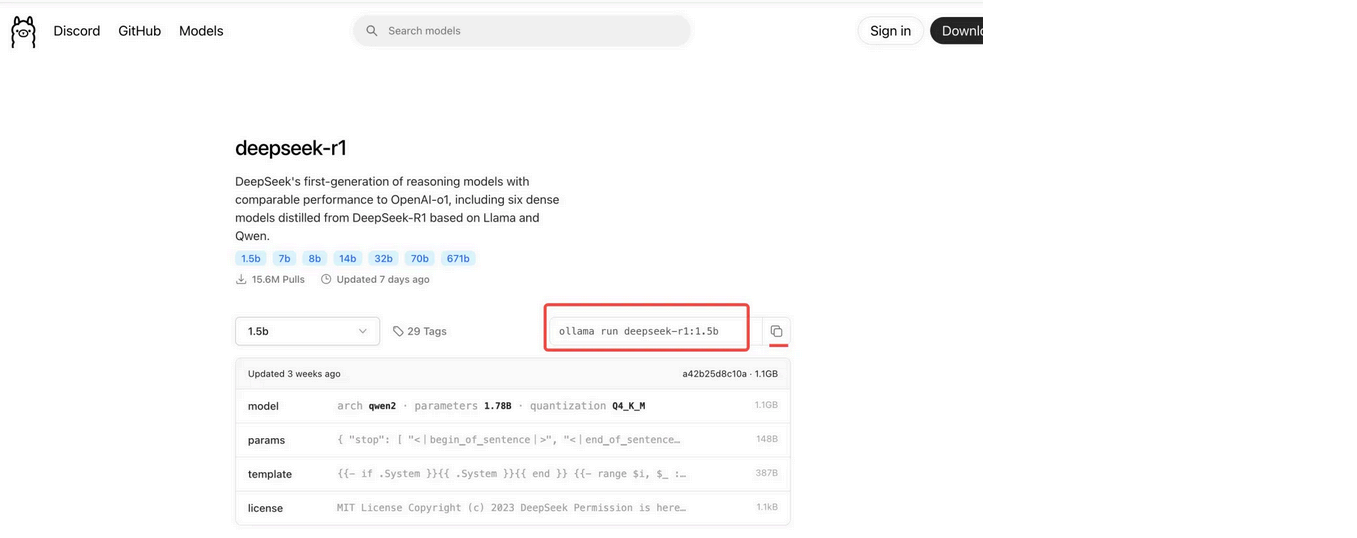

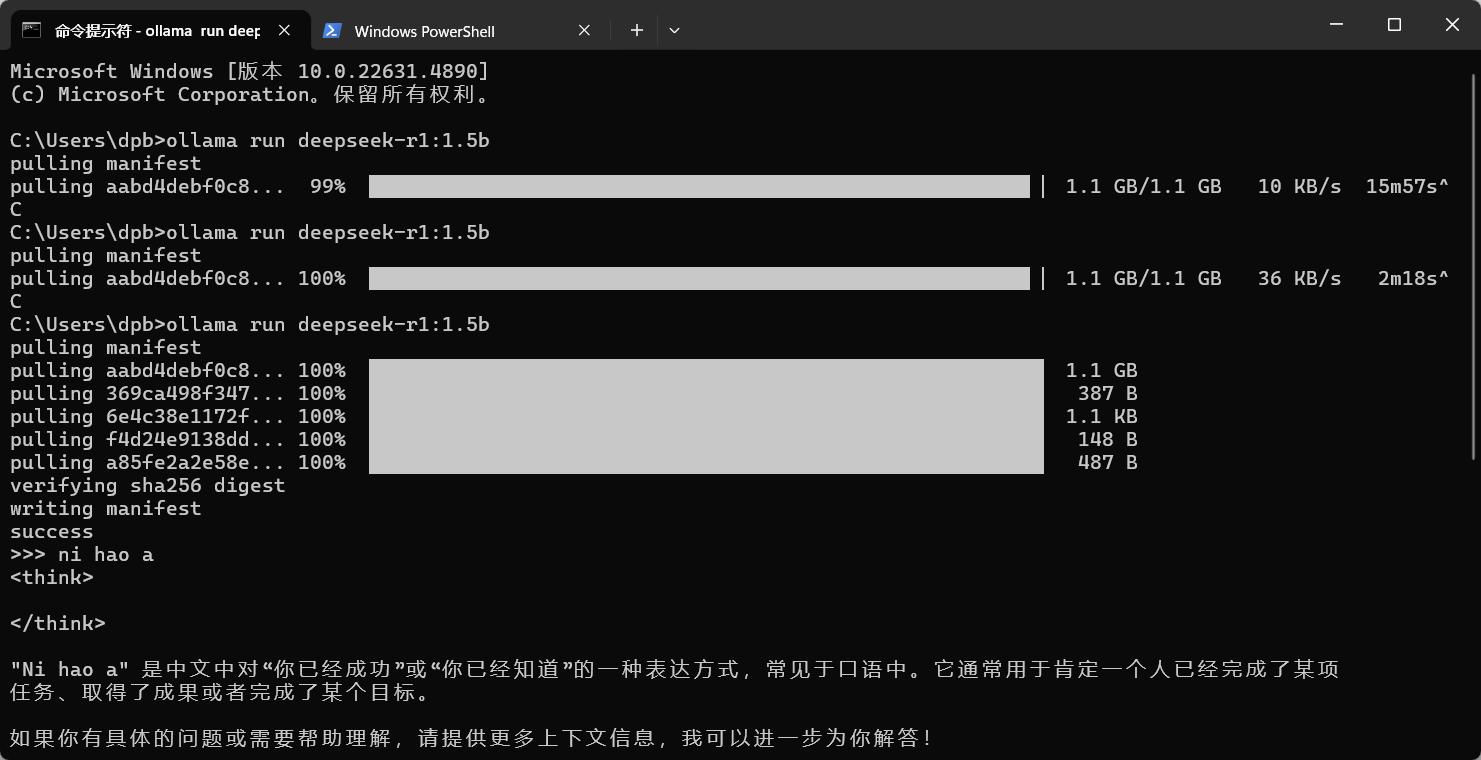

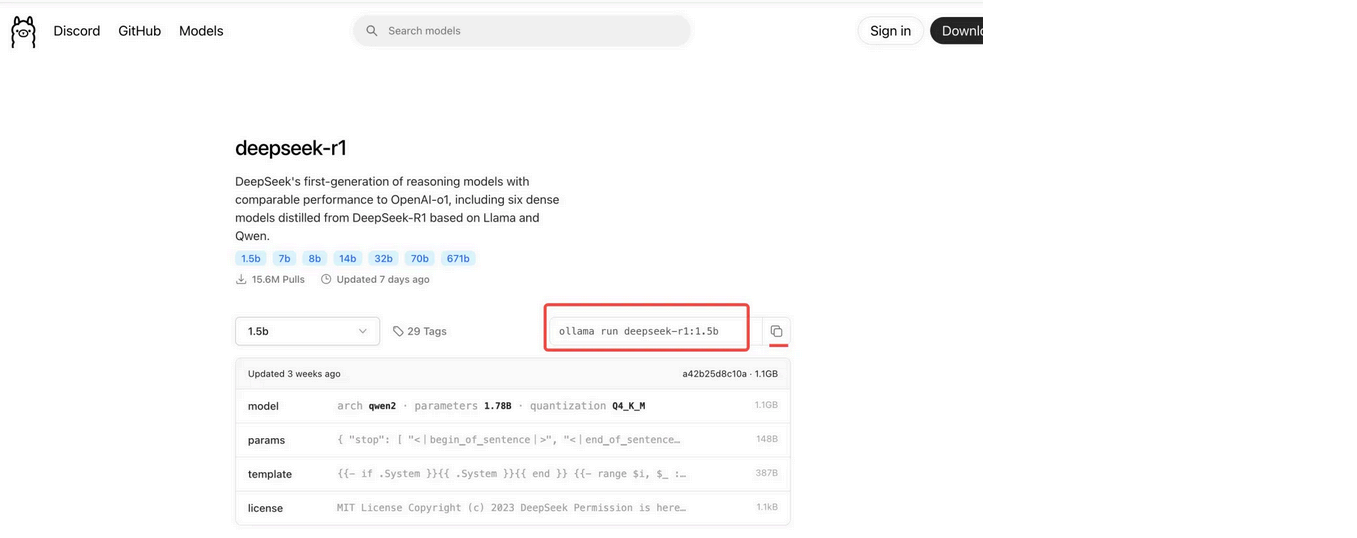

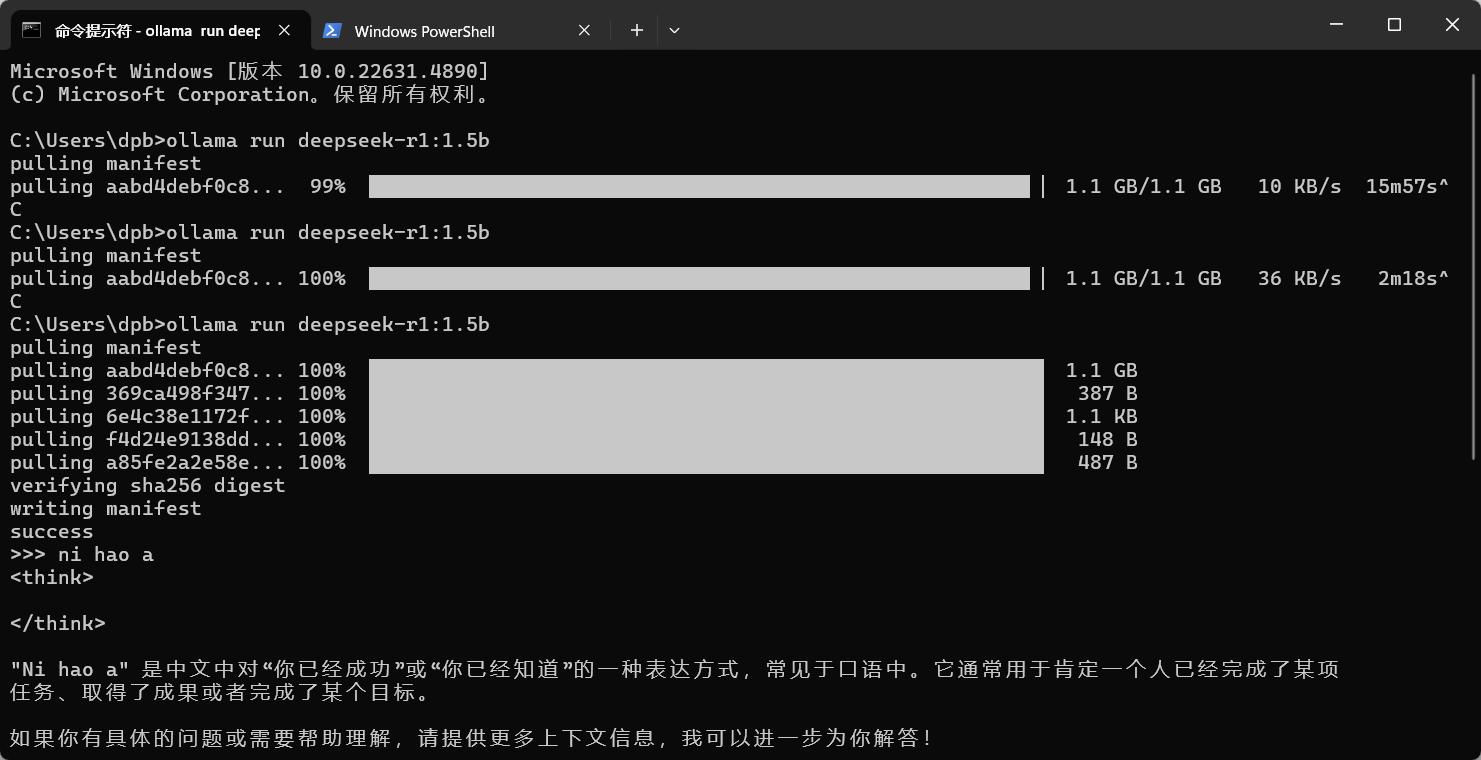

安装 deepseek-r1:1.5b 模型

在 https://ollama.com/library/deepseek-r1:1.5b 搜索 deepseek-R1, 跳转到下面的页面,复制这个命令,在终端执

行,下载模型  cmd中执行这个命令

cmd中执行这个命令

cmd中执行这个命令

cmd中执行这个命令

4.Dify关联Ollama

Dify 是通过 Docker 部署的,而 Ollama 是运行在本地电脑的,得让 Dify 能访问 Ollama 的服务。

在 Dify 项目 -docker- 找到 .env 文件,在末尾加上下面的配置:

# 启用自定义模型

CUSTOM_MODEL_ENABLED=true

# 指定 Olama 的 API地址(根据部署环境调整IP)

OLLAMA_API_BASE_URL=host.docker.internal:11434 然后在模型中配置

在 Dify 的主界面 http://localhost/apps ,点击右上角用户名下的【设置】  在设置页面--Ollama--添加模型,如下:

在设置页面--Ollama--添加模型,如下:  添加成功后的

添加成功后的

在设置页面--Ollama--添加模型,如下:

在设置页面--Ollama--添加模型,如下:  添加成功后的

添加成功后的

模型添加完成以后,刷新页面,进行系统模型设置。步骤:输入 “ http://localhost/install ” 进入 Dify 主页,用户名 -- 设 置--模型供应商,点击右侧【系统模型设置】,如下:  这样就关联成功了!!!

这样就关联成功了!!!

这样就关联成功了!!!

这样就关联成功了!!! 下一集:DIFY搭建知识库

Dify教程目录

一、Dify的介绍

二、Dify的安装方式

1. 本地部署

2. Docker安装

3.Ollama

4.Dify关联Ollama

三、Dify应用讲解

1. 创建空白应用

2. 创建本地知识库

3.知识库应用

4. AI图片生成工具

5. 旅游助手

6. SQL执行器

7. 科研论文翻译

8. SEO翻译

9. 标题覚文案生成

10.知识库图像检索和展示

11.自然语言生成SQL

12. Echarts可视化助手

.........

持续更新中,如需DIFY全流程文档可关注博主,查看私信获取哦