理解如何通过训练来实现学习推理的scaling law,我们首先需要定义几个关键概念,然后解释它们如何通过训练和模型的扩展(scaling)来实现推理能力的提升。

学习推理

学习推理是指模型通过训练能够从数据中学习出如何进行推理、推断和决策的能力。这通常表现为在未知或复杂的任务中,模型能够基于已知的输入做出合理的预测或推理。推理任务包括但不限于:

归纳推理(Inductive Reasoning):

从一些例子推导出一般性的规律或概念。

演绎推理(Deductive Reasoning):

从普遍的规律推导出具体的结论。

类比推理(Analogical Reasoning):

通过类比已知的事物来推测未知事物的性质。

在深度学习模型中,推理能力通常是通过模型的训练和架构来实现的,尤其是大规模的预训练和更复杂的模型结构对推理能力的提升至关重要。

2. Scaling Law(规模法则)

在机器学习中,特别是大规模神经网络(如Transformer、GPT等)中,scaling law指的是随着模型规模的扩大(如参数数量、数据量、计算能力等),模型的性能会以某种规律提高。具体到推理能力,scaling law主要表现在以下几个方面:

模型大小与性能关系:

随着神经网络的规模增大,尤其是模型参数数目增多,模型的表现会得到显著提升。

更大的模型能够捕捉更复杂的规律,从而提升推理和理解的能力。

数据规模与性能关系:

训练数据的增加通常会导致性能的提升。

更多的训练数据帮助模型更好地理解和掌握任务中的潜在模式和规律,从而在推理任务中表现得更好。

计算资源与性能关系:

随着计算能力的增加,能够训练更大的模型,进行更长时间的训练,或使用更复杂的算法。

这些都可以帮助模型更好地推理。

3. 如何通过训练实现学习推理的Scaling Law

为了实现学习推理的scaling law,需要遵循以下几个训练原则和策略:

(1)增加模型的规模(Model Scaling)

更大的模型通常意味着更多的参数,能够捕捉到更多的数据模式,进而提升推理能力。例如,GPT模型和BERT模型等大型预训练模型证明了参数数量对推理性能的重要性。

大规模预训练:

使用大规模的语料库对模型进行预训练,允许模型在各种任务上学习丰富的语言规律、推理能力和常识。

增加模型层数和参数:

增加神经网络的层数(深度)和每一层的宽度(神经元数量),使得模型能够更好地学习复杂的推理任务。

(2)增加数据量(Data Scaling)

数据规模的增加通常会直接影响模型的推理能力,尤其是在复杂推理任务中,模型需要更多的数据来学习潜在的推理模式和规律。

无监督预训练:

利用大量的无标签数据进行预训练,模型可以通过自监督学习的方式理解语言的结构和推理。

多任务学习:

通过训练模型在多个相关任务上获得丰富的经验,模型能够在不同类型的推理任务中取得更好的泛化性能。

(3)增加计算能力(Compute Scaling)

随着计算能力的提升,尤其是更强的GPU、TPU等硬件,能够支持更大的模型和更多的训练数据。这使得可以训练出能够进行复杂推理的更大规模的神经网络。

长时间训练:

更强的计算资源支持模型在更长时间内训练,使得模型能够逐渐逼近任务的最优解。

并行化训练:

利用分布式计算和并行训练加速大规模模型的训练,能够更高效地探索参数空间。

(4)推理任务设计和优化

推理能力的提升不仅仅依赖于模型规模和数据量,还需要合理的任务设计和优化策略。

推理任务的构建:

设计具有推理性质的任务,如数学推理、逻辑推理、语言推理等任务,以让模型从训练中学习如何处理复杂的推理问题。

层次化任务:

从简单的推理任务开始,逐步增加任务的复杂性,通过逐步学习增强模型的推理能力。

(5)结合多模态学习和知识注入

在传统的语言推理中,文本数据的规模和深度非常重要。然而,现实世界的推理通常需要跨越多个领域(如图像、文本、声音等)。多模态学习可以通过结合不同模态的数据来增强推理能力。

跨模态推理:

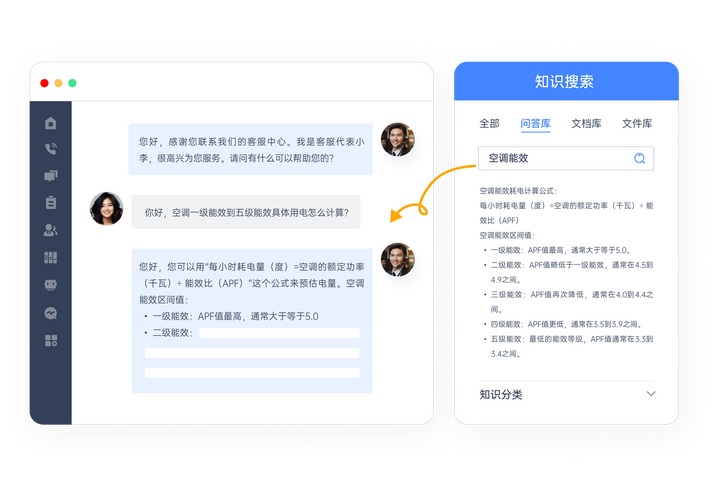

比如,结合视觉和语言的模型(如视觉语言模型CLIP、Flamingo)可以进行更复杂的推理任务,因为它不仅仅局限于语言推理,还能理解视觉信息。

知识注入:

通过在模型中注入外部知识(如知识图谱),可以帮助模型在进行推理时,参考已知的知识和事实,提升推理准确性。

4.训练中实现学习推理的Scaling Law

通过增加模型规模、扩展训练数据、提高计算资源以及合理的任务设计,可以促进模型学习更复杂的推理能力,这一过程遵循scaling law。具体来说,随着模型规模、数据量和计算资源的增加,模型能够更好地进行推理,且训练过程中的优化也会帮助模型在推理任务上获得显著提升。推理能力的提升不仅仅依赖于传统的语言建模,还需要跨模态、多任务、知识注入等多方面的创新和设计。

![vue面试题9|[2024-11-15]](https://i-blog.csdnimg.cn/direct/ca22d3118aeb429aafb3ccf0f3d7025d.jpeg)