LoRA(Low - Rank Adaptation,低秩自适应 )微调技术改进创新点

LoRA(Low - Rank Adaptation,低秩自适应 )微调技术改进创新点

模型参数层面

- 低秩分解创新:LoRA核心是对权重矩阵低秩分解,将原始权重矩阵分解为固定的预训练权重部分和可训练的低秩变化量部分。传统全量微调需更新全部参数,而LoRA只更新低秩矩阵参数,大幅减少可训练参数数量,如在GPT - 3实验中可将可训练参数数量减少10,000倍 ,降低存储和计算成本。比如在大型Transformer架构模型中,通过这种方式,在不改变模型整体架构和预训练权重前提下,以少量参数调整适应下游任务。

- 避免过拟合:采用权重衰减等正则化技术,在训练过程中对低秩矩阵参数进行约束,防止参数过度拟合训练数据,提高模型泛化能力。相较于传统微调易出现过拟合现象,LoRA能让模型在新数据上表现更稳健。

训练效率层面

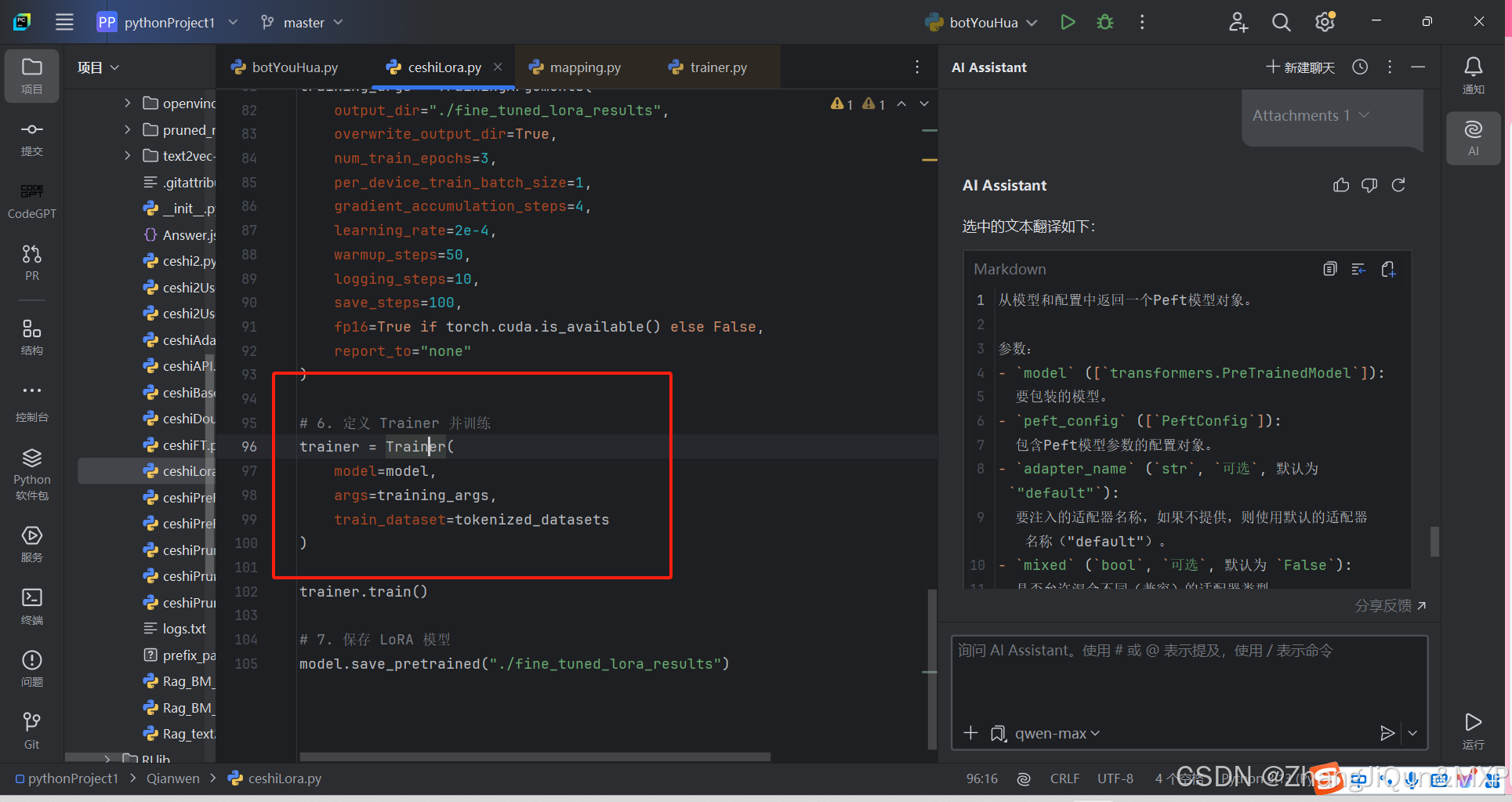

- 训练速度提升:因更新参数少,计算