引言

人工智能(AI)作为一门跨学科的科学,其学习框架是构建智能系统的核心。随着技术的飞速发展,AI已经渗透到我们生活的方方面面,从语音助手到自动驾驶汽车,从医疗诊断到金融分析。本文旨在非论文形式下,条理清晰地介绍人工智能学习框架,帮助读者理解AI的基本原理和构建方法。

人工智能的三大支柱

1. 数据(Data)

数据是人工智能的燃料,为算法提供训练和验证所需的信息。高质量的数据集是构建有效AI系统的关键。数据不仅需要量大,还要多样化,以确保模型能够泛化到不同的场景。数据收集涉及从多个来源获取信息,包括公开数据集、传感器数据、用户行为日志等。这些数据需要经过清洗、标注和存储,以便于后续的处理和分析。

数据收集

# 示例:使用Python请求公开数据集

import requestsurl = "https://example.com/api/dataset"

response = requests.get(url)

data = response.json()# 假设数据是JSON格式,这里进行简单的解析

for item in data:print(item['feature'], item['label'])数据清洗

# 示例:使用Pandas库清洗数据

import pandas as pd# 假设df是Pandas DataFrame,包含数据集

df = pd.read_csv('dataset.csv')# 去除缺失值

df = df.dropna()# 去除重复值

df = df.drop_duplicates()# 保存清洗后的数据

df.to_csv('cleaned_dataset.csv', index=False)数据标注

# 示例:简单的数据标注过程,这里假设是一个图像标注任务

from PIL import Imagedef annotate_image(image_path, label):image = Image.open(image_path)# 显示图像并进行标注image.show()return label # 返回标注结果# 假设有一个图像列表和对应的标签列表

image_paths = ['image1.jpg', 'image2.jpg']

labels = [1, 0]annotated_data = []

for path, label in zip(image_paths, labels):annotated_data.append(annotate_image(path, label))数据存储

# 示例:使用SQLAlchemy存储数据到数据库

from sqlalchemy import create_engine# 创建数据库引擎

engine = create_engine('sqlite:///database.db')# 假设df是Pandas DataFrame,包含数据集

df = pd.read_csv('cleaned_dataset.csv')# 存储数据到数据库

df.to_sql('table_name', con=engine, if_exists='replace', index=False)2. 算法(Algorithm)

算法是AI的大脑。它们定义了如何从数据中学习模式和做出决策。主要的算法包括:

- 机器学习(Machine Learning):通过数据训练模型,使计算机能够执行特定任务。

- 深度学习(Deep Learning):使用多层神经网络模拟人脑处理信息的方式。

- 强化学习(Reinforcement Learning):通过与环境的交互学习最优策略。

机器学习

# 示例:使用scikit-learn进行简单的线性回归

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error# 假设X和y是特征和标签

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

model = LinearRegression()

model.fit(X_train, y_train)# 预测和评估

predictions = model.predict(X_test)

mse = mean_squared_error(y_test, predictions)

print(f'Mean Squared Error: {mse}')深度学习

# 示例:使用TensorFlow构建简单的神经网络

import tensorflow as tf

from tensorflow.keras import layersmodel = tf.keras.Sequential([layers.Dense(64, activation='relu', input_shape=(input_shape,)),layers.Dense(64, activation='relu'),layers.Dense(1)

])model.compile(optimizer='adam', loss='mean_squared_error')

model.fit(train_data, train_labels, epochs=10)强化学习

# 示例:使用OpenAI Gym环境进行强化学习

import gym# 创建环境

env = gym.make('CartPole-v1')# 简单的Q-learning算法

for episode in range(1000):state = env.reset()done = Falsewhile not done:action = env.action_space.sample() # 随机选择动作state, reward, done, info = env.step(action)# 这里省略了Q-learning的更新步骤3. 计算能力(Computing Power)

计算能力是AI的肌肉。随着GPU和TPU等专用硬件的发展,AI的计算能力得到了极大的提升,使得复杂的深度学习模型成为可能。

GPU和TPU

# 示例:使用TensorFlow在GPU上运行模型

import tensorflow as tf# 指定GPU设备

with tf.device('/GPU:0'):model.fit(x_train, y_train, epochs=10)云计算

# 示例:使用AWS SDK for Python(Boto3)启动一个EC2实例

import boto3ec2 = boto3.resource('ec2')

instance = ec2.create_instances(ImageId='ami-0c94855ba95c71c99',MinCount=1,MaxCount=1,InstanceType='t2.micro'

)人工智能学习框架的构建

1. 确定问题和目标

在开始构建AI系统之前,首先需要明确要解决的问题和预期目标。这将决定数据收集的类型和算法的选择。

问题定义

# 示例:定义问题和目标的伪代码

problem_definition = "预测房价"

objective = "构建一个回归模型,预测房价"目标设定

# 示例:将目标转化为可量化的指标

goals = {"accuracy": 0.9,"training_time": "2 hours"

}2. 数据预处理

数据预处理是确保数据质量的关键步骤,包括数据清洗、标准化、归一化和特征工程等。

数据清洗

# 示例:使用Pandas库清洗数据

import pandas as pd# 假设df是Pandas DataFrame,包含数据集

df = pd.read_csv('dataset.csv')# 去除缺失值

df = df.dropna()# 去除重复值

df = df.drop_duplicates()# 保存清洗后的数据

df.to_csv('cleaned_dataset.csv', index=False)标准化和归一化

# 示例:使用Scikit-learn进行数据标准化

from sklearn.preprocessing import StandardScalerscaler = StandardScaler()

data_scaled = scaler.fit_transform(data)特征工程

# 示例:使用Pandas进行特征选择

import pandas as pddf = pd.read_csv('cleaned_dataset.csv')

selected_features = df[['feature1', 'feature2', 'feature3']]3. 选择模型

根据问题的性质选择合适的模型。例如,对于图像识别任务,卷积神经网络(CNN)可能是一个好选择;而对于自然语言处理任务,循环神经网络(RNN)或Transformer模型可能更为合适。

模型选择

# 示例:选择模型的伪代码

if problem == 'image_recognition':model = 'CNN'

elif problem == 'text_classification':model = 'RNN'超参数调优

# 示例:使用GridSearchCV进行超参数调优

from sklearn.model_selection import GridSearchCVparam_grid = {'n_estimators': [50, 100, 150], 'max_depth': [2, 4, 6]}

grid_search = GridSearchCV(estimator, param_grid, cv=5)

grid_search.fit(X_train, y_train)4. 训练和验证

使用训练数据集训练模型,并使用验证数据集来评估模型的性能。这一步骤可能需要多次迭代,以调整模型参数和防止过拟合。

训练

# 示例:使用TensorFlow训练模型

model.fit(x_train, y_train, epochs=10, validation_data=(x_val, y_val))验证

# 示例:使用Scikit-learn验证模型

from sklearn.model_selection import cross_val_scorescores = cross_val_score(model, X, y, cv=5)

print(f'Average Cross-Validation Score: {scores.mean()}')5. 测试和部署

在测试数据集上评估模型的最终性能,并根据结果进行必要的调整。一旦模型达到满意的性能,就可以部署到实际应用中。

测试

# 示例:使用TensorFlow测试模型

model.evaluate(x_test, y_test)部署

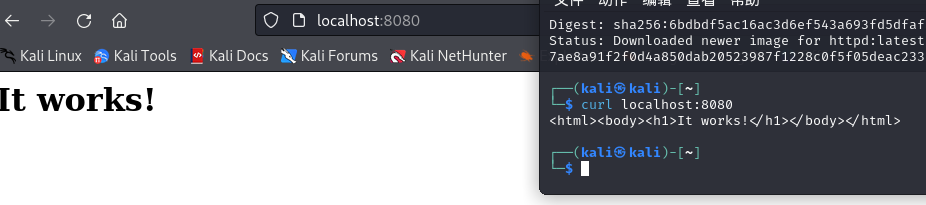

# 示例:使用Flask部署模型

from flask import Flask, request, jsonify

from model import predictapp = Flask(__name__)@app.route('/predict', methods=['POST'])

def predict():data = request.get_json(force=True)prediction = predict(data)return jsonify(prediction)if __name__ == '__main__':app.run()6. 监控和维护

部署后,需要持续监控模型的性能,并根据新的数据和反馈进行维护和更新。

性能监控

# 示例:监控模型性能的伪代码

while True:current_performance = evaluate_model()if current_performance < desired_performance:update_model()模型更新

# 示例:使用Scikit-learn更新模型

model.partial_fit(x_new, y_new)人工智能学习框架的关键技术

1. 自然语言处理(NLP)

NLP是AI中处理和理解人类语言的关键技术,包括语言模型、情感分析、机器翻译等。它使机器能够理解、生成和翻译人类语言,广泛应用于搜索引擎、聊天机器人和语音助手。

语言模型

# 示例:使用Hugging Face Transformers库构建语言模型

from transformers import GPT2Tokenizer, GPT2LMHeadModeltokenizer = GPT2Tokenizer.from_pretrained('gpt2')

model = GPT2LMHeadModel.from_pretrained('gpt2')input_ids = tokenizer.encode("Hello, world!", return_tensors='pt')

outputs = model.generate(input_ids, max_length=50)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))情感分析

# 示例:使用TextBlob进行情感分析

from textblob import TextBlobtext = "I love this product!"

blob = TextBlob(text)

sentiment = blob.sentiment

print(f'Polarity: {sentiment.polarity}, Subjectivity: {sentiment.subjectivity}')机器翻译

# 示例:使用Google Cloud Translation API进行机器翻译

from google.cloud import translate_v2 as translate

translate_client = translate.Client()results = translate_client.translate('Hello, world!', target='es')

print(results['translatedText'])2. 计算机视觉(CV)

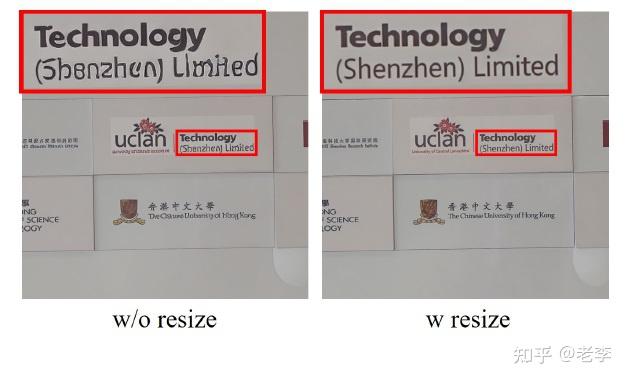

CV使计算机能够理解和解释视觉信息,包括图像识别、目标检测和图像分割等。它在安全监控、医疗诊断和自动驾驶等领域有着广泛的应用,使机器能够“看”和“理解”图像内容。

图像识别

# 示例:使用OpenCV进行图像识别

import cv2# 加载预训练的模型

model = cv2.ml.SVM_Load('svm_model.xml')# 读取图像

image = cv2.imread('image.jpg', cv2.IMREAD_GRAYSCALE)# 预处理图像

image = cv2.resize(image, (64, 64))

_, thresholded = cv2.threshold(image, 128, 255, cv2.THRESH_BINARY | cv2.THRESH_OTSU)# 预测

ret, labels = model.predict(thresholded.reshape(1, -1).astype('float32'))

print(f'Label: {labels[0][0]}')目标检测

# 示例:使用YOLO进行目标检测

import cv2# 加载预训练的模型

net = cv2.dnn.readNet('yolov3.weights', 'yolov3.cfg')# 读取图像

image = cv2.imread('image.jpg')# 预处理图像

blob = cv2.dnn.blobFromImage(image, 1/255, (416, 416), swapRB=True, crop=False)

net.setInput(blob)# 检测

layer_names = net.getLayerNames()

output_layers = [layer_names[i[0] - 1] for i in net.getUnconnectedOutLayers()]

outs = net.forward(output_layers)# 处理检测结果

for out in outs:for detection in out:scores = detection[5:]class_id = np.argmax(scores)confidence = scores[class_id]if confidence > 0.5:# 绘制边界框和标签center_x = int(detection[0] * image.shape[1])center_y = int(detection[1] * image.shape[0])w = int(detection[2] * image.shape[1])h = int(detection[3] * image.shape[0])图像分割

# 示例:使用OpenCV进行图像分割

import cv2

import numpy as np# 读取图像

image = cv2.imread('image.jpg')

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)# 应用阈值分割

ret, thresh = cv2.threshold(gray, 127, 255, 0)

contours, hierarchy = cv2.findContours(thresh, cv2.RETR_TREE, cv2.CHAIN_APPROX_SIMPLE)# 绘制轮廓

cv2.drawContours(image, contours, -1, (0, 255, 0), 3)# 显示结果

cv2.imshow('Segmented Image', image)

cv2.waitKey(0)

cv2.destroyAllWindows()3. 语音识别和合成

语音技术使AI能够理解和生成人类语音,广泛应用于语音助手和自动字幕生成等。语音识别将语音转换为文本,而语音合成则将文本转换为语音,两者都是实现人机交互的关键技术。

语音识别

# 示例:使用SpeechRecognition库进行语音识别

import speech_recognition as sr# 初始化识别器

recognizer = sr.Recognizer()# 使用麦克风录制音频

with sr.Microphone() as source:print("Please speak now...")audio = recognizer.listen(source)# 使用Google Web Speech API识别语音

try:print("Google Web Speech API thinks you said: " + recognizer.recognize_google(audio))

except sr.UnknownValue:print("Google Web Speech API could not understand audio")

except sr.RequestError as e:print("Could not request results from Google Web Speech API; {0}".format(e))语音合成

# 示例:使用gTTS库进行语音合成

from gtts import gTTS

import os# 将文本转换为语音

text = 'Hello, how are you?'

tts = gTTS(text=text, lang='en')

tts.save("hello.mp3")# 播放语音

os.system("mpg321 hello.mp3")4. 推荐系统

推荐系统通过分析用户行为和偏好,为用户提供个性化的内容推荐。它在电子商务、音乐和视频流媒体服务等领域有着广泛的应用,帮助用户发现感兴趣的产品和内容。

协同过滤

# 示例:使用Surprise库进行协同过滤

from surprise import SVD, Dataset, Reader

from surprise.model_selection import cross_validate# 加载数据

reader = Reader(line_format='user item rating', sep=',')

data = Dataset.load_from_file('ratings.csv', reader=reader)# 使用SVD算法

algo = SVD()# 交叉验证

cross_validate(algo, data, measures=['RMSE', 'MAE'], k=5, verbose=True)基于内容的推荐

# 示例:基于内容的推荐系统的伪代码

def content_based_recommendation(user_id, item_features, user_item_matrix):user_ratings = user_item_matrix[user_id]similar_items = find_similar_items(item_features, user_ratings)return similar_items结论

人工智能学习框架是构建智能系统的基础,涉及数据、算法和计算能力的有机结合。随着技术的不断进步,AI的应用领域将更加广泛,对社会的影响也将更加深远。理解并掌握这些框架,对于任何希望在AI领域取得成功的人来说都是至关重要的。