预训练发展

- 1.ELMo

- 2.GPT

- 3.Bert

- 3.1Ernie-baidu

- 3.2Ernie- Tsinghua

- 4.GPT2

- 5.UNILM

- 6.Transformer-XL & XLNet

- 6.1方案一

- 6.2方案三

- 7.Roberta

- 8.SpanBert

- 8.1SBO简介:

- 9.ALBERT

- 9.1方案一

- 9.2方案二

- 9.3方案三

- 10.T5

- 11.GPT3

- 12.从"续写"到"回答"

- 12.1SFT训练

- 12.2RLHF

- 12.2.1RW

- 12.2.2RL

- 13.NLP迭代

1.ELMo

简介: 首次提出预训练的模型,采用的是LSTM模型进行训练的, 然后和词向量拼接到一起送入到下游的RNN中,去做具体的工作。

结论: 预训练是一种通用的提升效果的手段

2.GPT

介绍: 早于BERT,启用了Transformer作为核心编码器。开始使用特有token连接不同句子。

训练简介: 语言模型采取单向,自回归训练,在语言模型预训练的基础上,增加了有监督任务训练。在这之后就很少有使用LSTM来做预训练任务的了。

3.Bert

两个训练任务: 1. MASK LM任务 2. Next Sentence Predict任务

3.1Ernie-baidu

改进点: Mask随机token -> Mask实体或词组;

优劣:

- 优: 这种做法在本质上相当于在预训练中加入了先验知识,可以更好的学习该语言

- 劣: 但是这也意味着对未知语言可能会无法使用该策略,因为未知语言,没法获取到其中的词或者实体的信息。

3.2Ernie- Tsinghua

改进点: 引入知识图谱,将实体信息融合到预训练任务中,从下图中可以看到,在下游fine-tune修改。对于不同实体分类和关系分类引入了两种token来加强模型对实体信息的认知

总结: 上面两个的改进思路,都是强调了额外知识的重要性;虽然最后并没有获取到非常好的效果,迁移性不强,但是可以是一种思路。

4.GPT2

简介: 继续使用单向语言模型,继续使用transformer结构(小改);改进: Bigger model,more data

重点: 强调zero-shot;任何一个任务,可以看做生成任务。所有任务都可以简化为输入和输出。就不再需要Fine-tuning

以翻译任务为例,希望语言模型输出:

问题点: 这样将每个任务固定token加入到训练的语料中,对数据的负担其实和采用下游任务微调没有区别。而且不可能穷举所有的任务。

但是: 大规模语言模型可以在不做有监督训练的情况下,完成许多任务。

5.UNILM

简介: 使用Bert的模型结构,同时进行Mask LM,单向LM,和seq2seq训练;使得预训练后模型可以更好的应用在生成式任务上:如机器翻译和机器摘要等。

释义: 即通过不同的mask,就可以在相同的模型结构上训练出不同模型任务能力;解决了Bert在生成式任务上的短板。

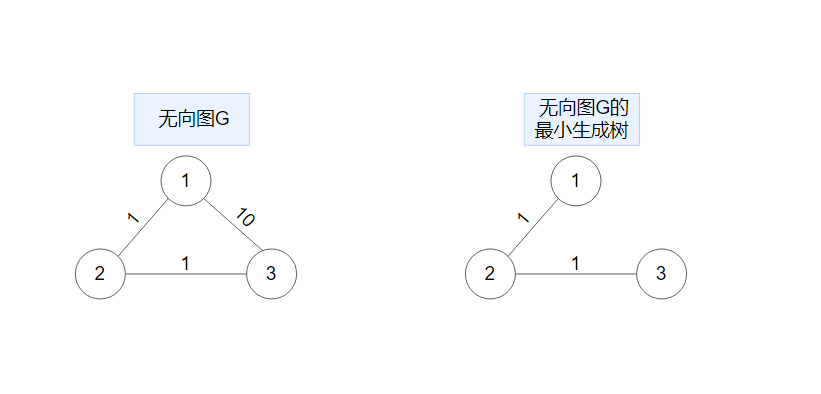

6.Transformer-XL & XLNet

目标: 希望解决Transformer的长度限制问题;

释义: 在Bert的基础版本中,由于位置编码的长度是512;意外着输入的文本长度不能超过512,不然就无法输入模型中计算或者被截断。做了很多改进方案,如下:

6.1方案一

方案: 循环机制 Recurrence Mechanism

思想: 借鉴RNN机制,将隐单元向量不断向后传递。在transformer模型中呢,则是将前一段文本的隐向量与后一段文本印象里拼接之后计算attention。即第一次输入的文本,在每一层模型都有输出,把这个保留,在后面一次输入的计算中加上,就默认是两次文本的了,补充了原来的上下文内容。

下面是公式,不做详细介绍:

## 方案二

## 方案二

方案: 相对位置编码 Relative Positional Encodings;当然当前大语言模型所使用的位置编码和这里的已经有很大不同了。

详细介绍:

- 这个方案,从下面这个公式出发:

- E、和U可以理解为BERT中的文本向量化和位置编码,这里通过Wq和Wk就是selft-attention的q、k需要过的线性层。

- 通过上面的是子相乘后,得到下面的公式,即四个式子之和。当前要做的是位置的编码,所以变化的也是带有U的,因为

U是位置编码内容。

4. Uj使用一个矩阵Ri-j来表示,这个值是不可训练的,代表的是两个字之间的相对位置。

5. u、v是可训练的参数,代表的是原来的Ui。

6.2方案三

前言:

-

AR语言模型 auto regressive language model;

单向预测下一个字

缺点:缺少双向信息 -

AE语言模型 auto encoding language model;

双向信息输入,预测中间某个mask的字

缺点:引入了[mask],但实际任务中不不存在

改进方案: AR语言模型与AE语言模型融合;Permutation Language Model;调整句子顺序,之后进行单向预测

释义: 将原来的句子:1-2-3-4;位置打乱,变成2-4-3-1;打乱成多种情况,通过2-4;预测3;通过2-4-3预测1;就是顺序是混乱的,使得预测一个字时,既有前面的信息,又有后面的信息.

7.Roberta

简介: 模型结构不变,和BERT相似,但是对训练方式进行了调整。

改进点

更多的数据,更大的batch size,更久的训练去掉next sentence prediction ;Bert有两个训练任务,其中预测上下句之间关系的任务摒弃了。使用更长的样本动态改变mask位置。在原来的Bert中,同一个样本,每次训练都mask同一个词,动态是指,现在随机改变。相当于有了更多的语料,使得模型能够学习到更多的知识。

结论: 挖掘旧的方法的潜力,有时比创新还要有效;能够最大限度的发挥一种算法的能力,是算法工程师能力的体现。

8.SpanBert

与BERT的主要区别有三个:

1.去掉了next sentence prediction任务

2.随机mask几个连续的token

3.新的预训练任务SBO(Span Boundary Objective)

8.1SBO简介:

释义:

- Xs-1代表mask片段之前的第一个token的Embedding

- Xe+1代表mask片段之后的第一个token的Embedding

- Pi-s+1代表目标token的Position Embedding,这个位置编码是指遮住的mask中的位置编码。

- 计算一个token的loss值时,处理mask的任务还要加上SBO任务;SBO任务代表着这个token与前后文的关系和mask中的信息。

结论: 大模型+更多的数据不是唯一出路,改变训练目标也有很大影响。

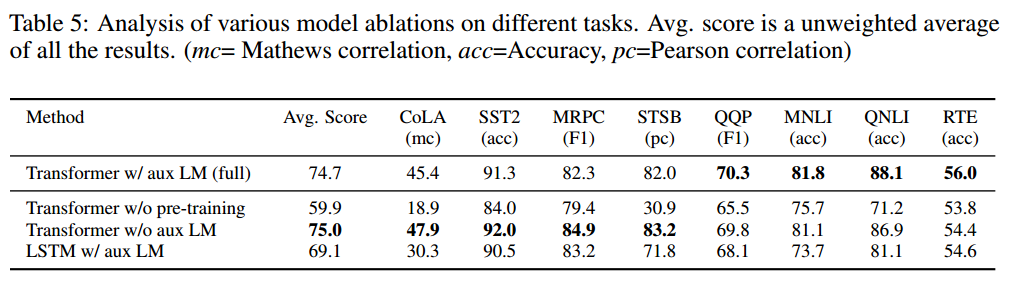

9.ALBERT

解决问题: 试图解决Bert模型过大的问题;想办法减少参数量。

9.1方案一

介绍: Factorized embedding parameterization;Embedding层的因式分解

举例:

Factorized embedding parameterization

O(V × H) -> O(V × E + E × H)

V = 词表大小 30000

H = 隐单元个数 1024

E = 指定Embedding大小 512 (原生Bert无此参数)

参数量

V x H = 30720000

V x E + E x H = 15360000 + 524288 = 15884288

释义:

- embedding词,如果向量的维度是1024,那么3万个词的参数就是:30720000

- 将embedding的维度减小,比如减到512;这里代表着默认512维也能较好的表示词的含义,只是后续的网络训练中,还需要更大的维度才好

3.在2的基础上,即: 30000 *512;通过矩阵变换,乘以线性层: 512 * 1024即可

9.2方案二

介绍: Cross-layer parameter sharing;跨层参数共享

释义:

- 跨层参数共享,有多种共享方式:

只共享attention部分

只共享feed-forward部分

全部共享- 这里指的共享,

是指参数的值共享,比如:Bert的层数不变,每层的结构不变,只是他的每层使用的参数与其他层是相同的。

下面是一些效果:

**结论:**共享参数后,效果其实下降的并不多,可以接受。

9.3方案三

介绍: 直白来讲,就是增加训练的任务,SOP任务替代NSP任务,Sentence order prediction。

改进: 原来Bert的训练任务是判断上下两句话的关系,现在任务改成,两句话,谁是上句谁是下句。

举例:

预测两句话的前后关系,同样是二分类任务

[CLS] 你好啊bert [SEP] 好久不见 [SEP] -> Positive

[CLS] 好久不见 [SEP]你好啊bert [SEP] -> Negative

10.T5

简介: Text-to-Text Transfer Transformer;seq2seq理论上可以解决一切NLP问题。

比如:

分类问题:文本 -> 标签

命名实体识别:文本 -> 实体

摘要、翻译:文本 -> 文本

回归问题:文本 -> 0.1(字符串)

改进: 在训练方式上,比GPT2跟进一步,GPT2是在训练的语料中,添加某些具体的token任务标识;而T5采取更自然一些,通过自定义的token区分任务,共享模型和解码方式。

举例:

翻译

你 好 吗 -> How are you

摘要

原 文 本……. -> 摘 要 文 本…分类

A 股 市 场…. -> 金 融

11.GPT3

简介: 1750 亿参数量,是GPT-2的116倍;模型结构与GPT-2相同;继续使用单向语言模型预训练。

理念:

Pre-training + fine-tune ×

理由:

1、fine-tune需要的数据,经常是缺失的

2、fine-tune会涉及对模型进行改造,使其变复杂,并失去泛化性

3、人类学习做新任务并不需要很多样本

Pre-training + Zero-, One-, Few-shot √

12.从"续写"到"回答"

简介: 在前面中说的使用各种训练的方式,其实模型最后达到的还是一个续写的能力,基本所有的任务都用生成式来解决的话,更加理想的方式,模型永远生成文本,并且是用文本描述各种各种任务的答案。

在完成这个步骤的过程中,OpenAI的公司提供了一些关于chatGPT的训练方式,使得其又续写变为回答,如下:

在完成预训练后,再进行SFT和RLHF训练。

12.1SFT训练

训练过程 可以用下面示意图表示:

释义:

- 训练和seq2seq很像,权重完全是在

预训练的基础进行训练的- 在训练工程中,需要很多问答的数据,问题再< sep >前面,答案在后面,在训练计算loss时,则从

< sep >开始预测后面的内容。- 在这个过程中,

mask的形状和UNILM中Self-attention Masks一样。

12.2RLHF

12.2.1RW

简介: Reward model training,有称奖励模型,目的是模型输出结果进行一个打分,评判结果的优劣。

训练数据: 训练的数据是采用一个相同的问题,通过不同的模型、或者相同的模型得到不一样的答案,通过人工标注的方式,对同一个问题下的不同答案进行优劣排序。

模型公式如下:

训练释义:

- 将得到的相同问题下的不同答案,两两一组进行训练,排序在前面(两个一组的答案中相对较好的)答案,

即yw;相对较差的答案即为yl。- 根据

公式中x代表问题,y代表答案,分别经过模型打分后,相减求对数等计算,本质上就是相应训练出一个打分模型,能对优质的答案打分尽量高,较差的答案打分低,去区分。- rθ就是训练得到的一个交互式文本匹配模型,对问题和答案输出为

标量(0-1)匹配度。

12.2.2RL

简介: RL就是通过RW得到的奖励模型,对SFT微调后的模型,进行强化学习。

公式如下:

简要释义:

把公式拆分为1、2、3部分;简单来说,把RW奖励模型当作一个模型训练的教练,对模型输出进行打分,并作为loss,去进一步调优模型。

- 第一部分,即指的是RW奖励模型,对问题和SFT模型输出结果的打分。

- 第二部分,前面半截代表当前进行

强化训练的模型,对输入问题x,输出结果为y的概率;后面半截就是SFT模型的概率。比值打,说明强化学习改变很多,比值小,说明只是在SFT上进行小步的优化。

第一部分和第二部分,就是说明,用奖励模型去调优SFT模型,不希望有巨大的调整,因为SFT后,模型本身就是比较好的状态,不应该有较大的调整。- 第三部分,即将

把模型的强化学习当作预训练过程来进行loss计算,调优,针对生成答案的每个字、词的权重进行优化。当然这步可以取消。

13.NLP迭代

简介: 简单来说,在人工智能的发展过程中,是逐渐剥离掉了人的主观因素,将大量的数据交由模型自己去寻找和总结自己的规律的过程。从最开始1,人类去总结规律,通过代码去实现的方式(if -else);到2,人类去标注出规律,设计模型的结构,通过数据让机器去学习规律。到3,人类提供大量的数据,让模型去寻找和获取其中的规律;到4,训练的目标都由模型去对齐,就是强化学习