note

文章目录

- note

- 一、SuperCLUE-Agent

- 二、AgentBench

- 三、跨系统benchmark:CRAB

- 四、SWE-bench

一、SuperCLUE-Agent

SuperCLUE-Agent是一个 Agent智能体中文原生任务能力测评基准,评估方面包括:

工具使用能力(调用API、检索API、规划API等)

任务规划能力(任务分解、自我反思、CoT等)

长短记忆能力(少样本示例学习、长程对话、多文档对话)

二、AgentBench

AgentBench 评估维度:

8个任务环境:操作系统(OS)、数据库(DB)、知识图谱(KG)、卡牌对战(DCG)、情景猜谜(LTP)、家居(Alfworld)、网络购物(WebShop)和网页浏览(Mind2Web),

25 个不同的语言模型(包括基于 API 的模型和开源模型):有效性、上下文长度记忆、多轮对话一致性和代码生成执行等全面评估。

三、跨系统benchmark:CRAB

论文题目:CRAB: Cross-environment Agent Benchmark for Multimodal Language Model Agents

论文地址:https://arxiv.org/abs/2407.01511

代码仓库:https://github.com/camel-ai/crab

目前智能体已越来越多地与大型多模态模型 (MLM) 相结合,支持在各种操作系统( 包括网页、桌面电脑和智能手机) 的图形用户界面( GUI) 环境中执行任务。但是目前针对这种智能体性能评估的基准(benchmarks)仍然存在很多局限性,例如构建任务和测试环境的复杂性,评价指标的单一性等。

针对这些问题,本文提出了一个全新的跨环境智能体基准测试框架 CRAB。CRAB 采用了一种基于图的细粒度评估方法,并提供了高效的任务和评估器构建工具。本文的研究团队还基于 CRAB 框架开发了一个跨平台的测试数据集 CRAB Benchmark-v0,其中涵盖了可以在 PC 和智能手机环境中执行的 100 个任务,其中既包含传统的单平台任务,还包含了必须同时操作多个设备才能完成的复杂跨平台任务。

四、SWE-bench

SWE-bench 测试集中的每个示例都是根据 GitHub 上 12 个开源 Python 代码库中一个已解决的 GitHub issue 创建的。每个样本都有一个相关的拉取请求(PR),其中包括解决方案代码和用于验证代码正确性的单元测试。这些单元测试被称为 FAIL_TO_PASS 测试,因为在 PR 中的解决方案代码添加之前它们会失败,添加之后则会通过。每个样本还包括 PASS_TO_PASS 测试,这些测试在 PR 合并前后都会通过,用于检查 PR 是否破坏了代码库中与问题无关的其他功能。

在 SWE-bench 中,AI 智能体会获得来自 GitHub issue 的原始文本,即问题陈述,并可以访问代码库。给定这些信息,智能体必须编辑代码库中的文件以解决问题。

AI 智能体给出的编辑将通过运行 FAIL_TO_PASS 和 PASS_TO_PASS 测试来评估。如果 FAIL_TO_PASS 测试通过,这意味着编辑解决了问题。如果 PASS_TO_PASS 测试通过,则意味着编辑没有破坏代码库中无关的部分。要完全解决原始的 GitHub 问题,两组测试都必须通过。

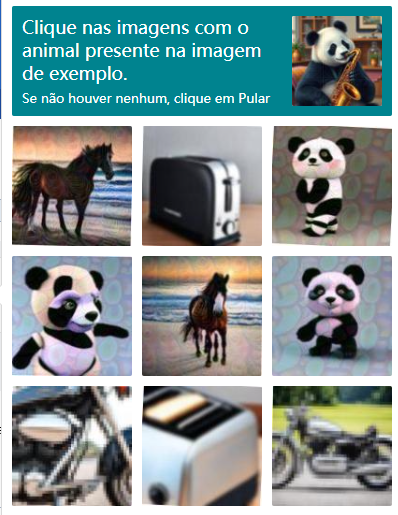

![[笔记]自动化中破解验证码](https://img-blog.csdnimg.cn/img_convert/4f41c1df62dec00b557d065e22bd2f40.png)