📖标题:Adapting While Learning: Grounding LLMs for Scientific Problems with Intelligent Tool Usage Adaptation

🌐来源:arXiv, 2411.00412

🌟摘要

🔸大型语言模型(LLMs)在解决简单的科学问题方面表现出了有前景的能力,但对于复杂的问题往往会产生幻觉。虽然将LLM与工具集成可以提高可靠性,但这种方法通常会导致过度依赖工具,削弱模型通过基本推理解决简单问题的能力。相比之下,人类专家在选择合适的解决方案之前,首先使用领域知识评估问题的复杂性。

🔸受这种人类问题解决过程的启发,我们提出了一种新颖的双组件微调方法。在第一个组件世界知识蒸馏 (WKD) 中,LLM直接从使用工具信息生成的解决方案中学习,以内化领域知识。在第二个组件工具使用适应 (TUA) 中,我们根据模型的直接回答准确性将问题分为简单和困难两类。在保持WKD中简单问题的对齐目标不变的同时,我们训练模型智能地切换到工具使用,以解决更具挑战性的问题。

🔸我们在六个科学基准数据集上验证了我们的方法,涵盖数学、气候科学和流行病学。平均而言,我们的模型在所有数据集中的答案准确性提高了28.18%,工具使用精度提高了13.89%,超过了包括GPT-4o和Claude-3.5在内的最先进的模型。

🛎️文章简介

🔸研究问题:如何使大语言模型(LLM)在解决科学问题时能够自适应地使用工具,以平衡其内在知识和外部工具的使用?

🔸主要贡献:论文提出了一种新颖的两阶段训练范式,使LLM能够自适应地解决不同复杂度的真实世界科学问题。

📝重点思路

🔺相关工作

🔸LLM对齐:旨在使LLM的行为符合人类价值观,使用监督微调 (SFT)和强化学习(RL)等方法。

🔸LLM解决科学问题:先前的工作使用各个科学领域的特定知识,严重依赖于专家注释或从更强大的模型中进行蒸馏。

🔸LLM工具使用:工具有两大类,结果随时间变化如搜索引擎和社交媒体,具有一致结果的工具如编译器和知识库。

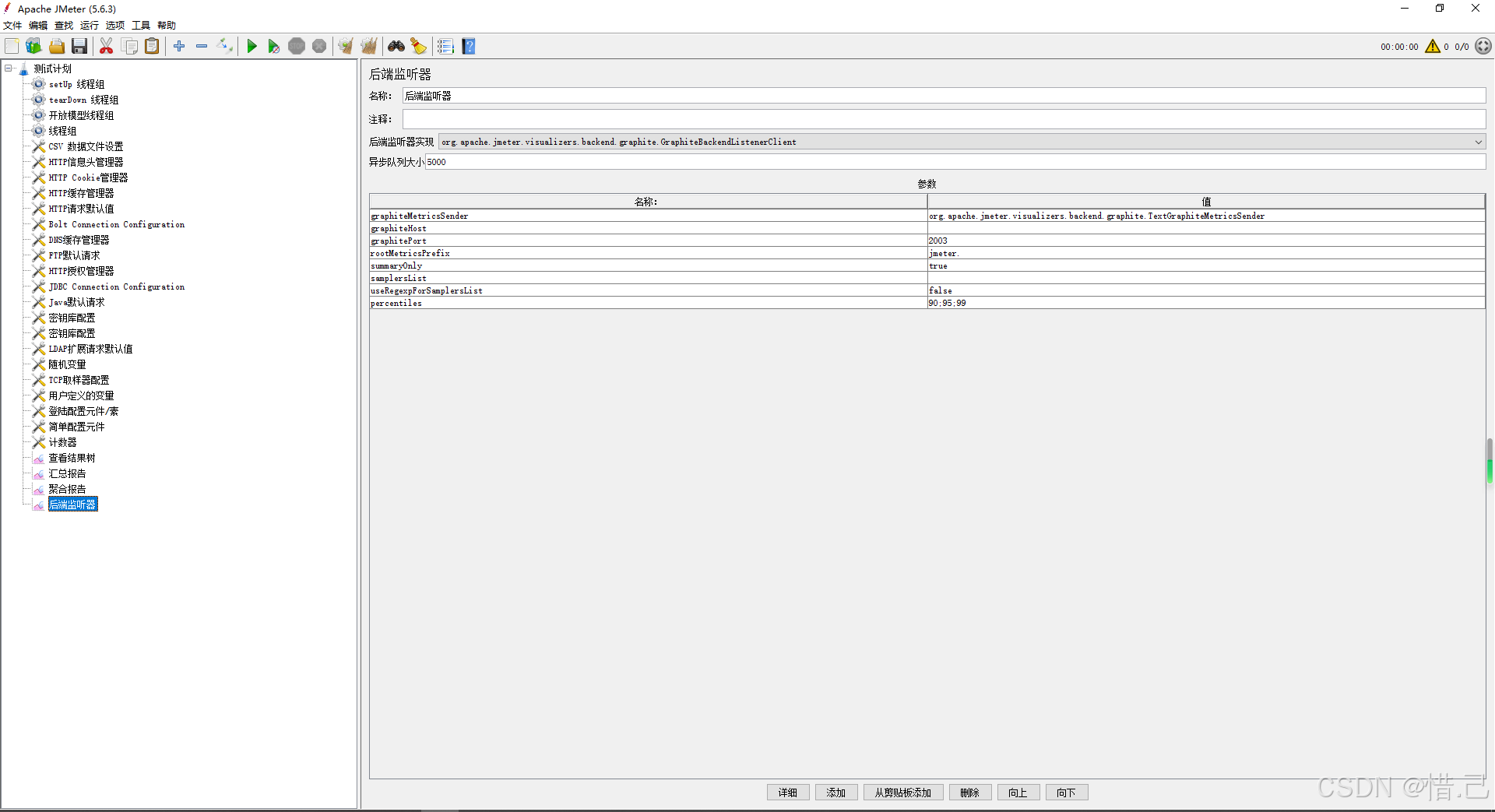

🔺论文方案

🔸主要思想:提出了一种两组件的训练范式,包括世界知识蒸馏(WKD)和工具使用适应(TUA)。

🔸WKD:通过监督微调和偏好优化,使模型内化领域特定的专业知识。

🔸TUA:训练模型根据任务复杂度智能地利用外部工具,结合直接推理和有效工具使用,提高科学问题解决的准确性和可靠性。

🔸工具模板:还设计了问题和相应的工具使用模板,指导LLM在每个步骤中使用特定格式的系统提示来运行模拟器,并结合上下文生成解决方案。

🔎分析总结

🔸在自定义数据集上,论文的方法大幅超越了所有基线模型,特别是在预训练LLM未曾遇到的高难度和专业问题上。

🔸论文的方法在公共数据集上虽然没有超越当前最先进的模型,但显著改善了基础模型未经微调的表现。

🔸实验还展示了模型在不同提示策略下的功能,表明模型能够成功内化从工具中提取的知识,并在更难的问题上智能地切换到工具使用。

💡个人观点

论文的核心是使LLM根据问题复杂度判断是否使用工具,并针对这个问题设计了两阶段训练。

🧩附录