引言:

在这个信息爆炸的时代,我们每天都在被各种商品信息轰炸。你是否曾想过,如何能快速、准确地获取淘宝商品的描述信息?今天,就让我们一起开启一段Java爬虫的奇妙冒险,探索如何通过代码一键“爬”取淘宝商品描述,让你的API接口更加智能和高效。

正文:

第一章:Java爬虫的神秘面纱

在开始我们的冒险之前,让我们先揭开Java爬虫的神秘面纱。Java爬虫,是一种利用Java编程语言编写的网络爬虫程序,它能够自动访问网页,提取网页上的数据,并将其存储起来。想象一下,你只需轻轻一点,就能将淘宝商品的描述信息收入囊中,是不是很酷?

第二章:准备你的“爬虫装备”

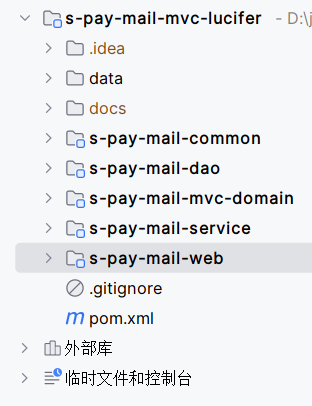

在开始编写代码之前,我们需要准备一些“爬虫装备”。首先,你需要安装Java开发环境(JDK),然后是构建工具Maven,它能帮助我们管理项目依赖。接下来,我们需要一些“武器”:

- Jsoup:一个方便的HTML解析器,让我们能够轻松解析网页。

- HttpClient:用于发送HTTP请求,获取网页内容。

在你的Maven项目的pom.xml文件中添加以下依赖:

<dependencies><dependency><groupId>org.jsoup</groupId><artifactId>jsoup</artifactId><version>1.13.1</version></dependency><dependency><groupId>org.apache.httpcomponents</groupId><artifactId>httpclient</artifactId><version>4.5.13</version></dependency>

</dependencies>第三章:编写你的爬虫代码

现在,让我们开始编写代码。首先,我们需要创建一个TaobaoCrawler类,它将负责发送请求和解析网页。

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;public class TaobaoCrawler {public static void main(String[] args) {try {String url = "https://item.taobao.com/item.htm?id=你的商品ID";CloseableHttpClient httpClient = HttpClients.createDefault();HttpGet request = new HttpGet(url);CloseableHttpResponse response = httpClient.execute(request);String html = EntityUtils.toString(response.getEntity());Document doc = Jsoup.parse(html);Element description = doc.select("div#J_desc").first();System.out.println("商品描述:" + description.text());} catch (Exception e) {e.printStackTrace();}}

}第四章:面对挑战,机智应对

在爬虫的世界里,我们经常会遇到一些挑战,比如反爬虫机制。淘宝作为一个大型电商平台,自然也有自己的防护措施。为了应对这些挑战,我们可能需要设置User-Agent,使用代理,或者添加一些等待时间来模拟正常用户的行为。

第五章:将爬取的数据转化为API接口

现在我们已经能够爬取商品描述了,下一步是将这些数据转化为API接口,让其他开发者也能方便地使用。我们可以使用Spring Boot来快速搭建一个RESTful API服务。

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;@RestController

public class TaobaoController {@GetMapping("/taobao/description")public String getDescription(@RequestParam String itemId) {// 这里调用TaobaoCrawler的逻辑return "商品描述信息";}

}结语:

通过这段Java爬虫的奇妙冒险,我们不仅学会了如何获取淘宝商品描述,还了解了如何将这些数据转化为API接口。现在,你可以将这段代码应用到你的项目中,让你的应用程序更加智能和强大。记住,爬虫虽好,但也要遵守法律法规,尊重网站的robots.txt文件,合理使用爬虫技术。