❤️ 如果你也关注大模型与 AI 的发展现状,且对大模型应用开发非常感兴趣,我会快速跟你分享最新的感兴趣的 AI 应用和热点信息,也会不定期分享自己的想法和开源实例,欢迎关注我哦!

🥦 微信公众号|搜一搜:蚝油菜花 🥦

🚀 快速阅读

- MMBench-Video 是一种用于评估大型视觉语言模型在视频理解能力上的基准测试。

- 该基准测试包含 600 个 YouTube 视频片段,覆盖 16 个类别,每个视频时长从 30 秒到 6 分钟不等。

- MMBench-Video 提供高质量的问答对,用 GPT-4 进行自动化评估,提高准确性。

正文(附运行示例)

MMBench-Video 是什么

MMBench-Video 是浙江大学、上海人工智能实验室、上海交通大学和香港中文大学联合推出的一种长视频多题问答基准测试。它能全面评估大型视觉语言模型(LVLMs)在视频理解方面的能力,用包含丰富视频内容和细粒度能力评估的长视频,弥补现有基准测试在时序理解和复杂任务处理方面的不足。MMBench-Video 包含约 600 个 YouTube 视频片段,覆盖 16 个类别,每个视频时长从 30 秒到 6 分钟不等,配有由志愿者编写的高质量问答对。基准测试用 GPT-4 进行自动化评估,提高准确性,与人类判断保持一致。MMBench-Video 的推出为研究人员提供了强大的工具,评估和改进视频语言模型的能力。

MMBench-Video 的主要功能

- 视频理解评估:MMBench-Video 用于评估大型视觉语言模型(LVLMs)在理解长视频内容方面的能力。

- 多场景覆盖:包含 16 个主要类别的视频内容,涵盖广泛的主题和场景。

- 细粒度能力评估:用 26 个细粒度的能力维度,对模型的视频理解能力进行详尽评估。

- 高质量数据集:视频片段和问答对均由志愿者精心编写和标注,确保数据质量。

- 自动化评估:用 GPT-4 进行自动化的评估,提高评估的效率和准确性。

MMBench-Video 的技术原理

- 长视频内容:MMBench-Video 包含从 YouTube 采集的多个长视频片段,视频片段比传统短视频更能测试模型的时序理解能力。

- 人工标注:问题和答案对均由人类志愿者编写和标注,确保高质量和减少偏差。

- 能力分类体系:构建三层级的视频理解能力分类体系,包括感知和推理两大类,及更细分的 26 个能力维度。

- 时序推理挑战:设计需要时序推理能力的问题,评估模型对视频内容时间维度的理解。

- 自动化评估:语言模型(如 GPT-4)自动化评估模型输出与标准答案之间的语义相似度,评估模型的性能。

- 多模型比较:支持对多个 LVLMs 进行评分和比较,确定在视频理解任务上的优势和不足。

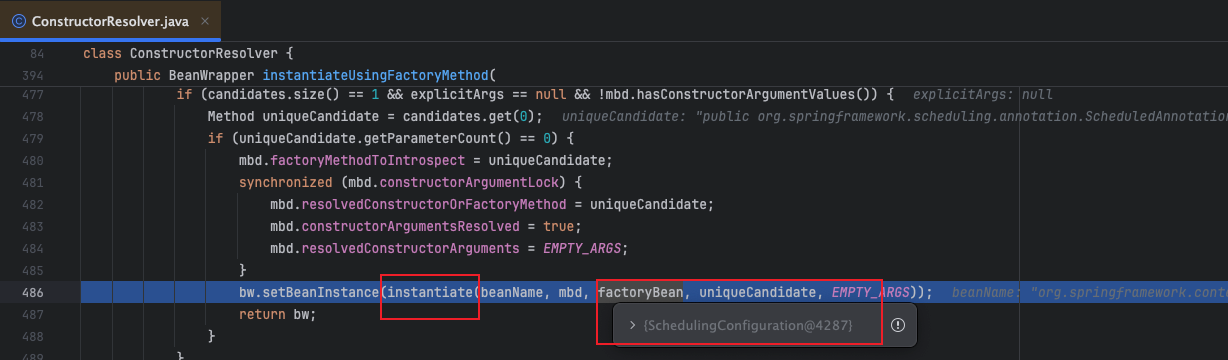

如何运行 MMBench-Video

- 安装依赖:

pip install git+https://github.com/open-compass/VLMEvalKit.git

- 下载数据集:

python -m vlmeval.download --dataset MMBench-Video

- 运行评估:

from vlmeval.config import supported_VLM

from vlmeval.benchmark import run_benchmark# 选择模型

model = supported_VLM['your_model_name']()# 运行基准测试

results = run_benchmark(model, 'MMBench-Video')# 打印结果

print(results)

资源

- 项目官网:https://mmbench-video.github.io/

- GitHub 仓库:https://github.com/open-compass/VLMEvalKit

- HuggingFace 模型库:https://huggingface.co/datasets/opencompass/MMBench-Video

- arXiv 技术论文:https://arxiv.org/pdf/2406.14515

❤️ 如果你也关注大模型与 AI 的发展现状,且对大模型应用开发非常感兴趣,我会快速跟你分享最新的感兴趣的 AI 应用和热点信息,也会不定期分享自己的想法和开源实例,欢迎关注我哦!

🥦 微信公众号|搜一搜:蚝油菜花 🥦

![[MySQL#11] 索引底层(2) | B+树 | 索引的CURD | 全文索引](https://img-blog.csdnimg.cn/img_convert/114c102120ce1cdb8682e0f8a179cd60.png)