第23章 大数据与NoSQL集成

在当今的数字化时代,数据量的爆炸性增长给传统的关系型数据库带来了前所未有的挑战。为了应对这些挑战,NoSQL(Not Only SQL)数据库应运而生,它提供了灵活的数据模型和可扩展的架构来处理大规模数据集。本章将探讨NoSQL数据库的基本概念,以及Oracle如何通过不同的方式与NoSQL数据库集成,以满足现代企业的需求。

1. NoSQL数据库简介

NoSQL数据库是指那些非关系型、分布式、不提供SQL查询语言的数据存储系统。它们通常具有以下特点:

- 非关系型:与传统的关系型数据库不同,NoSQL数据库不需要固定的数据表结构,可以存储半结构化或非结构化的数据。

- 水平扩展:NoSQL数据库设计时考虑了分布式计算环境,能够轻松地通过增加服务器节点实现横向扩展。

- 高可用性和容错性:大多数NoSQL数据库都支持数据复制,确保即使部分节点故障也能保持服务的连续性。

- 灵活的数据模型:NoSQL数据库支持多种数据模型,包括键值对、文档、列族和图形等。

常见的NoSQL数据库类型有:

- 键值存储:如Redis、Riak,适用于缓存和会话管理。

- 文档存储:如MongoDB、CouchDB,适合存储JSON格式的数据。

- 列族存储:如Cassandra、HBase,适合处理大规模数据写入操作。

- 图形数据库:如Neo4j、ArangoDB,用于处理复杂的关系网络。

2. Oracle与NoSQL集成方案

Oracle公司认识到,在处理大量非结构化数据方面,NoSQL数据库有着独特的优势。因此,Oracle提供了多种方式来与NoSQL数据库进行集成,从而构建更加灵活和高效的应用程序。

- Oracle NoSQL Database:这是Oracle自家的NoSQL解决方案,特别适合于需要高性能读写操作的应用场景。Oracle NoSQL Database支持键值对存储,并且具备高可用性、易扩展的特点。

- Oracle Big Data Connectors:这是一套工具集,允许用户从Hadoop生态系统中的各种组件(如Hive、Pig、MapReduce)访问Oracle数据库。此外,它还支持将数据从Oracle数据库导出到NoSQL数据库中。

- Oracle Data Integrator (ODI):作为一款强大的ETL工具,ODI可以用来在Oracle数据库和其他数据源之间移动数据,包括NoSQL数据库。它支持数据转换、清洗等功能,是数据集成的理想选择。

- Oracle GoldenGate:该产品主要用于实时数据复制,可以在异构环境中同步数据,包括从关系型数据库到NoSQL数据库的数据迁移。

案例分析

假设某大型电商平台希望提升其推荐系统的性能。目前,该平台使用Oracle数据库存储用户信息和购买记录,但由于用户数量庞大,查询历史订单和生成个性化推荐的速度较慢。为了解决这一问题,团队决定采用MongoDB作为辅助数据库,专门用于存储用户行为数据,如浏览记录、搜索关键词等。

技术实现步骤:

- 使用Oracle Data Integrator定期从Oracle数据库抽取用户基本信息和购买历史,然后加载到MongoDB中。

- 在网站前端应用中集成MongoDB客户端,当用户访问时,实时收集用户的在线行为并保存至MongoDB。

- 开发基于机器学习的推荐算法,利用MongoDB中的用户行为数据训练模型,生成个性化推荐列表。

- 通过Oracle GoldenGate实现实时数据同步,确保Oracle数据库中的最新交易数据能够迅速反映在MongoDB中,保持数据的一致性。

通过以上步骤,不仅提高了推荐系统的响应速度,同时也减轻了Oracle数据库的负载压力,实现了数据的有效利用和价值最大化。

小结

随着大数据时代的到来,NoSQL数据库因其灵活性和可扩展性成为众多企业的首选。Oracle通过提供多样化的集成工具和服务,帮助企业轻松连接传统关系型数据库与新兴的NoSQL数据库,推动了数据驱动业务的发展。希望本章的内容能帮助读者更好地理解NoSQL数据库及其与Oracle数据库的集成方法。

深入探讨Oracle与NoSQL集成的技术细节

在上一节中,我们简要介绍了Oracle与NoSQL数据库的集成方案,并通过一个电商推荐系统的案例进行了说明。接下来,我们将进一步探讨这些集成方案的具体技术实现细节,包括配置、编程接口和最佳实践。

3. Oracle NoSQL Database 集成技术细节

配置与部署:

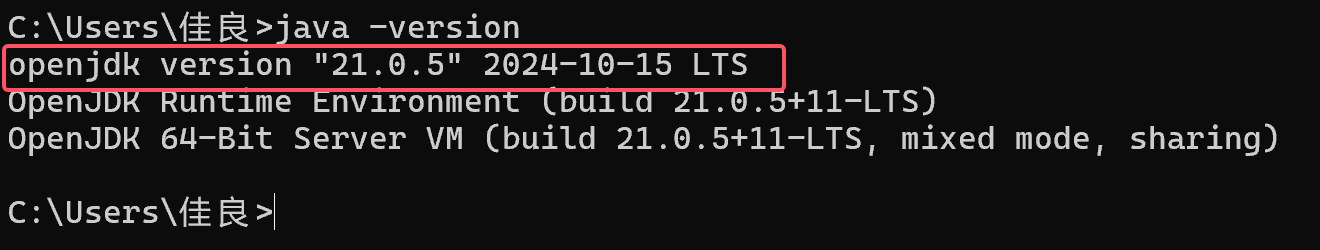

- 安装Oracle NoSQL Database:首先需要下载并安装Oracle NoSQL Database软件。安装过程中,可以选择不同的配置选项来适应特定的应用需求,例如集群规模、存储模式等。

- 创建表格和索引:使用Oracle NoSQL提供的命令行工具或API,定义数据表结构及必要的索引,以便优化查询性能。

- 数据迁移:如果已有数据需要迁移到Oracle NoSQL Database,可以通过批处理脚本或者ETL工具完成。

编程接口:

- Java API:Oracle NoSQL Database提供了一套丰富的Java API,支持基本的CRUD操作以及更复杂的事务处理。

- HTTP REST API:对于非Java应用程序,可以通过HTTP REST API与Oracle NoSQL Database进行交互。

示例代码:

import oracle.kv.*;

import oracle.kv.table.*;public class NoSQLExample {public static void main(String[] args) throws Exception {// 创建连接KVStore store = KVStoreFactory.getStore(new StoreConfig().setSecurity(new SecurityConfig().setCredential("username", "password")),"localhost:5000");// 定义表结构TableDefinition def = new TableDefinitionBuilder().name("users").addPrimaryKeyField("id", FieldType.STRING).addField("name", FieldType.STRING).addField("email", FieldType.STRING).build();// 创建表store.admin().createTable(def);// 插入数据Row row = def.createRow();row.set("id", "1");row.set("name", "John Doe");row.set("email", "john@example.com");store.put(null, row.getKey(), row.getValue());// 查询数据Row result = store.get(null, row.getKey());System.out.println(result.getString("name"));// 关闭连接store.close();}

}

4. Oracle Big Data Connectors 技术细节

配置与部署:

- 安装Big Data Connectors:根据官方文档指导,安装Oracle Big Data Connectors软件包。

- 配置Hadoop集群:确保Hadoop集群已经正确设置,并且与Oracle数据库之间的网络连接畅通无阻。

编程接口:

- Hive Connector:允许Hive查询直接访问Oracle数据库中的数据。

- Pig Connector:使Pig脚本能够读取和写入Oracle数据库。

- MapReduce Connector:支持MapReduce作业处理Oracle数据库中的数据。

示例代码 - Hive Connector:

-- 创建外部表映射到Oracle数据库

CREATE EXTERNAL TABLE users (id INT,name STRING,email STRING

)

STORED BY 'oracle.hadoop.connector.OracleStorageHandler'

TBLPROPERTIES ('oracle.jdbc.url'='jdbc:oracle:thin:@//hostname:port/service_name','oracle.jdbc.driver'='oracle.jdbc.OracleDriver','oracle.jdbc.user'='username','oracle.jdbc.password'='password','oracle.jdbc.query'='SELECT * FROM users'

);

5. Oracle Data Integrator (ODI) 技术细节

配置与部署:

- 安装ODI:按照官方指南安装Oracle Data Integrator。

- 创建项目和模型:在ODI Studio中创建新的项目,并定义源数据模型(如Oracle数据库)和目标数据模型(如MongoDB)。

开发数据映射:

- 设计映射:使用ODI Studio的设计界面,定义源表与目标表之间的字段映射关系。

- 编写KMs:Knowledge Modules (KMs) 是ODI中预定义的代码片段,用于执行特定的任务,如数据加载、转换等。根据需求选择合适的KM。

示例 - 数据加载:

<!-- ODI Knowledge Module for loading data into MongoDB -->

<km><description>Load data from Oracle to MongoDB</description><type>LOAD</type><technology>MongoDB</technology><steps><step><description>Extract data from Oracle</description><code>SELECT * FROM ${SRC_SCHEMA}.${SRC_TABLE}</code></step><step><description>Insert data into MongoDB</description><code>db.${TGT_COLLECTION}.insert(${data})</code></step></steps>

</km>

6. Oracle GoldenGate 技术细节

配置与部署:

- 安装GoldenGate:根据官方文档安装Oracle GoldenGate软件。

- 配置复制过程:定义源端(Oracle数据库)和目标端(NoSQL数据库)的复制参数,包括表映射、过滤条件等。

监控与维护:

- 监控复制状态:使用GoldenGate提供的工具检查复制任务的状态,确保数据同步的准确性和及时性。

- 故障排除:遇到问题时,查看GoldenGate的日志文件,定位并解决问题。

结论

通过上述技术细节的介绍,我们可以看到Oracle与NoSQL数据库的集成不仅限于简单的数据迁移,而是涉及到数据建模、编程接口、性能调优等多个方面。每种集成方案都有其适用场景和技术优势,企业在实际应用时应根据自身需求选择最合适的方案。希望这些信息能够帮助读者更深入地理解和应用Oracle与NoSQL数据库的集成技术。

高级应用场景与最佳实践

在前几节中,我们已经介绍了Oracle与NoSQL数据库集成的基础知识和技术细节。现在,我们将进一步探讨一些高级应用场景,并分享一些最佳实践,帮助读者在实际项目中更好地利用这些技术。

7. 高级应用场景

7.1 实时数据分析与处理

场景描述:

在金融、电信等行业中,实时数据分析对于决策支持至关重要。例如,银行需要实时监控交易活动以检测潜在的欺诈行为;电信运营商需要实时分析网络流量以优化服务质量。

技术实现:

- 流处理框架:使用Apache Kafka、Apache Flink等流处理框架捕获实时数据流。

- 数据集成:通过Oracle GoldenGate将Oracle数据库中的实时交易数据传输到Kafka。

- 数据处理:利用Flink或其他流处理引擎对Kafka中的数据进行实时处理和分析。

- NoSQL存储:将处理后的数据存储到NoSQL数据库中,如Cassandra或MongoDB,以便快速查询和展示。

示例代码 - Flink处理Kafka数据:

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;import java.util.Properties;public class RealTimeAnalysis {public static void main(String[] args) throws Exception {// 设置Flink环境final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();// 配置Kafka消费者Properties properties = new Properties();properties.setProperty("bootstrap.servers", "localhost:9092");properties.setProperty("group.id", "test");FlinkKafkaConsumer<String> kafkaConsumer = new FlinkKafkaConsumer<>("transactions",new SimpleStringSchema(),properties);// 添加数据源DataStream<String> stream = env.addSource(kafkaConsumer);// 处理数据DataStream<String> processedStream = stream.map(new MapFunction<String, String>() {@Overridepublic String map(String value) throws Exception {// 处理逻辑return value;}});// 输出结果processedStream.print();// 执行Flink作业env.execute("Real-time Transaction Analysis");}

}

7.2 跨数据中心数据同步

场景描述:

大型企业往往在全球范围内拥有多个数据中心,需要在这些数据中心之间同步数据,以确保数据的一致性和高可用性。

技术实现:

- 多主复制:使用Oracle GoldenGate配置多主复制,实现在多个数据中心之间的双向数据同步。

- 数据分片:根据业务需求将数据分片存储在不同的NoSQL数据库中,提高数据访问性能。

- 故障转移:设置自动故障转移机制,确保在一个数据中心发生故障时,其他数据中心能够无缝接管服务。

示例配置 - Oracle GoldenGate多主复制:

-- 配置源端

GGSCI> ADD EXTRACT ext1, EXTTRAIL /u01/app/oracle/ggs/dirdat/et

GGSCI> ADD EXTTRAIL /u01/app/oracle/ggs/dirdat/et, EXTRACT ext1

GGSCI> EDIT PARAMS ext1-- 配置目标端

GGSCI> ADD REPLICAT rep1, EXTTRAIL /u01/app/oracle/ggs/dirdat/et

GGSCI> EDIT PARAMS rep1-- 参数文件示例

EXTRACT ext1

USERID ggate, PASSWORD ggate

RMTHOST target_host, MGRPORT 7839

RMTTRAIL /u01/app/oracle/ggs/dirdat/rt

TABLE schema1.*;REPLICAT rep1

USERID ggate, PASSWORD ggate

ASSUMETARGETDEFS

MAP schema1.*, TARGET schema1.*;

8. 最佳实践

8.1 性能优化

- 索引优化:合理设计NoSQL数据库中的索引,减少查询时间。

- 分区策略:根据数据访问模式选择合适的分区策略,避免热点问题。

- 缓存机制:使用缓存技术(如Redis)加速频繁访问的数据。

8.2 安全性

- 数据加密:对敏感数据进行加密存储,确保数据安全。

- 访问控制:实施严格的访问控制策略,限制对数据的访问权限。

- 审计日志:启用审计日志功能,记录所有数据访问和修改操作,便于追踪和审计。

8.3 可维护性

- 自动化运维:使用自动化工具(如Ansible、Terraform)管理数据库的部署和配置。

- 监控与报警:设置监控系统(如Prometheus、Grafana)实时监控数据库性能,配置报警机制及时发现和解决问题。

- 备份与恢复:定期备份数据,并测试恢复流程,确保在灾难情况下能够快速恢复业务。

总结

通过本章的学习,读者不仅掌握了Oracle与NoSQL数据库集成的基本概念和技术细节,还了解了一些高级应用场景和最佳实践。这些知识和技巧将有助于读者在实际项目中更好地利用Oracle和NoSQL数据库,构建高效、可靠的数据处理系统。希望本章的内容能够为读者提供有价值的参考和指导。

![[ComfyUI]FaceAging:太好玩啦!FaceAging终于装好了!负50到正100岁随心调整!超强又难装的节点安装教程来了! Comfyui教程](https://img-blog.csdnimg.cn/direct/4ef6c3c84f424b47afa657004903bf17.png)