Selenium 是一个广泛使用的自动化工具,最初设计用于测试 Web 应用程序的功能,但它也被广泛用于爬虫开发,尤其是处理动态网页和需要 JavaScript 渲染的页面。它支持多种浏览器(如 Chrome、Firefox、Edge、Safari 等)并且可以模拟用户在浏览器中的一系列操作,如点击、滚动、输入等。

1.1 Selenium基本操作

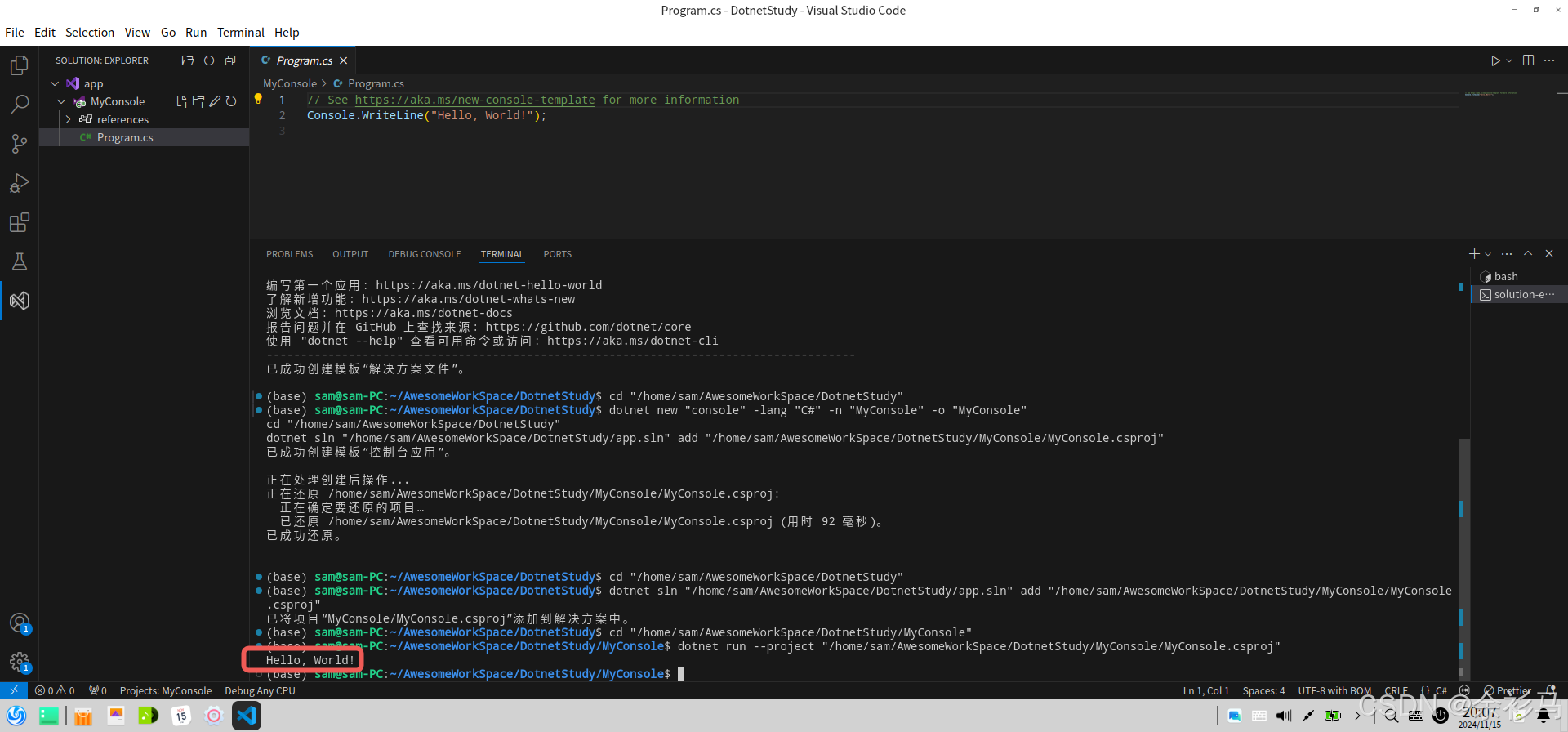

1.1.1 浏览器启动

Selenium 能够通过 WebDriver 启动指定的浏览器实例,并进行自动化操作。WebDriver 是 Selenium 的核心组件之一,它提供了与浏览器交互的接口。在 Python 中,通常使用 selenium.webdriver 来启动浏览器。

from selenium import webdriver# 启动 Chrome 浏览器

driver = webdriver.Chrome(executable_path='/path/to/chromedriver')# 启动 Firefox 浏览器

# driver = webdriver.Firefox(executable_path='/path/to/geckodriver')# 访问网页

driver.get('https://example.com')# 获取页面标题

print(driver.title)# 关闭浏览器

driver.quit()解析:

webdriver.Chrome()启动 Chrome 浏览器,参数executable_path用于指定 ChromeDriver 可执行文件的路径。不同浏览器需要不同的驱动(如geckodriver用于 Firefox)。driver.get(url)用于访问指定的网页 URL。driver.quit()用于关闭浏览器,结束 Selenium 会话。

1.1.2 元素定位

元素定位是与 Selenium 交互的关键。在爬虫中,我们需要准确找到网页中的元素,以便提取内容、点击链接或填写表单等。Selenium 提供了多种方式来定位网页元素。

常用的元素定位方法包括:

- By.ID:通过元素的 ID 属性定位。

- By.NAME:通过元素的 name 属性定位。

- By.CLASS_NAME:通过元素的 class 属性定位。

- By.TAG_NAME:通过元素的标签名定位。

- By.CSS_SELECTOR:通过 CSS 选择器定位元素。

- By.XPATH:通过 XPath 定位元素(非常强大,支持更复杂的选择)。

from selenium.webdriver.common.by import By# 使用 ID 定位

element = driver.find_element(By.ID, 'loginButton')# 使用 CLASS_NAME 定位

element = driver.find_element(By.CLASS_NAME, 'btn-primary')# 使用 CSS_SELECTOR 定位

element = driver.find_element(By.CSS_SELECTOR, '.content > p')# 使用 XPATH 定位

element = driver.find_element(By.XPATH, '//div[@class="content"]/p')解析:

find_element()方法用于定位单个元素。如果定位的元素不存在,Selenium 会抛出NoSuchElementException异常。find_elements()用于查找多个符合条件的元素,返回的是一个列表。

1.1.3 动作模拟

Selenium 允许我们模拟一系列用户操作,如点击、输入文本、鼠标悬停、键盘按键等。这些动作在爬取动态网页时尤其重要,因为很多网页的交互和数据加载依赖于用户操作。

- 点击操作:

button = driver.find_element(By.ID, 'submitButton')

button.click()- 输入文本:

input_box = driver.find_element(By.NAME, 'username')

input_box.send_keys('myUsername')# 清空输入框

input_box.clear()# 输入密码

password_box = driver.find_element(By.NAME, 'password')

password_box.send_keys('myPassword')- 鼠标悬停(使用 ActionChains):

from selenium.webdriver.common.action_chains import ActionChains# 鼠标悬停到某个元素上

element = driver.find_element(By.ID, 'hoverElement')

actions = ActionChains(driver)

actions.move_to_element(element).perform()- 滚动页面:

driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")1.1.4 隐式和显式等待

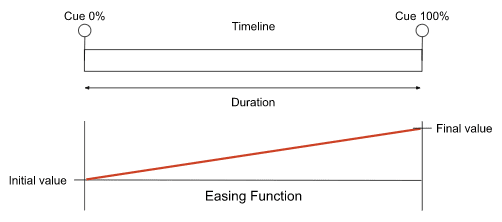

在动态网页中,页面内容通常是异步加载的,直接操作可能会导致元素尚未加载完成而抛出异常。为了解决这个问题,Selenium 提供了等待机制。

- 隐式等待:每次查找元素时都会等待指定的时间(如果元素在指定时间内出现,则继续执行,否则抛出异常)。

# 设置隐式等待,单位为秒

driver.implicitly_wait(10)- 显式等待:显式等待是在特定条件下等待某个元素出现或变为可操作状态。

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC# 显式等待元素加载,最多等待 10 秒

element = WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'dynamicElement'))

)解析:

implicitly_wait()设置了全局的隐式等待时间,Selenium 会在每次寻找元素时等待该时间。WebDriverWait和expected_conditions用于显式等待。presence_of_element_located用于等待元素加载,visibility_of_element_located用于等待元素可见。

1.2 处理动态加载的页面内容

动态加载的页面通常通过 JavaScript、AJAX 或 WebSocket 等技术实现内容的异步加载。在这种情况下,页面初始加载时并不会包含所有数据,数据通常是在用户操作后或页面滚动时通过异步请求加载。要抓取动态加载的内容,需要特定的技巧。

1.2.1 等待页面加载完成

在处理动态加载的网页时,首先需要等待页面或某些元素完全加载。可以使用 Selenium 的显式等待,确保在执行数据提取操作之前,目标内容已经被加载。

# 等待页面上的某个特定元素加载完成

element = WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'targetElement'))

)1.2.2 模拟滚动加载内容

一些动态网页内容是在用户滚动页面时通过 JavaScript 动态加载的。这种情况下,我们可以模拟滚动操作,迫使浏览器加载更多数据。

# 模拟页面向下滚动

driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")# 等待加载完成后再执行下一步操作

WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'nextPageElement'))

)1.2.3 获取 Ajax 请求的数据

许多动态页面通过 Ajax 请求从服务器获取数据。爬虫可以直接监听这些 Ajax 请求,并通过捕获请求的响应数据来提取内容,而不必等到页面完全渲染后再进行提取。

-

通过浏览器开发者工具获取 Ajax 请求 打开浏览器开发者工具的 "Network" 面板,刷新页面后,可以看到所有网络请求。找到与数据相关的 Ajax 请求,并记录该请求的 URL 和参数。

-

使用 Selenium 获取 Ajax 请求的数据 Selenium 允许通过 JavaScript 访问浏览器的开发者工具 API,从而获取 Ajax 请求的响应。

# 获取页面的所有网络请求

requests = driver.execute_script("return window.performance.getEntriesByType('resource');")

for request in requests:if "api" in request['name']:print(request['name'])1.2.4 处理 JavaScript 渲染的内容

一些动态页面依赖于 JavaScript 渲染内容。如果内容通过 JavaScript 生成并插入到 DOM 中,Selenium 可以模拟浏览器执行 JavaScript 脚本并返回渲染后的页面。

# 获取渲染后的页面内容

html_content = driver.page_source此时,driver.page_source 返回的是执行 JavaScript 后的页面 HTML,包含了所有动态加载的内容。

1.2.5 处理验证码与反爬虫机制

有时,网站会通过验证码或反爬虫机制(如IP封锁、请求头检查等)来防止爬虫抓取数据。在这种情况下,可以使用一些技巧绕过反爬虫机制。

- 使用代理:通过代理池来绕过IP封锁。

- 模拟真实浏览器:通过更改请求头,模拟真实浏览器的访问行为。

- OCR识别验证码:使用 OCR(如 Tesseract)识别验证码并提交。

总结

Selenium 是一个非常强大的工具,适用于处理动态网页的爬取。它能够模拟用户的浏览器操作,包括点击、输入、滚动等操作,从而触发数据的加载。在处理动态加载的网页时,Selenium 的显式等待、滚动操作和 JavaScript 执行都能够帮助开发者提取渲染后的数据。

随着动态网页的逐渐增多,爬虫开发者越来越依赖 Selenium 来抓取复杂的网页。