简介:个人学习分享,如有错误,欢迎批评指正。

RAG(Retrieval-Augmented Generation)是一种结合信息检索与生成式模型的混合架构,旨在提升自然语言生成任务的准确性、丰富性和知识覆盖范围。它通过在生成过程中动态检索外部知识库中的相关信息,以弥补生成模型在知识更新和细节准确性上的不足。

一. 核心理念

RAG的核心理念是将传统的生成式模型(如GPT、BERT等)与信息检索(IR)系统相结合,使得生成模型能够在生成文本时访问和利用外部知识库中的最新和相关信息。这种方法不仅提升了生成内容的准确性和一致性,还扩大了模型的知识范围,尤其在处理开放域问答、复杂对话等任务时表现出色。

RAG的架构主要由两个核心组件组成:

- 检索器(Retriever):

负责从大型知识库中检索与输入查询最相关的文档或片段。 - 生成器(Generator):

基于检索到的文档和原始输入生成最终的文本输出。

此外,RAG还涉及知识库的构建与管理、索引与检索技术、以及检索与生成之间的集成机制。

二. 检索器 (Retriever)

1 检索器的类型

RAG中常用的检索器分为两大类:

1.1 稀疏检索器 (Sparse Retriever)

- 原理:

基于关键词匹配,通过统计方法衡量文档与查询的相关性。 - 常用算法:

- TF-IDF (Term Frequency-Inverse Document Frequency)

- BM25 (Best Matching 25)

- 优点:计算效率高,易于实现,适用于基于关键词的精确匹配。

- 缺点:难以捕捉语义相似性,对同义词和多义词处理不足。

1.2 密集检索器 (Dense Retriever)

- 原理:

基于语义表示,通过将查询和文档编码为高维向量,并计算向量之间的相似度。 - 常用模型:

- Dense Passage Retrieval (DPR)

- ColBERT

- 优点:能够捕捉深层次的语义相似性,处理同义词和上下文相关的语义效果更好。

- 缺点:需要大量计算资源,向量索引和存储成本较高。

2 检索器的实现细节

2.1 稀疏检索器实现

- 使用库:Elasticsearch、Lucene等支持TF-IDF和BM25的搜索引擎。

- 步骤:

- 索引构建:

将知识库中的文档进行分词和词频统计,构建倒排索引。 - 查询处理:将用户输入的查询分词,计算每个词的TF-IDF或BM25分数。

- 相关文档检索:基于分数排名,返回Top-K相关文档。

- 索引构建:

2.2 密集检索器实现

-

使用库:FAISS (Facebook AI Similarity Search)、Annoy (Approximate Nearest Neighbors Oh Yeah)、HNSW (Hierarchical Navigable Small World) 等。

-

步骤:

-

向量编码:

- 使用双塔模型分别

编码查询和文档。例如,DPR使用两个BERT模型,一个用于查询,一个用于文档。 - 将查询和文档转化为固定长度的高维向量。

- 使用双塔模型分别

-

向量索引:

- 将所有文档向量

存储在向量数据库中,如FAISS。 - 根据应用需求选择适当的索引结构(如IVF、HNSW)以平衡检索速度和准确性。

- 将所有文档向量

-

向量检索:

- 将查询向量输入向量数据库,

计算与所有文档向量的相似度(通常使用余弦相似度或内积)。 - 返回Top-K相似度最高的文档。

- 将查询向量输入向量数据库,

-

3 检索器的优化

- 向量压缩:使用量化技术(如PQ,Product Quantization)减少向量存储空间,提升检索速度。

- 并行检索:在分布式系统中并行执行检索任务,提升大规模知识库的检索效率。

- 动态更新:设计支持增量更新的索引结构,以便实时添加或删除文档。

三. 生成器 (Generator)

1 生成器的选择

RAG中的生成器通常选用预训练的生成式语言模型,常见的包括:

- BART (Bidirectional and Auto-Regressive Transformers)

- GPT-3/4 (Generative Pre-trained Transformer)

- T5 (Text-to-Text Transfer Transformer)

2 生成器的实现细节

2.1 输入格式

-

输入组成:

- 用户输入:原始查询或上下文。

- 检索文档:从检索器获取的Top-K相关文档片段。

-

拼接方式:

- 简单拼接:将用户输入与所有有检索文档依次拼接,例如:

用户输入: "2024年诺贝尔奖的获奖者有哪些?"

文档1: "..."

文档2: "..."

文档3: "..."

生成器输入: "2024年诺贝尔奖的获奖者有哪些? [SEP] 文档1 [SEP] 文档2 [SEP] 文档3"- 特殊标记:使用特殊的

分隔符或标签来区分不同的文档片段。

2.2 生成过程

- 条件生成:生成器基于拼接后的输入,使用自

回归或非自回归生成策略生成文本。 - 注意力机制:生成器通过头关注力机制,动态关注输入中的不同部分,确保生成内容的相关性和连贯性。

- 解码策略:

- 贪婪搜索 (Greedy Search):每步选择

概率最高的词,计算速度快,但可能缺乏多样性。 - 束搜索 (Beam Search):

保留多个候选序列,平衡生成质量和多样性。 - 核采样 (Top-p Sampling):从累积

概率超过p的词汇中随机采样,增加生成多样性。 - 温度调节:通过调整采样温度,控制生成内容的

随机性和确定性。

- 贪婪搜索 (Greedy Search):每步选择

3 生成器的优化

- 微调:在

特定领域或任务的数据集上对生成器进行微调,增强生成质量和相关性。 - 多文档融合:设计更复杂的

融合机制,将多个文档的信息有效整合,以提升生成内容的丰富性和准确性。 - 控制机制:

指令引入控制信号或条件,指导生成器生成符合特定要求的内容。

四. 检索与生成的集成机制

1 RAG-Sequence vs. RAG-Token

RAG有两种主要的实现方式:RAG-Sequence和RAG-Token。这两种方式在检索与生成的集成细节上有所不同。

1.1 RAG-Sequence

-

工作原理:在生成每个token时,生成器可以

访问和利用所有检索到的文档。 -

实现细节:

- 循环访问:

每生成一个token,生成器都会重新计算注意力分布,考虑检索文档的所有信息。 - 上下文更新:生成过程中,生成器的上下文不断更新,以包含最新生成的token和检索文档的信息。

- 循环访问:

-

优点:生成过程更加灵活,能够动态地利用不同阶段的检索信息。

-

缺点:计算开销大,尤其在检索文档较多时。

1.2 RAG-Token

-

工作原理:

在生成整个文本之前,检索一次相关文档,所有生成的token共享同一组检索结果。 -

实现细节:

- 单次检索:在生成开始前,检索器一次性检索出Top-K相关文档。

- 固定上下文:所有生成的token基于相同的检索文档,

不进行动态更新。

-

优点:计算效率高,适用于对实时性要求较高的场景。

-

缺点:生成过程缺乏动态调整能力,可能在长文本生成中出现信息不足或不一致。

2 RAG的具体实现步骤

以下以RAG-Token为例,详细描述其实现步骤:

-

用户输入:

- 接收用户的查询或上下文,例如:“2024年诺贝尔奖的获奖者有哪些?”

-

查询编码:

- 使用密集检索器将查询编码为向量表示。例如,使用DPR中的查询编码器将查询转化为高维向量。

-

文档检索:

- 使用向量检索器(如FAISS)在知识库中查找与查询向量相似的Top-K文档。

-

文档编码:

- 使用文档编码器将检索到的Top-K文档转化为向量表示,或直接将原始文本文档传递给生成器。

-

文档整合:

- 将Top-K文档片段与用户输入拼接,形成生成器的输入。例如:

"2024年诺贝尔奖的获奖者有哪些? [SEP] 文档1 [SEP] 文档2 [SEP] 文档3"-

文本生成:

- 使用预训练的生成模型(如BART)基于拼接后的输入生成回答。

-

输出后处理:

- 对生成的文本进行必要的格式化、去重、校正等处理,通过自动化评估(如BLEU、ROUGE)或人工评审评估生成内容的质量。

-

返回结果:

- 将最终生成的回答返回给用户。

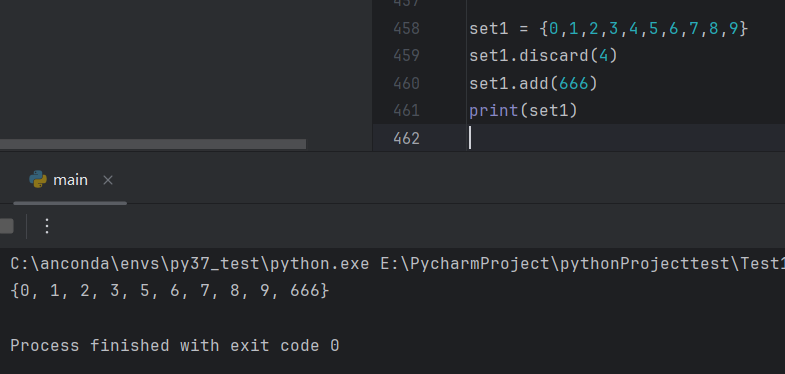

3 代码示例

以下是一个基于Hugging Face Transformers库的RAG-Token实现示例:

from transformers import RagTokenizer, RagRetriever, RagSequenceForGeneration# 初始化tokenizer、retriever和模型

tokenizer = RagTokenizer.from_pretrained("facebook/rag-token-nq")

retriever = RagRetriever.from_pretrained("facebook/rag-token-nq", index_name="exact", use_dummy_dataset=True)

model = RagSequenceForGeneration.from_pretrained("facebook/rag-token-nq")# 用户输入

query = "2024年诺贝尔奖的获奖者有哪些?"# 编码输入

input_ids = tokenizer(query, return_tensors="pt").input_ids# 生成回答

outputs = model.generate(input_ids=input_ids, num_return_sequences=1, num_beams=2)# 解码输出

answer = tokenizer.batch_decode(outputs, skip_special_tokens=True)[0]

print("回答:", answer)4 高级实现细节

4.1 多文档融合策略

- 拼接长度限制:生成器模型通常有输入长度限制,需要设计有效的拼接策略,选择最相关的文档片段。

- 动态权重分配:在生成过程中,根据上下文动态调整各文档片段的权重,提升生成内容的相关性。

- 层级注意力机制:通过层级注意力机制,在不同的生成层次上关注不同的文档片段,增强生成内容的深度和广度。

4.2 生成器与检索器的协同优化

- 联合训练:通过联合训练检索器和生成器,使得检索器能够检索到有助于生成高质量回答的文档。

- 损失函数设计:

- 生成损失:通常使用

交叉熵损失,衡量生成文本与真实答案的差异。 - 检索损失:采用

对比损失(contrastive loss),使得相关文档的向量与查询向量更接近,不相关的则更远。

- 生成损失:通常使用

- 梯度反传:通过端到端的训练,使得检索器和生成器共同优化,提升整体性能。

五. 知识库的构建与管理

1 知识库的数据来源

- 开放数据源:如维基百科、开放文档集合、公共数据库等。

- 专有数据源:公司内部文档、科研论文、技术报告等。

- 动态数据源:新闻网站、社交媒体、实时数据流等。

2 文档预处理

- 分段:将长文档拆分为较小的段落或句子,以提高检索精度和效率。

- 清洗:去除噪声、特殊字符、HTML标签等,保证文档质量。

- 标准化:统一文本格式、编码方式,确保一致性。

3 索引构建

3.1 稀疏索引

- 工具:Elasticsearch、Lucene等。

- 步骤:

- 分词:将文档分词,提取关键词。

- 索引创建:构建倒排索引,记录每个关键词对应的文档列表及其频率。

- 优化:应用

停用词过滤、词干提取、同义词扩展等技术,提升检索效果。

3.2 密集索引

- 工具:FAISS、Annoy、HNSW等。

- 步骤:

- 向量编码:使用文档编码器将所有文档转化为向量表示。

- 向量存储:将向量存储在向量数据库中,构建高效的索引结构(如IVF、HNSW)。

- 索引优化:应用

向量压缩、分片等技术,提升存储效率和检索速度。

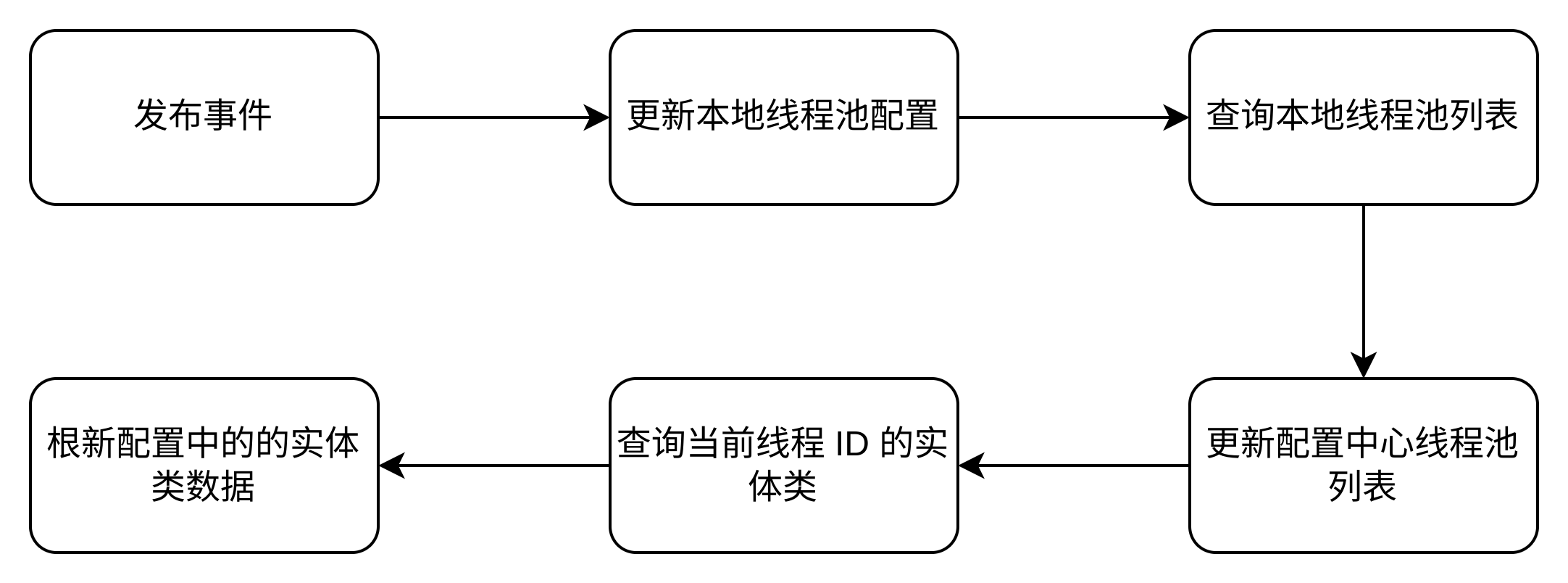

4 知识库的更新机制

- 定期更新:设定定期的数据抓取和

索引更新计划,确保知识库内容的时效性。 - 实时更新:通过流处理和增量更新技术,实时

添加或删除文档,保持知识库的最新状态。 - 版本控制:

记录知识库的更新历史,支持知识库版本管理,确保数据的一致性和可追溯性。

六. 向量数据库与索引技术

1 向量数据库的选择

-

FAISS (Facebook AI Similarity Search):

- 特点:高效的

向量相似性搜索库,支持多种索引结构。 - 适用场景:大规模向量检索、高性能需求。

- 特点:高效的

-

Annoy (Approximate Nearest Neighbors Oh Yeah):

- 特点:基于

树结构的近似最近邻搜索库,适合内存中操作。 - 适用场景:需要快速构建和查询的小型中等规模数据库。

- 特点:基于

-

HNSW (Hierarchical Navigable Small World):

- 特点:基于

图结构的高效近邻搜索算法,支持高精度查询。 - 适用场景:高维度、大规模数据集的高效检索。

- 特点:基于

2 向量索引的构建与优化

-

索引类型:

- Flat Index:逐一比较所有向量,适用于

小规模数据集。 - IVF (Inverted File Index):将向量划分为多个簇,

先检索簇再检索簇内向量,提升大规模检索效率。 - HNSW Index:构建

多层图结构,快速导航到近似最近邻。

- Flat Index:逐一比较所有向量,适用于

-

参数调优:

- 簇数选择 (IVF):根据数据规模和维度选择合适的簇数,平衡检索速度和准确性。

- 探测范围:控制检索时探索的簇或节点数量,调整速度与准确性。

- 硬件加速:利用GPU加速FAISS中的向量检索,提升大规模数据集的检索效率。

3 向量压缩与加速

-

量化技术:

- Product Quantization (PQ):将向量分割为

子向量,分别进行量化,减少存储空间。 - Scalar Quantization:对每个向量维度进行独立量化。

- Product Quantization (PQ):将向量分割为

-

聚类与分片:

- 聚类:将 向量分组 ,减少搜索空间。

- 分片:将大规模索引分割为多个小索引,支持并行检索。

-

近似搜索:采用近似

最近邻搜索算法(如LSH,Locality-Sensitive Hashing),在保证检索速度的同时,尽量保持高检索准确性。

七. 生成器与检索器的联合训练

1 联合训练的必要性

联合训练检索器和生成器可以使两者更好地协同工作,提升整体性能。通过联合训练,检索器能够学会检索对生成有帮助的文档,生成器能够更好地利用检索到的文档生成高质量的输出。

2 联合训练的方法

2.1 端到端训练 (End-to-End Training)

-

流程:

- 输入:用户查询。

- 检索:检索器根据查询检索相关文档。

- 生成:生成器基于检索到的文档生成回答。

- 损失计算:计算生成内容与真实回答的损失。

- 反向传播:将损失反向传播至生成器和检索器,更新两者的参数。

-

优点:

检索器和生成器可以同时优化,提升整体效果。 -

缺点:训练过程复杂,计算资源消耗高。

2.2 分阶段训练 (Stage-wise Training)

-

流程:

- 预训练检索器:首先

独立训练检索器,使其能够有效检索相关文档。 - 预训练生成器:

独立训练生成器,使其能够基于检索到的文档生成高质量文本。 - 联合微调:在预训练的基础上,进行

联合微调,进一步优化两者的协同效果。

- 预训练检索器:首先

-

优点:简化训练过程,降低计算复杂度。

-

缺点:联合优化的效果可能不如端到端训练。

3 损失函数设计

-

生成损失 (Generation Loss):

- 类型:交叉熵损失 (Cross-Entropy Loss)

- 作用:衡量生成的文本与真实文本之间的差异。

-

检索损失 (Retrieval Loss):

- 类型:对比损失 (Contrastive Loss) 或交叉熵损失

- 作用:使相关文档的向量与查询向量更接近,不相关文档更远。

-

联合损失:生成损失和检索损失的加权和,用于同时优化检索器和生成器。

4 训练技巧与优化

- 梯度累积:在内存有限的情况下,使用梯度累积来模拟更大的批量训练。

- 学习率调度:采用学习率衰减策略,稳定训练过程。

- 混合精度训练:使用半精度浮点数(FP16)加速训练过程,减少显存占用。

- 正则化:应用Dropout、权重衰减等正则化方法,防止过拟合。

八. 实际实现示例

1 Facebook AI Research的RAG模型

Facebook AI Research (FAIR) 提出的RAG模型是RAG框架的经典实现,结合了DPR作为检索器和BART作为生成器。

1.1 模型组件

- 检索器:Dense Passage Retrieval (DPR)

- 查询编码器:BERT基础模型

- 文档编码器:独立的BERT模型

- 生成器:BART-large

- 训练方式:端到端联合训练

1.2 实现步骤

-

初始化:

- 加载预训练的DPR查询编码器和文档编码器。

- 加载预训练的BART生成器。

-

向量索引构建:

- 使用DPR文档编码器对知识库中的所有文档进行编码。

- 将编码后的向量存储在FAISS索引中。

-

查询编码与检索:

- 将用户查询通过DPR查询编码器转化为向量。

- 使用FAISS检索Top-K相似文档。

-

生成输入准备:

- 将Top-K文档与用户查询拼接,作为BART的输入。

-

生成回答:

- 使用BART生成自然语言回答。

-

训练:

- 通过联合训练优化DPR和BART,使得检索器能够检索到更有助于生成高质量回答的文档。

2 Hugging Face的RAG实现

Hugging Face提供了RAG模型的开源实现,支持多种检索器和生成器的组合,方便开发者进行定制和应用。

2.1 模型组件

- 检索器:内置支持DPR和其他密集检索器

- 生成器:支持BART、T5等生成模型

- 工具:集成了RagTokenizer、RagRetriever、RagSequenceForGeneration等

2.2 实现步骤

- 安装必要的库:

pip install transformers faiss-cpu- 初始化模型:

from transformers import RagTokenizer, RagRetriever, RagSequenceForGenerationtokenizer = RagTokenizer.from_pretrained("facebook/rag-token-nq")

retriever = RagRetriever.from_pretrained("facebook/rag-token-nq", index_name="exact", use_dummy_dataset=True)

model = RagSequenceForGeneration.from_pretrained("facebook/rag-token-nq")- 编码查询并检索文档:

query = "2024年诺贝尔奖的获奖者有哪些?"

input_ids = tokenizer(query, return_tensors="pt").input_ids- 生成回答:

outputs = model.generate(input_ids=input_ids, num_return_sequences=1, num_beams=2)

answer = tokenizer.batch_decode(outputs, skip_special_tokens=True)[0]

print("回答:", answer)- 自定义知识库:

- 构建自定义知识库,编码文档向量,构建FAISS索引。

- 修改RagRetriever的初始化参数,指向自定义索引。

2.3 自定义知识库示例

from transformers import RagTokenizer, RagRetriever, RagSequenceForGeneration

import faiss

import torch# 初始化tokenizer和retriever

tokenizer = RagTokenizer.from_pretrained("facebook/rag-token-nq")

retriever = RagRetriever.from_pretrained("facebook/rag-token-nq", index_name="custom", passages_path="path/to/custom_passages", index_path="path/to/custom_faiss.index")# 初始化模型

model = RagSequenceForGeneration.from_pretrained("facebook/rag-token-nq", retriever=retriever)# 用户查询

query = "2024年诺贝尔奖的获奖者有哪些?"

input_ids = tokenizer(query, return_tensors="pt").input_ids# 生成回答

outputs = model.generate(input_ids=input_ids, num_return_sequences=1, num_beams=2)

answer = tokenizer.batch_decode(outputs, skip_special_tokens=True)[0]

print("回答:", answer)九. 高级实现技巧

1 动态知识库更新

- 实时索引更新:设计支持实时添加、删除和更新文档的向量索引结构。

- 增量编码:在知识库更新时,只对新增或修改的文档进行编码和索引,避免重新编码全部文档。

- 流处理框架:使用

Apache Kafka、Apache Flink等流处理框架,实时处理和更新知识库数据。

2 跨模态检索与生成

- 多模态嵌入:将文本、图像、音频等不同模态的数据编码到统一的向量空间。

- 多模态检索器:设计支持

跨模态查询的检索器,例如基于图像查询相关文本或图像。 - 多模态生成:生成包含不同模态内容的复杂回答,例如生成带有图像描述的文本回答。

3 可解释性与透明性

- 检索来源标注:在生成的回答中标注引用的文档来源,增强对内容的可信度。

- 可视化工具:开发可视化工具,展示生成过程中的检索到的文档和生成的关注点。

- 可解释生成:通过

模型解释技术,如Attention可视化,展示生成内容的生成依据。

4 多语言与跨文化支持

- 多语言检索:训练支持多语言的检索模型,能够处理不同语言的查询和文档。

- 多语言生成:使用多语言生成模型,如

mBART、mT5,生成不同语言的回答。 - 跨语言知识迁移:利用跨语言嵌入,将不同语言之间的知识迁移和共享。

十. 实践中的代码示例

以下是一个更为详细的RAG-Token实现示例,涵盖知识库的构建、索引的创建、检索和生成的完整流程。

1 构建自定义知识库并创建FAISS索引

from transformers import DPRContextEncoder, DPRContextEncoderTokenizer

import faiss

import torch# 初始化DPR文档编码器和分词器

doc_encoder = DPRContextEncoder.from_pretrained("facebook/dpr-ctx_encoder-single-nq-base")

doc_tokenizer = DPRContextEncoderTokenizer.from_pretrained("facebook/dpr-ctx_encoder-single-nq-base")# 加载或准备知识库文档

documents = ["2024年诺贝尔奖的化学奖获得者是...","诺贝尔物理学奖的获奖者包括...",# 添加更多文档

]# 编码文档

encoded_docs = doc_tokenizer(documents, padding=True, truncation=True, return_tensors="pt")

with torch.no_grad():doc_embeddings = doc_encoder(**encoded_docs).pooler_output.cpu().numpy()# 构建FAISS索引

dimension = doc_embeddings.shape[1]

index = faiss.IndexFlatIP(dimension) # Inner Product相似度

index.add(doc_embeddings) # 添加向量到索引# 保存索引和文档

faiss.write_index(index, "custom_faiss.index")

with open("custom_documents.txt", "w", encoding="utf-8") as f:for doc in documents:f.write(doc + "\n")2 初始化Hugging Face的RAG模型与自定义知识库

from transformers import RagTokenizer, RagRetriever, RagSequenceForGeneration# 加载自定义文档

passages_path = "custom_documents.txt"

index_path = "custom_faiss.index"# 初始化tokenizer、retriever和模型

tokenizer = RagTokenizer.from_pretrained("facebook/rag-token-nq")

retriever = RagRetriever.from_pretrained("facebook/rag-token-nq",index_name="custom",passages_path=passages_path,index_path=index_path

)

model = RagSequenceForGeneration.from_pretrained("facebook/rag-token-nq", retriever=retriever)# 用户查询

query = "2024年诺贝尔奖的获奖者有哪些?"

input_ids = tokenizer(query, return_tensors="pt").input_ids# 生成回答

outputs = model.generate(input_ids=input_ids, num_return_sequences=1, num_beams=2)

answer = tokenizer.batch_decode(outputs, skip_special_tokens=True)[0]

print("回答:", answer)3 联合训练检索器和生成器

以下是一个简化的联合训练示例,展示如何同时优化检索器和生成器。实际应用中,需要更复杂的训练流程和数据管道。

from transformers import RagTokenizer, RagRetriever, RagSequenceForGeneration, AdamW

import torch# 初始化tokenizer、retriever和模型

tokenizer = RagTokenizer.from_pretrained("facebook/rag-token-nq")

retriever = RagRetriever.from_pretrained("facebook/rag-token-nq", index_name="exact", use_dummy_dataset=True)

model = RagSequenceForGeneration.from_pretrained("facebook/rag-token-nq", retriever=retriever)# 准备训练数据

train_queries = ["2024年诺贝尔奖的获奖者有哪些?"]

train_answers = ["2024年诺贝尔奖的获奖者包括..."]# 优化器

optimizer = AdamW(model.parameters(), lr=5e-5)# 训练循环

model.train()

for epoch in range(num_epochs):for query, answer in zip(train_queries, train_answers):# 编码输入和目标inputs = tokenizer(query, return_tensors="pt")labels = tokenizer(answer, return_tensors="pt").input_ids# 前向传播outputs = model(input_ids=inputs.input_ids, labels=labels, use_cache=False)loss = outputs.loss# 反向传播loss.backward()optimizer.step()optimizer.zero_grad()print(f"Epoch {epoch}, Loss: {loss.item()}")十一. RAG与其他模型的对比

1 传统生成模型 vs. RAG

| 特性 | 传统生成模型 (如GPT) | RAG |

|---|---|---|

| 知识来源 | 训练数据集 | 训练数据集 + 动态检索的外部知识库 |

| 知识更新 | 需要重新训练模型才能更新知识 | 动态检索,能够实时获取最新信息 |

| 回答准确性 | 依赖于训练数据,可能存在知识盲区 | 通过检索相关文档提升回答的准确性和细节 |

| 计算复杂度 | 只需一次生成 | 需要检索和生成两个阶段,计算复杂度相对较高 |

| 可扩展性 | 固定的模型参数,难以扩展知识覆盖范围 | 易于通过扩展知识库来提升知识覆盖范围 |

2 检索-生成框架 vs. 单一生成框架

| 特性 | 检索-生成框架 (如RAG) | 单一生成框架 |

|---|---|---|

| 知识库依赖 | 依赖独立的外部知识库 | 知识嵌入在模型参数中 |

| 知识覆盖 | 可通过扩展知识库无限扩展知识覆盖范围 | 限于训练数据集的知识覆盖范围 |

| 生成内容的准确性与一致性 | 通过检索到的相关文档提升生成内容的准确性和一致性 | 生成内容可能因训练数据不足而无法保证准确性和一致性 |

| 更新灵活性 | 知识库可以独立更新,不需要重新训练生成模型 | 需要重新训练模型以更新知识 |

3 RAG与其他检索-生成模型

RAG是众多检索-生成模型中的一种,其他模型如REALM(Retrieval-Augmented Language Model)、FiD(Fusion-in-Decoder)等也采用类似的架构,但在具体实现细节和优化策略上有所不同。

总结

RAG(Retrieval-Augmented Generation)作为一种结合信息检索与生成式模型的混合架构,通过动态检索外部知识库显著提升了自然语言生成任务的准确性、丰富性和知识覆盖范围。其具体实现涉及检索器和生成器的选择与优化、知识库的构建与管理、向量索引与检索技术的应用,以及检索与生成的集成机制。尽管RAG在实现和训练过程中面临诸多挑战,如计算资源需求、知识库维护和生成内容的准确性等,但通过不断的技术创新和优化,RAG在开放域问答、客服机器人、学术研究辅助、内容创作等多个领域展现出强大的应用潜力。

随着向量检索技术、生成模型和知识库管理技术的不断进步,RAG有望在更多复杂和多样化的应用场景中发挥关键作用,推动自然语言处理技术的发展和应用。未来的研究将集中在提升检索与生成的效率和准确性、扩展多模态和多语言支持、增强模型的解释性和透明性等方面,进一步拓展RAG的应用边界和实际价值。

结~~~