一、GPT预训练有什么节省显存和算力的技巧吗?我如何拿四块A100完成175B模型的预训练?

对于GPT预训练,有一些技巧可以帮助节省显存和算力。以下是一些常用的技巧:

按批次截断:在较长的文本序列中,将其切割成较短的子序列进行处理。这样可以减少每个批次的序列长度,节省显存和算力。

动态掩码:对于较长的序列,可以动态地将一部分标记设置为特殊的掩码标记,从而减少计算量和显存使用。

梯度累积:将多个小批次的梯度累积并一起更新模型参数。这样可以减少显存需求,并使得模型更加稳定。

混合精度训练:使用混合精度训练可以减少显存使用,并提高模型训练速度。

至于如何使用四块A100来完成175B模型的预训练,这取决于模型架构和所使用的训练框架。然而,通常情况下,可以采用数据并行训练的策略,其中不同的GPU处理不同的数据子集,并定期同步以更新模型参数。具体的实现方法可以参考相关的训练框架和文档。

完全没有提扩展的事情。

二、我现在有一个6B的GPT小模型,我想把它训练成一个175B的大模型,该怎么做?请给出具体步骤。

对于将一个6B的GPT小模型训练成一个175B的大模型,需要进行以下步骤:

数据准备:确保你有足够的高质量文本数据来训练大模型。这些数据应包含多样化的主题和语言风格,以提高模型的泛化能力。

训练环境准备:由于目标是训练一个大模型,需要强大的计算资源和适当的训练环境。建议使用具备高性能GPUs或TPUs的云服务提供商,以加快训练速度。

扩展模型架构:将模型架构从6B扩展到175B。这涉及到增加模型的层数、隐藏单元数以及其他相关参数。这一步需要进行仔细的设计和调整,以确保模型能够适应更大的规模。

参数初始化:使用预训练的6B模型的权重作为初始参数,并根据扩展后的模型架构进行适当的调整。

数据并行训练:由于内存限制,无法将整个数据集加载到内存中进行训练。因此,使用数据并行训练技术,将数据集分成小批次进行并行训练。

学习率调度:在训练过程中,使用适当的学习率调度策略,例如逐渐降低学习率或使用动态学习率调整方法,以优化训练效果并加快收敛速度。

训练时间和迭代次数:由于模型的规模增大,训练时间和所需的迭代次数可能会显著增加。根据实际情况,分配足够的时间来完成训练,并确保模型达到收敛。

请问还有其他问题吗?

三、假设我有一个12层的GPT模型,我想把它扩展到24层,每层的结构不变,参数尽可能复用,请给出PyTorch 代码。

要将一个12层的GPT模型扩展到24层,并且保持每层结构不变,可以通过复制模型的前12层来实现。下面是使用PyTorch的代码示例:

import torch

import torch.nn as nnclass GPT(nn.Module):def __init__(self, num_layers):super(GPT, self).__init__()self.num_layers = num_layersself.layers = nn.ModuleList([nn.Linear(768, 768) for _ in range(num_layers)]) # 假设输入维度为768def forward(self, x):for i in range(self.num_layers):x = self.layers[i](x)return x# 创建12层GPT模型

model = GPT(num_layers=12)# 复制前12层来构建24层GPT模型

new_model = GPT(num_layers=24)

for i in range(model.num_layers):new_model.layers[i] = model.layers[i]# 打印新模型的层数

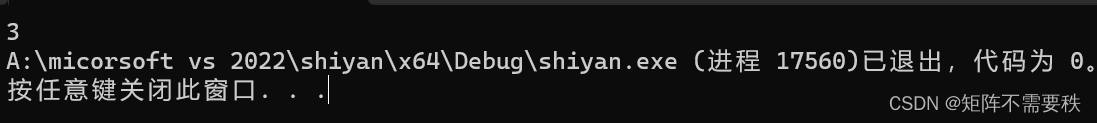

print(new_model.num_layers) # 输出: 24

这样完全不对,后12的参数显然是没有初始化的。

四、假设我有一个12层的GPT模型,我想把它扩展到24层,采用copy.deepcopy实现,请给出PyTorch 代码。

要将一个12层的GPT模型扩展到24层,可以使用copy.deepcopy来实现。以下是使用PyTorch的代码示例:

import torch

import copyclass GPTModel(torch.nn.Module):def __init__(self, num_layers):super(GPTModel, self).__init__()self.layers = torch.nn.ModuleList([torch.nn.Linear(768, 768) for _ in range(num_layers)])def forward(self, x):for layer in self.layers:x = layer(x)return x# 创建一个12层的GPT模型

gpt_model_12_layers = GPTModel(num_layers=12)# 使用copy.deepcopy将其扩展到24层

gpt_model_24_layers = copy.deepcopy(gpt_model_12_layers)

gpt_model_24_layers.layers.extend(copy.deepcopy(gpt_model_12_layers.layers))# 打印模型结构,可以看到已经扩展到24层

print(gpt_model_24_layers)

这回对了一半,但显然每层复制一份插到后面才是最优的扩展策略,再试试。

五、假设我有一个12层的GPT模型,我想把它扩展到24层,每层复制一份插入到他的后面,采用copy.deepcopy实现,请给出PyTorch 代码。

你可以使用以下代码将一个12层的GPT模型扩展到24层,并在每一层后面插入复制的层:

import copy

import torchclass GPTModel(torch.nn.Module):def __init__(self, num_layers):super(GPTModel, self).__init__()self.layers = torch.nn.ModuleList([torch.nn.Linear(768, 768) for _ in range(num_layers)])def forward(self, x):for layer in self.layers:x = layer(x)return xnum_layers = 12

gpt_model = GPTModel(num_layers)# 将模型扩展为24层

for _ in range(num_layers):layer_copy = copy.deepcopy(gpt_model.layers[_])gpt_model.layers.append(layer_copy)print(gpt_model)

这段代码中,我们定义了一个 GPTModel 类,其中包含一个由线性层组成的 layers 列表。通过使用 torch.nn.ModuleList,我们可以将层添加到模型中。然后,我们使用 copy.deepcopy 复制每一层,并将复制的层添加到 layers 列表中。

这样还是不对,新添加的层还是放到了最后。

正确版本是

gpt_model.layers = torch.nn.ModuleList(sum([[l, copy.deepcopy(l)] for l in gpt_model.layers ], []))

六、这次试试一次性提供所有信息,看看能不能写对。

假设我有一个GPT模型

gpt,gpt.layers是每一个GPT层,请写一段Python代码,使用copy.deepcopy()将每一层复制一份,插入到该层后面,并将复制后的层传回gpt。

要将每一层复制一份并插入到该层后面,可以使用循环遍历gpt.layers,并使用copy.deepcopy()进行深拷贝。然后将复制后的层插入到原来的层之后。下面是实现这个过程的Python代码:

import copydef duplicate_layers(gpt):new_layers = []for layer in gpt.layers:new_layer = copy.deepcopy(layer)new_layers.append(layer)new_layers.append(new_layer)gpt.layers = new_layersreturn gpt

上述代码首先创建一个新的空列表new_layers,然后使用循环遍历每一个层layer。对于每一层,我们使用copy.deepcopy()进行深拷贝,得到一个副本new_layer。接着,将原来的层和副本层依次添加到new_layers中。最后,将new_layers赋值给gpt.layers,即将复制后的层传回gpt。

除了没加

torch.nn.ModuleList都对了。

七、现在我有两个PyTorch 模块mod1和mod2,它们的参数结构完全一样,请写一段Python代码,合并这两个模块的参数,新的参数取它们的平均。

可以使用PyTorch的state_dict()方法获取模型的参数字典,然后将两个模块的参数字典合并并取平均,最后加载回新的模型中。下面是一个示例代码:

import torch# 获取模块的参数字典

mod1_params = mod1.state_dict()

mod2_params = mod2.state_dict()# 合并参数字典并取平均

merged_params = {}

for key in mod1_params.keys():merged_params[key] = (mod1_params[key] + mod2_params[key]) / 2# 加载新的参数到模型中

mod1.load_state_dict(merged_params)

这个一次性回答对。

八、假设我有一个GPT模型gpt,gpt.layers是它的每一层,请写一段代码,使用state_dict()把每两层合并成一层,新的层的参数取两个层的均值,之后将合并后的层放入gpt。

很高兴回答你的问题!下面是代码示例,用于合并gpt模型的每两层,并将合并后的层放入gpt:

import torch# 获取模型的层列表

layers = list(gpt.layers)# 定义新的层列表

new_layers = []# 合并每两层

for i in range(0, len(layers), 2):if i + 1 < len(layers):# 获取两个层的参数params1 = layers[i].state_dict()params2 = layers[i + 1].state_dict()# 计算参数的均值merged_params = {}for key in params1.keys():merged_params[key] = (params1[key] + params2[key]) / 2# 创建新的合并层merged_layer = type(layers[i])(**merged_params)new_layers.append(merged_layer)else:# 如果模型层数为奇数,最后一层保持不变new_layers.append(layers[i])# 将合并后的层放入模型

gpt.layers = torch.nn.ModuleList(new_layers)

希望这段代码对你有帮助!如果你有任何其他问题,请随时提问。

这次一次性答对,但是如果不提示

state_dict()就完全想不到。