大模型学习笔记------BLIP模型的再思考

- 1、BLIP推理---如何进行“图生文”

- 2、BLIP推理---如何进行视觉问答(Visual Question Answering, VQA)

- 3、BLIP推理---如何进行图文检索(Image-text retrieval)任务

- 4、总结

上一篇文章上文中讲解了 BLIP(Bootstrapping Language-Image Pretraining)模型的网络结构与相关的训练技巧。本文将再自己其他方面的思考进行讲解。

1、BLIP推理—如何进行“图生文”

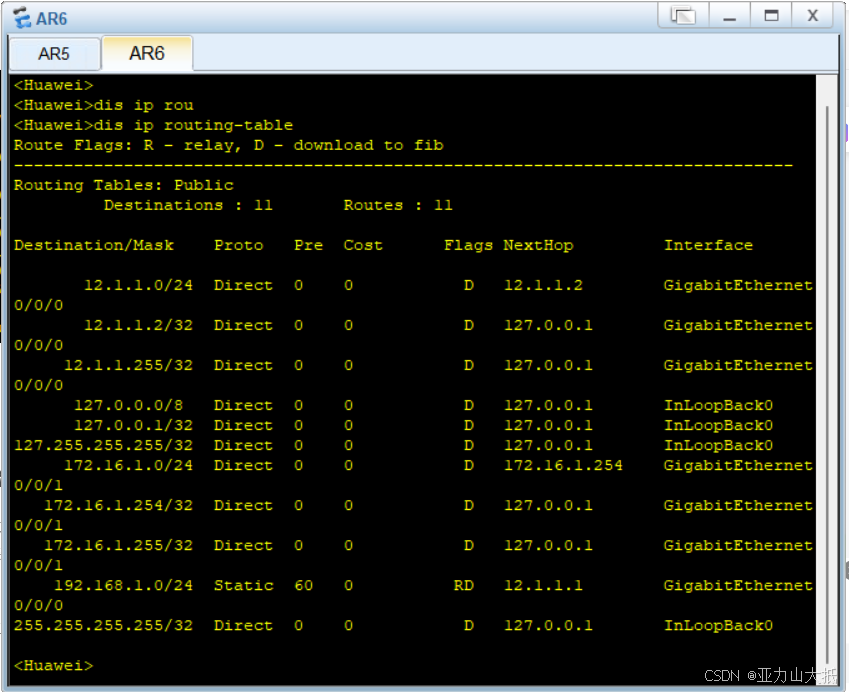

在上篇文章中讲到了BLIP可以完成图像描述生成(Image Caption)任务(“图生文”),那么如何完成这个任务呢?其实完成这个任务只需要BLIP模型中的两个模块即可,即视觉编码器(lmage Encoder)与视觉-文本解码器(image-grounded text decoder),具体如下所示:

这也很好理解,“图生文”任务肯定是由图像生成文字,那必然有生成模块和图像编码的过程。而且这需要这两个模块就可以。

但是这里面还有一个问题,BLIP模块进行“图生文”任务需不需要Prompt,也就是是否需要提示词。我认为可以有也可以没有,因为算法的设计使得模型在理解图像内容的同时,也能够生成对应的文本描述。这种架构的灵活性使得模型能够适应不同的输入方式。虽然在没有 prompt 的情况下模型仍然可以生成文本,但使用 prompt 可以提高生成文本的相关性和准确性。

2、BLIP推理—如何进行视觉问答(Visual Question Answering, VQA)

如何完成视觉问答(VQA)任务呢?完成这个任务需要BLIP模型中的视觉编码器(lmage Encoder)、视觉-文本编码器(image-grounded text encoder)与视觉-文本解码器(image-grounded text decoder)。通过视觉编码器和视觉-文本编码器建立图像与文本(问题)的关系,将图像与问题融合后的特征输入到视觉-文本解码器中并生成相应的文本。具体如下所示:

3、BLIP推理—如何进行图文检索(Image-text retrieval)任务

如何完成图文检索(Image-text retrieval)任务呢?其实这个任务与CLIP几乎一摸一样,其实就是进行图像与文本的相似度计算,如果不明白的话,可以查看在以前文章中对CLIP模型的讲解。具体如下所示

其实这个任务或是分类任务完全可以使用CLIP模型,CLIP相对于BLIP模型更加简便,训练难度更低,对硬件的要求也更低。

4、总结

本文主要是对上一篇文章的补充,如果需要其他讨论的问题可以再评论区进行探讨。同时,如果我的想法有瑕疵也希望各位指教。

![快速掌握——python类 封装[私有属性方法]、继承【python进阶】(内附代码)](https://i-blog.csdnimg.cn/direct/197be31c30e645398fdb1fee0e09d9ca.png)