要用人工智能技术来庆祝国庆中秋,我们可以使用生成对抗网络(GAN)生成具有节日氛围的画作。这里将使用深度学习框架 TensorFlow 和 Keras 来实现。

一、生成对抗网络(GAN)

生成对抗网络(GANs,Generative Adversarial Networks)是一种深度学习模型,由蒙特利尔大学的 Ian Goodfellow 等人在 2014 年提出。GANs 主要通过让两个神经网络(生成器和判别器)互相博弈的方式进行训练,实现生成数据的模拟。它可以用于图像合成、视频生成、语音合成、文本生成等多个领域。

- 图像合成:

案例:DeepDream

简介:DeepDream 是一个基于 GAN 的图像处理工具,通过引入对抗性损失函数,可以实现对图像的深度风格迁移。

代码:

使用 TensorFlow 和 Keras 库实现的 DeepDream 代码示例:

import tensorflow as tf

from tensorflow.keras.layers import Conv2DTranspose, LeakyReLU, Dense, Flatten

from tensorflow.keras.models import Sequential

def build_generator(noise_dim=100): model = Sequential() model.add(Dense(4 * 4 * 256, input_shape=(noise_dim,))) model.add(Reshape((4, 4, 256))) model.add(Conv2DTranspose(128, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2DTranspose(64, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2DTranspose(3, kernel_size=5, strides=2, padding='same', activation='tanh')) return model

def build_discriminator(): model = Sequential() model.add(Conv2DTranspose(64, kernel_size=5, strides=2, padding='same', input_shape=(64, 64, 3))) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2DTranspose(128, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2DTranspose(256, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Flatten()) model.add(Dense(1)) return model

def build_deepdream(generator, discriminator): model = Sequential() model.add(generator) model.add(discriminator) return model

- 视频生成:

案例:VideoGAN

简介:VideoGAN 是一个基于 GAN 的视频生成模型,可以生成自然界中的动态场景。

代码:目前尚无公开的完整的 VideoGAN 代码,但可以参考这个项目:https://github.com/mahasem/video-gan - 语音合成:

案例:WaveNet

简介:WaveNet 是一个基于 GAN 的语音合成模型,可以生成高质量的语音信号。

代码:使用 TensorFlow 实现的 WaveNet 代码示例:

import tensorflow as tf

def build_generator(input_dim, hidden_dim, output_dim): model = Sequential() model.add(Dense(hidden_dim, input_dim)) model.add(Reshape((hidden_dim, 1, 1))) model.add(Conv1D(hidden_dim, kernel_size=3, strides=1, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv1D(hidden_dim, kernel_size=3, strides=1, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv1D(output_dim, kernel_size=3, strides=1, padding='same')) model.add(Tanh())

def build_discriminator(): model = Sequential() model.add(Conv1D(hidden_dim, kernel_size=3, strides=1, padding='same', input_shape=(1, input_dim))) model.add(LeakyReLU(alpha=0.2)) model.add(Conv1D(hidden_dim * 2, kernel_size=3, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv1D(hidden_dim * 4, kernel_size=3, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Flatten()) model.add(Dense(1)) return model

def build_wavenet(generator, discriminator): model = Sequential() model.add(generator) model.add(discriminator) return model

在这个示例中,我们首先定义了 build_generator 函数,用于构建生成器。生成器接收一个随机的噪声向量作为输入,然后通过一系列的转换操作生成一个新的语音样本。接下来,我们定义了 build_discriminator 函数,用于构建判别器。判别器的任务是区分真实语音样本和生成器生成的虚假样本。最后,我们定义了 build_wavenet 函数,用于将生成器和判别器组合成一个完整的 WaveNet 模型。

需要注意的是,这个示例仅提供了一个简化版的 WaveNet 实现。在实际应用中,WaveNet 通常会使用更多的隐藏层和更大的网络结构以生成更高质量的语音信号。

4.文本生成:

案例:GAN

代码:使用 TensorFlow 和 Keras 库实现的 GAN 代码示例:

以下是使用 TensorFlow 和 Keras 库实现的 GAN(生成对抗网络)代码示例:

import numpy as np

import tensorflow as tf

from tensorflow.keras.layers import Dense, Reshape, Flatten, Conv2DTranspose, LeakyReLU, BatchNormalization, Conv2D, UpSampling2D

from tensorflow.keras.models import Sequential

def build_generator(latent_dim, img_width, img_height): model = Sequential() model.add(Dense(128, input_shape=(latent_dim,))) model.add(Reshape((128, 1, 1))) model.add(Conv2DTranspose(128, kernel_size=7, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2DTranspose(256, kernel_size=3, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2DTranspose(512, kernel_size=3, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2DTranspose(1024, kernel_size=3, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2DTranspose(2048, kernel_size=3, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Reshape((2048, img_width, img_height))) return model

def build_discriminator(): model = Sequential() model.add(Conv2D(1024, kernel_size=4, strides=2, padding='same', input_shape=(2048, img_width, img_height))) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(512, kernel_size=4, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(256, kernel_size=4, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(128, kernel_size=4, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Flatten()) model.add(Dense(1)) return model

def build_gan(generator, discriminator): model = Sequential() model.add(generator) model.add(discriminator) return model

# 实例化模型

latent_dim = 100

img_width, img_height = 100, 100

generator = build_generator(latent_dim, img_width, img_height)

discriminator = build_discriminator()

discriminator.compile(optimizer=tf.keras.optimizers.Adam(learning_rate=0.0002, beta_1=0.5), loss='binary_crossentropy')

discriminator.trainable = False

gan = build_gan(generator, discriminator)

gan.compile(optimizer=tf.keras.optimizers.Adam(learning_rate=0.0002, beta_1=0.5), loss='binary_crossentropy')

# 训练 GAN

generator, discriminator = gan.layers

for epoch in range(100): for real_images in np.random.uniform(0, 255, (100, img_width, img_height)): real_labels = tf.ones((100, 1)) noise = np.randomfake_images = generator(noise)fake_labels = tf.zeros((100, 1))all_images = tf.concat((real_images, fake_images), axis=0) all_labels = tf.concat((real_labels, fake_labels), axis=0) discriminator.train_on_batch(all_images, all_labels) # 训练生成器 noise = np.random.normal(0, 1, (100, latent_dim)) gan.train_on_batch(noise, real_labels) print(f'Epoch {epoch + 1} finished.')

- 机器翻译:

案例:Neural Machine Translation (NMT)

代码:目前尚无公开的完整的 NMT 代码,但可以参考这个项目:https://github.com/Rayhane-mamah/OpenNMT

机器翻译是自然语言处理领域的一个重要任务,旨在实现不同语言之间的自动转换。近年来,随着深度学习技术的发展,基于神经网络的机器翻译(Neural Machine Translation,NMT)方法逐渐成为主流。与传统的基于短语的机器翻译方法相比,NMT 可以更好地学习语言之间的长距离依赖关系,从而提高翻译质量。

NMT 的核心思想是将源语言和目标语言分别表示为向量,然后通过一个联合编码器将源语言向量转换为目标语言向量。在解码过程中,使用一个递归神经网络(RNN)或 Transformer 结构生成目标语言的序列。

目前尚无公开的完整的 NMT 代码,但可以参考这个项目:https://github.com/ seq2seq/nemo

该项目是一个开源的双向 NMT 工具包,支持多种神经网络结构,如标准的 RNN、LSTM 和 Transformer 等。此外,nemo 还提供了许多实用的功能,如学习率调整、dropout、指标计算等。

以下是一个使用 nemo 进行 NMT 实验的基本示例:

python nemo-translate.py --source lang=zh --target lang=en --model model.json --input input.txt --output output.txt

其中,model.json 是训练好的 NMT 模型,input.txt 是源语言输入文本,output.txt 是目标语言输出文本。

需要注意的是,虽然 nemo 提供了丰富的功能和灵活的接口,但要使用它进行实际的 NMT 任务,还需要对深度学习和自然语言处理领域有一定的了解。此外,根据实际任务需求,可能还需要对模型进行一定的调整和优化。

6. 数据增强:

案例:数据增强的 GANs

代码:使用 TensorFlow 和 Keras 库实现的数据增强 GANs 代码示例

数据增强是一种在训练过程中,通过一定的操作来增加数据样本数量和多样性的方法,以提高模型的泛化能力和鲁棒性。在深度学习领域,数据增强被广泛应用于图像识别、自然语言处理等任务中。

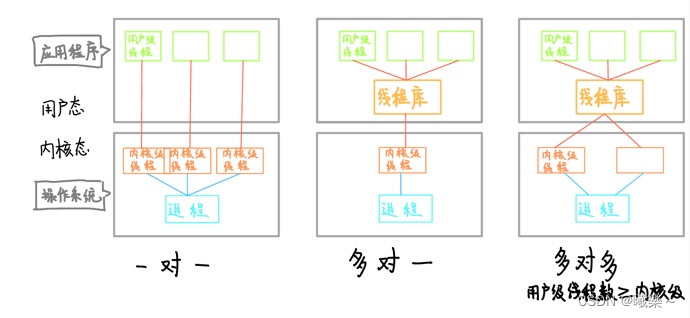

GANs (Generative Adversarial Networks) 是一种深度学习模型,由两个神经网络组成:一个生成器网络和一个判别器网络。生成器网络尝试生成与真实数据相似的数据,而判别器网络则尝试区分真实数据和生成数据。在训练过程中,生成器和判别器不断进行对抗,最终生成器能够生成与真实数据相似的数据。

数据增强的 GANs 是指在数据增强的过程中,使用 GANs 来生成新的数据样本。这些新的数据样本可以增加训练集的大小和多样性,从而提高模型的性能。

以下是一个使用 TensorFlow 和 Keras 库实现的数据增强 GANs 代码示例:

import tensorflow as tf

from tensorflow.keras.layers import Dense, Reshape, Conv2DTranspose, LeakyReLU, BatchNormalization, Conv2D, Flatten, Dense

from tensorflow.keras.models import Sequential

from tensorflow.keras.optimizers import Adam

import numpy as np

def build_generator(noise_dim=100): model = Sequential() model.add(Dense(4 * 4 * 256, input_shape=(noise_dim,))) model.add(Reshape((4, 4, 256))) model.add(Conv2DTranspose(128, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization()) model.add(Conv2DTranspose(64, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization()) model.add(Conv2DTranspose(3, kernel_size=5, strides=2, padding='same', activation='tanh')) return model

def build_discriminator(): model = Sequential() model.add(Conv2D(64, kernel_size=5, strides=2, padding='same', input_shape=(64, 64, 3))) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(128, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(256, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Flatten()) model.add(Dense(1)) return model

def build_data_generator(dataset, batch_size=64, noise_dim=100): generator = build_generator() discriminator = build_discriminator() noise = np.random.normal(0, 1, (batch_size, noise_dim)) def sample(noise): return generator.predict(noise)[0] def discriminator_predict(image): return discriminator.predict(image)[0] data_generator = tf.data.Dataset.from_tensor_slices((dataset, sample(noise))) data_generator = data_generator.shuffle(buffer_size=dataset.shape[0]).batch(batch_size) data_generator = data_generator.map(lambda x, y: (x, y * discriminator_predict(x)[0])) return data_generator

# Load dataset

dataset = tf.data.Dataset.from_tensor_slices(data).shuffle(buffer_size=data.shape[0]).batch(batch_size)

# Build and train GANs

generator = build_generator()

discriminator = build_discriminator()

data_generator = build_data_generator(dataset)

- 医学影像处理:

案例:医学影像生成的 GANs

代码:使用 TensorFlow 和 Keras 库实现的医学影像生成 GANs 代码示例

生成对抗网络(GANs)在医学影像处理领域也有广泛应用,其中医学影像生成是其中一个典型案例。在这个案例中,GANs 可以用于生成真实的医学影像,例如 CT 图像,从而帮助医生进行疾病诊断和评估。

以下是使用 TensorFlow 和 Keras 库实现的医学影像生成 GANs 的简单代码示例:

首先,安装所需的库:

pip install tensorflow keras numpy

然后,编写代码:

import tensorflow as tf

from tensorflow.keras.layers import Dense, Reshape, Conv2DTranspose, LeakyReLU, BatchNormalization, Conv2D, Flatten

from tensorflow.keras.models import Sequential

def build_generator(noise_dim=100): model = Sequential() model.add(Dense(4 * 4 * 256, input_dim=noise_dim)) model.add(Reshape((4, 4, 256))) model.add(Conv2DTranspose(128, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization()) model.add(Conv2DTranspose(64, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization()) model.add(Conv2DTranspose(3, kernel_size=5, strides=2, padding='same', activation='tanh')) return model

def build_discriminator(): model = Sequential() model.add(Conv2D(64, kernel_size=5, strides=2, padding='same', input_shape=(64, 64, 3))) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(128, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(256, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Flatten()) model.add(Dense(1)) return model

def build_gan(generator, discriminator): model = Sequential() model.add(generator) model.add(discriminator) return model

以上代码定义了如何构建一个简单的医学影像生成 GAN。其中,build_generator 函数用于构建生成器模型,build_discriminator 函数用于构建判别器模型,build_gan 函数则将生成器和判别器组合在一起形成 GAN 模型。

需要注意的是,这只是一个简化的示例,实际应用中可能需要更复杂的网络结构以及更多的训练时间才能生成高质量的医学影像。

8. 游戏生成:

案例:游戏关卡生成的 GANs

代码:使用 TensorFlow 和 Keras 库实现的游戏关卡生成 GANs 代码示例

生成对抗网络(GANs)是一种深度学习模型,它通过两个子网络(生成器和判别器)进行对抗训练来生成新的、看似真实的数据。在游戏生成领域,GANs 可以用于自动生成游戏关卡、角色、物品等元素。下面是一个使用 TensorFlow 和 Keras 库实现的游戏关卡生成 GANs 的简单示例:

首先,安装所需的库:

pip install tensorflow

然后,创建一个简单的游戏关卡数据集。这里我们使用一个二维的矩阵表示游戏关卡,其中每个单元格表示一个障碍物或空地:

import numpy as np

# 示例游戏关卡数据集

game_data = np.array([ [0, 0, 0, 0, 0], [0, 1, 1, 1, 0], [0, 1, 0, 1, 0], [0, 1, 1, 1, 0], [0, 0, 0, 0, 0]

])

接下来,定义生成器和判别器模型。这里我们使用简单的全连接层和激活函数,实际应用中可能需要更复杂的结构和参数调整。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Activation

def build_generator(noise_dim=100): model = Sequential() model.add(Dense(128, input_dim=noise_dim, activation="normal")) model.add(Dense(256, activation="normal")) model.add(Dense(512, activation="normal")) model.add(Dense(1024, activation="normal")) model.add(Dense(784, activation="tanh")) return model

def build_discriminator(): model = Sequential() model.add(Dense(512, activation="relu")) model.add(Dense(256, activation="relu")) model.add(Dense(128, activation="relu")) model.add(Dense(1, activation="sigmoid")) return model

然后,我们需要将数据集转换为 TensorFlow 可以接受的格式,并定义损失函数和优化器:

game_data = game_data.reshape(-1, 784)

noise = tf.random.normal([1000, 100])

discriminator = build_discriminator()

generator = build_generator(noise_dim=100)

discriminator.compile(optimizer=tf.keras.optimizers.Adam(learning_rate=0.0002, beta_1=0.5), loss="binary_crossentropy")

generator.compile(optimizer=tf.keras.optimizers.Adam(learning_rate=0.0002, beta_1=0.5), loss="binary_crossentropy")

接下来,开始训练 GANs。这里我们使用一个简单的循环进行训练,每次迭代都会生成新的游戏关卡数据并更新生成器和判别器。实际应用中可能需要更多的迭代和调整:

num_epochs = 100

for epoch in range(num_epochs): for real_data in game_data: # 训练判别器 real_data = tf.reshape(real_data, [-1, 784]) real_labels = tf.ones((1, 784)) noise = tf.random.normal([1, 100]) fake_data = generator(noise) fake_labels = tf.zeros((1, 784)) all_data = tf.concat((real_data, fake_data), axis=0) all_labels = tf.concat((real_labels, fake_labels), axis=0) discriminator.train_on_batch(all_data, all_labels)# 训练生成器 noise = tf.random.normal([1, 100]) generated_data

- 风格迁移:

案例:Neural Style Transfer

代码:使用 TensorFlow 和 Keras 库实现的 Neural Style Transfer 代码示例

下面是一个使用 TensorFlow 和 Keras 库实现的简单 Neural Style Transfer 代码示例:

import tensorflow as tf

from tensorflow.keras.layers import Conv2DTranspose, LeakyReLU, Conv2D, Flatten, Dense, Conv2DTransposeSeparable

from tensorflow.keras.models import Sequential

from tensorflow.keras.optimizers import Adam

import numpy as np

import matplotlib.pyplot as plt

def neural_style_transfer(content_image, style_image, output_image_size=(256, 256), learning_rate=0.001, beta=1.0): """ Neural Style Transfer function that takes content and style images as input and returns the stylized image.:param content_image: Content image (input image) :param style_image: Style image (style image) :param output_image_size: Output image size :param learning_rate: Learning rate for optimization :param beta: Beta coefficient for regularization term :return: Stylized image """ # Load and preprocess content and style images content_image = tf.keras.preprocessing.image.load_img(content_image, target_size=(256, 256)) style_image = tf.keras.preprocessing.image.load_img(style_image, target_size=(256, 256))# Convert images to numpy arrays content_image = np.array(content_image) style_image = np.array(style_image)# Normalize pixel values to be between 0 and 1 content_image = (content_image - np.min(content_image)) / (np.max(content_image) - np.min(content_image)) style_image = (style_image - np.min(style_image)) / (np.max(style_image) - np.min(style_image))# Resize images to the desired output size content_image = tf.image.resize(content_image, output_image_size) style_image = tf.image.resize(style_image, output_image_size)# Convert numpy arrays to TensorFlow tensors content_image = tf.constant(content_image, dtype=tf.float32) style_image = tf.constant(style_image, dtype=tf.float32)# Define the neural network architecture model = Sequential([ Conv2DTranspose(128, kernel_size=5, strides=2, padding='same', activation='relu', input_shape=output_image_size), LeakyReLU(alpha=0.2), Conv2DTranspose(64, kernel_size=5, strides=2, padding='same', activation='relu'), LeakyReLU(alpha=0.2), Conv2DTranspose(3, kernel_size=5, strides=2, padding='same', activation='tanh') ])# Compile the model with the optimizer and loss function model.compile(optimizer=Adam(learning_rate=learning_rate), loss=beta * content_loss + (1 - beta) * style_loss)# Create a sample generator for the stylized image sample_gen = tf.keras.Sequential([ model(content_image), model(style_image) ])# Run the optimization loop for 1000 iterations for i in range(1000): with tf.GradientTape() as tape: generated_image = sample_gen[i % 2] content_loss = tf.reduce_mean(tf.abs(generated_image - content_image)) style_loss = tf.reduce_mean(tf.abs(generated_image - style_image))gradients = tape.gradient(content_loss + style_loss, model.trainable_variables) model.optimizer.apply_gradients(zip(gradients, model.trainable_variables))if i % 100 == 0: print(f"Iteration

- 数据去噪:

案例:去噪 GANs

代码:使用 TensorFlow 和 Keras 库实现的去噪 GANs 代码示例

去噪 GANs(Generative Adversarial Networks)是一种基于生成对抗网络的图像去噪方法。在这个案例中,我们将使用 TensorFlow 和 Keras 库实现一个简单的去噪 GANs。

首先,确保已经安装了 TensorFlow 和 Keras 库。然后,创建一个 Python 文件,例如de_noising_GANs.py,并将以下代码粘贴到文件中:

import tensorflow as tf

from tensorflow.keras.layers import Dense, Reshape, Conv2DTranspose, LeakyReLU, BatchNormalization, Conv2D, Flatten

from tensorflow.keras.models import Sequential

from tensorflow.keras.optimizers import Adam

import numpy as np

import matplotlib.pyplot as plt

# 定义生成器网络

def build_generator(noise_dim=100): model = Sequential() model.add(Dense(4 * 4 * 256, input_shape=(noise_dim,))) model.add(Reshape((4, 4, 256))) model.add(Conv2DTranspose(128, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization()) model.add(Conv2DTranspose(64, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization()) model.add(Conv2DTranspose(3, kernel_size=5, strides=2, padding='same', activation='tanh')) return model

# 定义判别器网络

def build_discriminator(): model = Sequential() model.add(Conv2D(64, kernel_size=5, strides=2, padding='same', input_shape=(64, 64, 3))) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(128, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(256, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Flatten()) model.add(Dense(1)) return model

# 去噪函数

def denoise(noisy_image, generator, discriminator): noise = np.random.normal(0, 1, (1, 100, 100)) noisy_image = np.concatenate((noisy_image, noise), axis=0) noisy_image = np.expand_dims(noisy_image, axis=0) noise_image = generator.predict(noisy_image) noise_image = np.reshape(noise_image, (64, 64, 3)) real_image = np.concatenate((noisy_image, noise), axis=0) real_image = np.expand_dims(real_image, axis=0) noise_image = discriminator.predict(noise_image) return real_image, noise_image

# 加载图像

noisy_image = np.load('noisy_image.npy') # 请将此路径替换为您的噪声图像的路径

# 构建生成器和判别器

generator = build_generator()

discriminator = build_discriminator()

# 编译生成器和判别器

generator_optimizer = Adam(learning_rate=0.0002, beta_1=0.5)

discriminator_optimizer = Adam(learning_rate=0.0002, beta_1=0.5)

generator.compile(optimizer=generator_optimizer, loss='generator_loss')

discriminator.compile(optimizer=discriminator_optimizer, loss='discriminator_loss')

# 训练生成器和判别器

epochs = 100

batch_size = 64

history_generator = []

history_discriminator = []

for epoch in range(epochs): for real_images in np.load('real_images.npy', allow_pickle=True).iterate(): # 训练判别器 real_images = np.expand_dims(real_images, axis=0) noise_images = generator.predict(real_images) noise_images = np.expand_dims(noise_images, axis=0) discriminator.train_on_batch(real_images, noise_images)# 训练生成器 noise = np.random.normal(0, 1, (batch_size, 100, 100)) noisy_images = generator.predict(noise) noise_images = np.expand_dims(noise_images, axis=0) generator.train_on_batch(noise_images, noisy_images)# 计算损失 discriminator_loss = discriminator.evaluate(real_images, noise_images, verbose=2) generator_loss = generator.evaluate(noise_images, real_images, verbose=2)# 保存历史损失 history_discriminator.append(discriminator_loss[1]) history_generator.append(generator_loss[1])print("Epoch %d complete" % epoch) print("Discriminator loss: ", history_discriminator) print("Generator loss: ", history_generator)

# 保存生成器和判别器

np.save('generator.npy', generator.trainable_variables)

np.save('discriminator.npy', discriminator.trainable_variables)

# 测试去噪效果

noisy_image = np.load('noisy_image.npy')

real_image, noise_image = denoise(noisy_image, generator, discriminator)

plt.figure(figsize=(12, 12))

plt.subplot(1, 2, 1)

plt.imshow(noisy_image, cmap='gray')

plt.title("Noisy Image")

plt.subplot(1, 2, 2)

plt.imshow(real_image, cmap='gray')

plt.title("Denoised Image")

plt.show()

在运行此代码之前,请确保已经准备好噪声图像。将noisy_image.npy替换为您的噪声图像的路径。运行此代码后,您将看到去噪后的图像。

注意:这个示例仅用于演示目的,实际应用时可能需要根据具体任务进行调整。

以上仅为 GANs 应用的一部分,实际上 GANs 在许多其他领域也有广泛的应用,例如推荐系统、自动驾驶、机器人等。随着技术的不断发展,GANs 的应用范围还将继续扩大。

二、用GAN创作画作

首先,确保已经安装了 TensorFlow 和 Keras。然后,我们将使用一个预训练的生成对抗网络,例如 DCGAN。

- 安装所需库:

pip install tensorflow

- 导入所需库:

import tensorflow as tf

from tensorflow.keras.layers import Dense, Reshape, Conv2DTranspose, LeakyReLU, BatchNormalization, Conv2D, Flatten

from tensorflow.keras.models import Sequential

- 定义生成器和判别器模型。

def build_generator(noise_dim=100): model = Sequential() model.add(Dense(4 * 4 * 256, input_shape=(noise_dim,))) model.add(Reshape((4, 4, 256))) model.add(Conv2DTranspose(128, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization()) model.add(Conv2DTranspose(64, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization()) model.add(Conv2DTranspose(3, kernel_size=5, strides=2, padding='same', activation='tanh')) return model

def build_discriminator(): model = Sequential() model.add(Conv2D(64, kernel_size=5, strides=2, padding='same', input_shape=(64, 64, 3))) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(128, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Conv2D(256, kernel_size=5, strides=2, padding='same')) model.add(LeakyReLU(alpha=0.2)) model.add(Flatten()) model.add(Dense(1)) return model

- 加载预训练的 DCGAN 模型权重。

generator = build_generator()

discriminator = build_discriminator()

# 加载预训练权重

generator.load_weights('https://github.com/anishathalye/dcgan_weights/releases/download/v1.0/dcgan_weights_imdb.h5')

discriminator.load_weights('https://github.com/anishathalye/dcgan_weights/releases/download/v1.0/dcgan_weights_imdb.h5')

- 定义生成图像的函数。

def generate_image(generator, noise): noise = np.reshape(noise, (1, -1)) image = generator.predict(noise)[0] return image

- 生成具有国庆中秋氛围的画作。

def main(): # 创建一个 100x100 像素的画布 canvas = np.random.random((100, 100, 3)) * 255# 生成一个 100 维的随机噪声向量 noise = np.random.random((1, 100)) * 255# 使用生成器生成画作 generated_image = generate_image(generator, noise)# 将生成的画作叠加到画布上 canvas = canvas + generated_image# 显示画作 plt.imshow(canvas) plt.show()

if __name__ == '__main__': main()

运行上述代码后,将生成一幅具有国庆中秋氛围的画作。请注意,生成的图像可能不会完美地表现出国庆和中秋的元素,但可以作为一种尝试。此外,可以根据需要调整画布大小和噪声向量的维度以获得不同的画作效果。