文章目录~

- 1.GroUSE: A Benchmark to Evaluate Evaluators in Grounded Question Answering

- 2.MemoRAG: Moving towards Next-Gen RAG Via Memory-Inspired Knowledge Discovery

- 3.OneGen: Efficient One-Pass Unified Generation and Retrieval for LLMs

- 4.Bioinformatics Retrieval Augmentation Data (BRAD) Digital Assistant

- 5.Creating a Gen-AI based Track and Trace Assistant MVP (SuperTracy) for PostNL

- 6.BEAVER: An Enterprise Benchmark for Text-to-SQL

- 7.In Defense of RAG in the Era of Long-Context Language Models

- 8.Benchmarking Cognitive Domains for LLMs: Insights from Taiwanese Hakka Culture

- 9.The Compressor-Retriever Architecture for Language Model OS

- 10.GenAI-powered Multi-Agent Paradigm for Smart Urban Mobility: Opportunities and Challenges for Integrating Large Language Models (LLMs) and Retrieval-Augmented Generation (RAG) with Intelligent Transportation Systems

- 11.MaFeRw: Query Rewriting with Multi-Aspect Feedbacks for Retrieval-Augmented Large Language Models

- 12.Boosting Lossless Speculative Decoding via Feature Sampling and Partial Alignment Distillation

- 13.LRP4RAG: Detecting Hallucinations in Retrieval-Augmented Generation via Layer-wise Relevance Propagation

- 14.Writing in the Margins: Better Inference Pattern for Long Context Retrieval

- 15.Biomedical Large Languages Models Seem not to be Superior to Generalist Models on Unseen Medical Data

- 16.Towards Human-Level Understanding of Complex Process Engineering Schematics: A Pedagogical, Introspective Multi-Agent Framework for Open-Domain Question Answering

- 17.Graph Retrieval Augmented Trustworthiness Reasoning

- 18.Leveraging Chemistry Foundation Models to Facilitate Structure Focused Retrieval Augmented Generation in Multi-Agent Workflows for Catalyst and Materials Design

- 19.Xinyu: An Efficient LLM-based System for Commentary Generation

- 20.RAGLAB: A Modular and Research-Oriented Unified Framework for Retrieval-Augmented Generation

- 21.Reading with Intent

- 22.Retrieval-Augmented Generation Meets Data-Driven Tabula Rasa Approach for Temporal Knowledge Graph Forecasting

- 23.Agentic Retrieval-Augmented Generation for Time Series Analysis

- 24.Extracting polygonal footprints in off-nadir images with Segment Anything Model

- 25.CommunityKG-RAG: Leveraging Community Structures in Knowledge Graphs for Advanced Retrieval-Augmented Generation in Fact-Checking

1.GroUSE: A Benchmark to Evaluate Evaluators in Grounded Question Answering

标题:GroUSE:评估基础问题解答评估员的基准

author:Sacha Muller, António Loison, Bilel Omrani, Gautier Viaud

date Time:2024-09-10

paper pdf:http://arxiv.org/pdf/2409.06595v1

摘要:

检索增强生成(RAG)已成为在使用私有和最新知识库的同时使用大型语言模型(LLM)的常见范例。在这项工作中,我们探讨了在评估 RAG 系统生成的基础答案时使用 LLM 作为法官所面临的挑战。为了评估法官模型的校准和判别能力,我们确定了 7 种生成器故障模式,并引入了 GroUSE(Grounded QA Unitary Scoring of Evaluators)–一种包含 144 个单元测试的元评估基准。该基准揭示了现有的自动 RAG 评估框架往往会忽略重要的故障模式,即使使用 GPT-4 作为判据也是如此。 为了改善目前的自动 RAG 评估框架设计,我们提出了一个新颖的管道,并发现尽管封闭模型在 GroUSE 上表现良好,但最先进的开源评判器尽管与 GPT-4 的评判有很强的相关性,却不能通用于我们提出的标准。我们的研究结果表明,与 GPT-4 的相关性并不能完全代表评判模型的实际性能,还应辅之以单元测试评估,以实现精确的故障模式检测。 我们进一步证明,在 GPT-4 的推理踪迹上对 Llama-3 进行微调可显著提高其评估能力,改善与 GPT-4 评估的相关性以及在参考情况下的校准。

2.MemoRAG: Moving towards Next-Gen RAG Via Memory-Inspired Knowledge Discovery

标题:MemoRAG:通过受记忆启发的知识发现实现下一代 RAG

author:Hongjin Qian, Peitian Zhang, Zheng Liu, Kelong Mao, Zhicheng Dou

publish:Technical Report. Codes and models are in

https://github.com/qhjqhj00/MemoRAG

date Time:2024-09-09

paper pdf:http://arxiv.org/pdf/2409.05591v2

摘要:

检索增强生成(RAG)利用检索工具访问外部数据库,从而通过优化上下文提高大型语言模型(LLM)的生成质量。然而,现有的检索方法受到内在限制,因为它们只能在明确提出的查询和格式化的知识之间进行相关性匹配,而无法处理涉及模糊信息需求或非结构化知识的任务。因此,现有的 RAG 系统主要适用于简单的问题解答任务。在这项工作中,我们提出了 MemoRAG,一种由长期记忆支持的新型检索增强生成范例。MemoRAG 采用双系统架构。一方面,它采用轻型但长程的 LLM 来形成数据库的全局记忆。一旦提出任务,它就会生成答案草稿,并将检索工具集群化,以便在数据库中找到有用的信息。另一方面,它利用昂贵但富有表现力的 LLM,根据检索到的信息生成最终答案。在这一总体框架的基础上,我们通过增强聚类机制和记忆能力,进一步优化了 MemoRAG 的性能。在我们的实验中,MemoRAG 在各种评估任务中都取得了优异的性能,包括传统 RAG 失效的复杂任务和 RAG 常用的简单任务。

3.OneGen: Efficient One-Pass Unified Generation and Retrieval for LLMs

标题:OneGen:LLM 的高效单程统一生成和检索

author:Jintian Zhang, Cheng Peng, Mengshu Sun, Xiang Chen, Lei Liang, Zhiqiang Zhang, Jun Zhou, Huajun Chen, Ningyu Zhang

publish:Work in progress; code is available at

https://github.com/zjunlp/OneGen

date Time:2024-09-08

paper pdf:http://arxiv.org/pdf/2409.05152v1

摘要:

尽管近年来大语言模型(LLM)取得了长足的进步,极大地增强了各种 NLP 任务的生成能力,但 LLM 在直接处理检索任务方面仍然面临着局限性。然而,许多实际应用都需要检索和生成的无缝集成。本文介绍了一种新颖、高效的 "一次生成和检索 "框架(OneGen),旨在提高 LLM 在同时需要生成和检索的任务中的性能。所提出的框架通过结合自回归生成的检索标记,在传统的生成和检索分离训练方法之间架起了一座桥梁。这样,单个 LLM 就能在统一的前向传递中同时处理这两项任务。我们对 RAG 和实体链接这两种不同类型的复合任务进行了实验,以验证 OneGen 在训练和推理中的可插拔性、有效性和效率。此外,我们的结果表明,将生成和检索整合在同一上下文中,既保留了 LLM 的生成能力,又提高了检索性能。据我们所知,OneGen 是第一个能让 LLM 在生成过程中进行向量检索的工具。

4.Bioinformatics Retrieval Augmentation Data (BRAD) Digital Assistant

标题:生物信息学检索增强数据 (BRAD) 数字助理

author:Joshua Pickard, Marc Andrew Choi, Natalie Oliven, Cooper Stansbury, Jillian Cwycyshyn, Nicholas Galioto, Alex Gorodetsky, Alvaro Velasquez, Indika Rajapakse

date Time:2024-09-04

paper pdf:http://arxiv.org/pdf/2409.02864v1

摘要:

我们展示了生物信息学检索增强数据(BRAD)数字助手的原型。BRAD 集成了一套工具,可处理从代码执行到在线搜索等各种生物信息学任务。我们通过以下方面展示了 BRAD 的能力:(1)利用检索增强生成(RAG)改进问答;(2)BRAD 运行和编写复杂软件管道的能力;以及(3)BRAD 在代理个人和团队之间组织和分配任务的能力。我们使用 BRAD 实现生物信息学工作流程的自动化,执行从基因富集和档案搜索到自动代码生成和运行生物标记物鉴定管道等各种任务。BRAD 的最终目标是开发由自足循环驱动的实验室数字孪生系统,用于数字生物学实验的假设生成和测试。

5.Creating a Gen-AI based Track and Trace Assistant MVP (SuperTracy) for PostNL

标题:为 PostNL 创建基于 Gen-AI 的跟踪与追踪助理 MVP (SuperTracy)

author:Mohammad Reshadati

date Time:2024-09-04

paper pdf:http://arxiv.org/pdf/2409.02711v1

摘要:

生成式人工智能领域的发展为企业带来了许多机遇,例如提高客户服务效率和实现任务自动化。荷兰最大的包裹和电子商务公司 PostNL 希望利用生成式人工智能来加强包裹跟踪和追踪方面的交流。在实习期间,我们创建了一个最小可行产品(MVP),以展示使用生成式人工智能技术的价值,从而加强包裹跟踪,分析包裹的运输过程,并能够以简单易懂的方式进行沟通。主要目标是开发一个基于 LLM 的内部系统,减少对外部平台的依赖,并在公司内部建立一个专门的生成式人工智能团队。这个基于 LLM 的多代理系统旨在构建包裹行程故事,并以更高的效率和准确性识别物流中断。这项研究涉及部署一个复杂的人工智能驱动通信系统,采用检索增强生成(RAG)技术提高响应精度,以及优化针对特定领域任务定制的大型语言模型(LLM)。 MVP 成功实施了一个名为 SuperTracy 的多代理开源 LLM 系统。SuperTracy 能够自主管理各种用户查询,并改进内部知识处理。其结果和评估证明了技术的创新性和可行性,特别是在包裹追踪通信方面,超出了最初的预期。这些进步凸显了人工智能驱动解决方案在物流领域的潜力,为进一步完善和在 PostNL 运营框架内更广泛地实施提供了许多机会。

6.BEAVER: An Enterprise Benchmark for Text-to-SQL

标题:BEAVER:文本到 SQL 的企业基准

author:Peter Baile Chen, Fabian Wenz, Yi Zhang, Moe Kayali, Nesime Tatbul, Michael Cafarella, Çağatay Demiralp, Michael Stonebraker

date Time:2024-09-03

paper pdf:http://arxiv.org/pdf/2409.02038v1

摘要:

现有的文本到 SQL 基准主要是利用网络上的公开表格和人工生成的包含问题和 SQL 语句对的测试来构建的。它们通常显示出非常好的结果,让人们认为 LLM 在文本到 SQL 任务中非常有效。在本文中,我们将现成的 LLM 应用于包含企业数据仓库数据的基准测试。在这种环境下,即使使用了标准的提示工程和 RAG 技术,LLM 也表现不佳。正如我们将展示的那样,性能不佳的原因主要有三个:(1) 公共 LLM 无法在企业数据仓库中进行训练,因为这些数据仓库大多处于 "暗网 "中;(2) 企业表的模式比公共数据中的模式更加复杂,这导致 SQL 生成任务天生更加困难;(3) 面向业务的问题通常更加复杂,需要对多个表进行连接和聚合。因此,我们提出了一个新的数据集 BEAVER,该数据集来源于真实的企业数据仓库,以及我们从实际用户历史记录中收集的自然语言查询及其正确的 SQL 语句。我们使用最近的 LLM 对该数据集进行了评估,结果表明它们在这项任务中的表现不佳。我们希望这个数据集能帮助未来的研究人员构建更复杂的文本到 SQL 系统,从而在这类重要数据上取得更好的成绩。

7.In Defense of RAG in the Era of Long-Context Language Models

标题:在长语境语言模型时代为 RAG 辩护

author:Tan Yu, Anbang Xu, Rama Akkiraju

date Time:2024-09-03

paper pdf:http://arxiv.org/pdf/2409.01666v1

摘要:

为了克服早期 LLMs 中有限的上下文限制,检索增强生成(RAG)在过去一直是基于上下文生成答案的可靠解决方案。最近,长语境 LLMs 的出现使得模型可以包含更长的文本序列,从而降低了 RAG 的吸引力。最近的研究表明,在长语境应用中,长语境 LLM 明显优于 RAG。与现有的长上下文 LLM 优于 RAG 的研究不同,我们认为 LLM 中的超长上下文会降低对相关信息的关注,并导致答案质量的潜在下降。本文重新审视了长语境答案生成中的 RAG。我们提出了一种顺序保留检索增强生成(OP-RAG)机制,该机制显著提高了 RAG 在长上下文问答应用中的性能。使用 OP-RAG,随着检索块数量的增加,答案质量最初会上升,然后下降,形成一条倒 U 型曲线。与将整个上下文作为输入的长上下文 LLM 相比,OP-RAG 可以用更少的词块获得更高的答案质量。在公共基准上进行的大量实验证明了我们的 OP-RAG 的优越性。

8.Benchmarking Cognitive Domains for LLMs: Insights from Taiwanese Hakka Culture

标题:法学硕士认知领域的基准:台湾客家文化的启示

author:Chen-Chi Chang, Ching-Yuan Chen, Hung-Shin Lee, Chih-Cheng Lee

publish:Submitted to O-COCOSDA 2024

date Time:2024-09-03

paper pdf:http://arxiv.org/pdf/2409.01556v1

摘要:

本研究介绍了一种综合基准,旨在评估大型语言模型(LLMs)在理解和处理文化知识方面的性能,并以客家文化为案例进行了具体研究。该研究利用布鲁姆分类法,建立了一个多维框架,从六个认知领域对大型语言模型进行系统评估:记忆、理解、应用、分析、评价和创造。这一基准超越了传统的单一维度评估,更深入地分析了法律硕士处理特定文化内容的能力,从基本的事实回忆到创造性综合等高阶认知任务。此外,该研究还整合了检索-增强生成(RAG)技术,以解决少数民族文化知识在法律硕士中的表征难题,展示了 RAG 如何通过动态整合相关外部信息来提高模型的性能。研究结果凸显了 RAG 在提高所有认知领域的准确性方面的有效性,尤其是在需要精确检索和应用文化知识的任务中。不过,研究结果也揭示了 RAG 在创造性任务中的局限性,强调了进一步优化的必要性。该基准为评估和比较不同文化背景下的 LLM 提供了一个强大的工具,为人工智能驱动的文化知识保存和传播领域的未来研究和开发提供了宝贵的见解。

9.The Compressor-Retriever Architecture for Language Model OS

标题:语言模型操作系统的 "压缩机-逆转器 "架构

author:Yuan Yang, Siheng Xiong, Ehsan Shareghi, Faramarz Fekri

date Time:2024-09-02

paper pdf:http://arxiv.org/pdf/2409.01495v1

摘要:

大型语言模型(LLM)的最新进展极大地增强了其聚合和处理多模态信息的能力,使其能够执行各种任务,如多模态数据查询、工具使用、网络交互和处理长文档。这些能力为将 LLM 从单纯的聊天机器人转变为能够与现实世界互动的通用代理铺平了道路。本文探讨了将语言模型作为操作系统(OS)核心组件的概念,它实际上就像一个 CPU,可以处理存储在上下文窗口(RAM)中的数据。实现这种 LM 操作系统的一个关键挑战是管理终身上下文并确保跨会话的状态性,而由于上下文窗口大小的限制,当前基于会话的交互范式限制了这一功能。为了解决这个问题,我们引入了压缩器-逆转器(compressor-retriever),这是一种专为终身上下文管理而设计的与模型无关的架构。与检索增强生成等其他长上下文解决方案不同,我们的方法只使用基础模型的前向函数来压缩和检索上下文,从而确保端到端的可区分性。初步实验证明了这种架构在上下文学习任务中的有效性,标志着向开发完全有状态的 LLM 操作系统迈出了一步。项目资源库:https://github.com/gblackout/LM-OS

10.GenAI-powered Multi-Agent Paradigm for Smart Urban Mobility: Opportunities and Challenges for Integrating Large Language Models (LLMs) and Retrieval-Augmented Generation (RAG) with Intelligent Transportation Systems

标题:GenAI 驱动的智能城市交通多代理范式:将大型语言模型 (LLM) 和检索增强生成 (RAG) 与智能交通系统相结合的机遇与挑战

author:Haowen Xu, Jinghui Yuan, Anye Zhou, Guanhao Xu, Wan Li, Xuegang Ban, Xinyue Ye

date Time:2024-08-31

paper pdf:http://arxiv.org/pdf/2409.00494v2

摘要:

借助生成式人工智能的最新进展,多代理系统正日益得到开发,以增强智能城市应用的功能和效率。本文探讨了智能交通系统(ITS)中大型语言模型(LLM)和新兴的检索-增强生成(RAG)技术的变革潜力,为解决城市交通中的关键挑战铺平了创新解决方案的道路。我们首先全面概述了当前移动数据、智能交通系统和车联网 (CV) 应用的最新进展。在此基础上,我们讨论了 RAG 背后的原理,并探讨了将这些生成式人工智能(GenAI)技术整合到智能交通领域的机会。我们提出了一个概念框架,旨在开发能够以智能和对话方式为城市通勤者、交通运营商和决策者提供智能交通服务的多代理系统。我们的方法旨在促进一种自主和智能的方法,这种方法(a)促进以科学为基础的咨询,以在多种规模上减少交通拥堵、事故和碳排放;(b)促进公众教育和参与式交通管理;以及(c)自动执行专门的交通管理任务和开发关键的智能交通系统平台,如数据分析和解释、知识表示和交通模拟。通过整合 LLM 和 RAG,我们的方法力求克服传统的基于规则的多代理系统的局限性,因为这种系统依赖于固定的知识库和有限的推理能力。这种整合为更具可扩展性、直观性和自动化的多代理范例铺平了道路,推动了智能交通系统和城市交通的进步。

11.MaFeRw: Query Rewriting with Multi-Aspect Feedbacks for Retrieval-Augmented Large Language Models

标题:MaFeRw:针对检索增强大型语言模型的多方面反馈查询重写

author:Yujing Wang, Hainan Zhang, Liang Pang, Liang Pang, Hongwei Zheng, Zhiming Zheng

date Time:2024-08-30

paper pdf:http://arxiv.org/pdf/2408.17072v1

摘要:

在现实世界的 RAG 系统中,当前的查询往往涉及口语省略号和对话语境中的模糊引用,因此有必要进行查询重写,以更好地描述用户的信息需求。然而,由于从查询重写到生成响应的过程漫长,传统的基于上下文的重写对下游生成任务的增强作用微乎其微。一些研究人员尝试利用带有生成反馈的强化学习来帮助改写者,但在大多数情况下,这些稀疏的奖励所提供的指导很少,导致训练和生成结果不稳定。我们发现,用户的需求也反映在黄金文档、检索文档和地面实况中。因此,通过将这些多方面的密集奖励反馈给查询重写,可以获得更稳定、更令人满意的响应。在本文中,我们提出了一种新型查询重写方法 MaFeRw,通过整合检索过程和生成结果的多方面反馈来提高 RAG 性能。具体来说,我们首先使用人工数据来训练一个用于重写器初始化的 T5 模型。接下来,我们设计了三个指标作为强化学习反馈:重写查询与黄金文档之间的相似度、排名指标以及生成结果与地面实况之间的 ROUGE。受 RLAIF 的启发,我们为上述指标训练了三种奖励模型,以实现更高效的训练。最后,我们综合这些奖励模型的得分作为反馈,并使用 PPO 算法探索最优查询改写策略。在两个会话 RAG 数据集上的实验结果表明,与基线相比,MaFeRw 实现了更优越的生成指标和更稳定的训练。

12.Boosting Lossless Speculative Decoding via Feature Sampling and Partial Alignment Distillation

标题:通过特征采样和部分对齐蒸馏提升无损推测解码能力

author:Lujun Gui, Bin Xiao, Lei Su, Weipeng Chen

publish:The work was not submitted to AAAI 2025

date Time:2024-08-28

paper pdf:http://arxiv.org/pdf/2408.15562v1

摘要:

无损推测解码通过采用轻量级草稿模型来生成树状结构候选模型,从而加速目标大型语言模型(LLM)的推理,随后由目标大型语言模型进行并行验证。目前,有效的方法是在草稿模型中利用特征级而非标记级自动回归,以促进更直接的预测和增强知识提炼。在本文中,我们重新评估了这些方法,并提出了 FSPAD(用于无损推测性解码的特征采样和部分对齐提炼),它在现有框架中引入了两个直接有效的组件,以提高无损推测性解码。首先,FSPAD 利用标记嵌入技术对目标 LLM 在高维空间中的特征进行采样,然后再将其输入草稿模型,因为特征的固有不确定性会妨碍草稿模型获得目标 LLM 输出的特定标记。其次,FSPAD 引入了部分配准蒸馏法,以弱化草稿模型中特征与对数之间的联系,从而减少训练过程中特征配准与对数置信度之间的冲突。我们的实验包括对 Vicuna 和 LLaMA3-Instruct 系列中最大和最小模型的贪婪解码和非贪婪解码,以及多轮对话、翻译、总结、问题解答、数学推理和检索增强生成等任务。结果表明,在上述所有任务和目标 LLM 中,FSPAD 都优于最先进的方法。

13.LRP4RAG: Detecting Hallucinations in Retrieval-Augmented Generation via Layer-wise Relevance Propagation

标题:LRP4RAG:通过分层相关性传播在检索增强生成中检测幻觉

author:Haichuan Hu, Yuhan Sun, Quanjun Zhang

date Time:2024-08-28

paper pdf:http://arxiv.org/pdf/2408.15533v2

摘要:

检索增强生成(RAG)已成为减轻大型语言模型(LLM)幻觉的主要技术。然而,不完整的知识提取和不充分的理解仍会误导 LLM 生成不相关甚至相互矛盾的反应,这意味着幻觉在 RAG 中持续存在。本文提出了一种基于层相关性传播(LRP)算法的 LRP4RAG 方法,用于检测 RAG 中的幻觉。具体来说,我们首先利用 LRP 计算 RAG 生成器的输入和输出之间的相关性。然后,我们对相关性矩阵进行进一步提取和重采样。经过处理的相关性数据被输入到多个分类器中,以确定输出是否包含幻觉。据我们所知,这是 LRP 首次用于检测 RAG 幻觉,大量实验证明 LRP4RAG 的性能优于现有基线。

14.Writing in the Margins: Better Inference Pattern for Long Context Retrieval

标题:写在边缘更好的长语境检索推理模式

author:Melisa Russak, Umar Jamil, Christopher Bryant, Kiran Kamble, Axel Magnuson, Mateusz Russak, Waseem AlShikh

date Time:2024-08-27

paper pdf:http://arxiv.org/pdf/2408.14906v1

摘要:

在本文中,我们介绍了 “边际写作”(WiM),这是大型语言模型的一种新推理模式,旨在优化面向检索任务中长输入序列的处理。这种方法利用键值缓存的分块预填充来执行分段推理,从而可以高效处理大量上下文,同时生成中间信息(“边际”)并对其进行分类,从而引导模型完成特定任务。这种方法仅略微增加了计算开销,却能显著提高现成模型的性能,而无需进行微调。具体来说,我们观察到 WiM 在推理技能(HotpotQA、MultiHop-RAG)方面平均提高了 7.5% 的准确率,在聚合任务(CWE)方面提高了 30.0% 以上的 F1 分数。此外,我们还展示了所提出的模式如何与交互式检索设计相匹配,该设计可为最终用户提供有关上下文处理进度的持续更新,并将相关信息准确地整合到最终响应中。我们在 https://github.com/writer/writing-in-the-margins 上发布了使用抱脸变形库实现的 WiM。

15.Biomedical Large Languages Models Seem not to be Superior to Generalist Models on Unseen Medical Data

标题:在未知医学数据上,生物医学大型语言模型似乎并不优于通用模型

author:Felix J. Dorfner, Amin Dada, Felix Busch, Marcus R. Makowski, Tianyu Han, Daniel Truhn, Jens Kleesiek, Madhumita Sushil, Jacqueline Lammert, Lisa C. Adams, Keno K. Bressem

publish:10 pages, 3 tables, 1 figure

date Time:2024-08-25

paper pdf:http://arxiv.org/pdf/2408.13833v1

摘要:

大型语言模型(LLMs)在生物医学应用中显示出了潜力,这促使人们努力在特定领域的数据上对其进行微调。然而,这种方法的有效性仍不明确。本研究评估了经过生物医学微调的 LLM 在各种临床任务中的表现,并与通用型 LLM 进行了对比。我们评估了它们在《新英格兰医学杂志》(NEJM)和《美国医学会杂志》(JAMA)的临床病例挑战以及几项临床任务(如信息提取、文档摘要和临床编码)上的性能。通过使用生物医学模型微调数据集之外的特定基准,我们发现生物医学 LLM 的表现大多不如通用型 LLM,尤其是在不侧重于医学知识的任务上。虽然大型模型在病例任务上的表现类似(例如,OpenBioLLM-70B:66.4% vs. Llama-3-70B-Instruct:65% on JAMA cases),但小型生物医学模型的表现则更为明显(例如,OpenBioLLM-8B:30% vs. Llama-3-8B-Instruct: 64.3% on NEJM cases)。在 CLUE(临床语言理解评估)基准任务中也观察到了类似的趋势,通用模型通常在文本生成、问题解答和编码任务中表现更好。我们的研究结果表明,根据生物医学数据对 LLM 进行微调可能不会带来预期的好处,还有可能导致性能下降,这对目前关于 LLM 特定领域适应性的假设提出了挑战,并强调了医疗人工智能领域需要更严格的评估框架。其他方法,如检索增强生成,可能会更有效地增强 LLM 的生物医学能力,而不会损害其一般知识。

16.Towards Human-Level Understanding of Complex Process Engineering Schematics: A Pedagogical, Introspective Multi-Agent Framework for Open-Domain Question Answering

标题:实现人类对复杂过程工程原理图的理解:用于开放域问题解答的教学型内省式多代理框架

author:Sagar Srinivas Sakhinana, Geethan Sannidhi, Venkataramana Runkana

publish:Our paper is accepted for publication at ML4CCE workshop at ECML PKDD

2024

date Time:2024-08-24

paper pdf:http://arxiv.org/pdf/2409.00082v1

摘要:

在化工和加工行业,工艺流程图 (PFD) 和管道与仪表图 (P&ID) 对于设计、施工和维护至关重要。生成式人工智能的最新进展,如 GPT4 (Omni) 等大型多模态模型 (LMM),在理解和解释用于可视化问题解答 (VQA) 的流程图方面显示了前景。然而,专有模型会带来数据隐私风险,而且其计算复杂性阻碍了在消费类硬件上进行特定领域定制的知识编辑。为了克服这些挑战,我们针对开放领域问题解答(ODQA)任务提出了一种安全的企业内部解决方案,该解决方案采用分层、多代理检索增强生成(RAG)框架,可提供更高的数据隐私性、可解释性和成本效益。我们新颖的多代理框架采用内省和专业化的子代理,利用开源的小型多模态模型和 ReAct(Reason+Act)提示技术进行 PFD 和 P&ID 分析,整合多个信息源,提供准确且与上下文相关的答案。我们的方法得到了迭代自我修正的支持,目的是在 ODQA 任务中提供卓越的性能。我们进行了严格的实验研究,实证结果验证了建议方法的有效性。

17.Graph Retrieval Augmented Trustworthiness Reasoning

标题:图检索增强可信度推理

author:Ying Zhu, Shengchang Li, Ziqian Kong, Peilan Xu

date Time:2024-08-22

paper pdf:http://arxiv.org/pdf/2408.12333v2

摘要:

在信息不完整的多人游戏中,可信度推理至关重要,它能让代理识别潜在的盟友和对手,从而加强推理和决策过程。传统的方法依赖于预先训练的模型,需要大量的特定领域数据和大量的奖励反馈,其缺乏实时适应性阻碍了它们在动态环境中的有效性。在本文中,我们介绍了图形检索增强推理(GRATR)框架,利用检索增强生成(RAG)技术来增强代理的可信度推理。GRATR 构建了一个动态可信度图,利用证据信息对其进行实时更新,并检索相关的信任数据,以增强大型语言模型(LLM)的推理能力。我们通过在多人游戏 "狼人杀 "中的实验验证了我们的方法,并将 GRATR 与基准 LLM 和使用原生 RAG 和 Rerank RAG 增强的 LLM 进行了比较。结果表明,GRATR 的胜率比基准方法高出 30%以上,推理性能更优越。此外,GRATR 还有效地减少了 LLM 的幻觉,如身份和客观健忘症,更重要的是,它通过使用可信度图使推理过程更加透明和可追溯。

18.Leveraging Chemistry Foundation Models to Facilitate Structure Focused Retrieval Augmented Generation in Multi-Agent Workflows for Catalyst and Materials Design

标题:利用化学基础模型促进催化剂和材料设计多代理工作流程中的结构重点检索增强生成

author:Nathaniel H. Park, Tiffany J. Callahan, James L. Hedrick, Tim Erdmann, Sara Capponi

date Time:2024-08-21

paper pdf:http://arxiv.org/pdf/2408.11793v1

摘要:

通过深度学习模型进行分子特性预测和生成设计,具有加速开发新型高性能材料的潜力,因此一直是热门研究课题。最近,随着大型语言模型(LLM)和 LLM 驱动的代理系统的出现,这些工作流程得到了显著增强,这些代理系统能够在更复杂的研究任务中利用预先训练好的模型进行预测。虽然效果显著,但在为材料设计任务检索突出信息方面,代理系统仍有很大的改进空间。此外,预测性深度学习模型的其他用途,如利用其潜在表征促进代理系统内的跨模态检索增强生成,以实现特定任务的材料设计,仍有待探索。在此,我们展示了大型预训练化学基础模型可以作为实现小分子、复杂聚合物材料和反应的语义化学信息检索的基础。此外,我们还展示了如何将化学基础模型与 OpenCLIP 等图像模型结合使用,从而在多个表征数据领域实现前所未有的查询和信息检索。最后,我们展示了将这些系统集成到多代理系统中,以促进基于结构和拓扑的自然语言查询和信息检索,完成复杂的研究任务。

19.Xinyu: An Efficient LLM-based System for Commentary Generation

标题:新语:基于 LLM 的高效评论生成系统

author:Yiquan Wu, Bo Tang, Chenyang Xi, Yu Yu, Pengyu Wang, Yifei Liu, Kun Kuang, Haiying Deng, Zhiyu Li, Feiyu Xiong, Jie Hu, Peng Cheng, Zhonghao Wang, Yi Wang, Yi Luo, Mingchuan Yang

date Time:2024-08-21

paper pdf:http://arxiv.org/pdf/2408.11609v2

摘要:

评论通过提出不同的论点和证据,让读者深入了解事件。然而,即使对于熟练的评论员来说,创建评论也是一项耗时的任务。大语言模型(LLM)简化了自然语言生成的过程,但由于独特的任务要求,将其直接应用于评论创作仍面临挑战。这些要求可分为两个层次:1)基本要求,包括创建结构合理、逻辑一致的叙述;2)高级要求,包括生成高质量的论据并提供令人信服的证据。在本文中,我们介绍了基于 LLM 的高效系统 “新语”,该系统旨在帮助注释者生成中文注释。为满足基本要求,我们将中文注释的生成过程分解为多个步骤,并为每个步骤提出了有针对性的策略和监督微调(SFT)。针对高级要求,我们提出了论据排序模型,并建立了包括最新事件和经典著作在内的综合证据数据库,从而利用检索增强生成(RAG)技术加强了证据的确凿性。为了更公平地评价生成的评论,与两级要求相对应,我们引入了一个综合评价指标,在评论生成过程中考虑了五个不同的角度。我们的实验证实了我们提出的系统的有效性。我们还观察到评论员在实际场景中的效率有了显著提高,创建评论所花费的平均时间从 4 小时降至 20 分钟。重要的是,效率的提高并没有影响评论的质量。

20.RAGLAB: A Modular and Research-Oriented Unified Framework for Retrieval-Augmented Generation

标题:RAGLAB:以研究为导向的模块化检索增强生成统一框架

author:Xuanwang Zhang, Yunze Song, Yidong Wang, Shuyun Tang, Xinfeng Li, Zhengran Zeng, Zhen Wu, Wei Ye, Wenyuan Xu, Yue Zhang, Xinyu Dai, Shikun Zhang, Qingsong Wen

publish:6 pages, 3 figures

date Time:2024-08-21

paper pdf:http://arxiv.org/pdf/2408.11381v2

摘要:

大型语言模型(LLMs)在对话、推理和知识保留方面展示了人类水平的能力。然而,即使是最先进的 LLM 也面临着幻觉和知识实时更新等挑战。目前的研究通过为 LLM 配备外部知识来解决这一瓶颈,这种技术被称为 “检索增强生成”(RAG)。然而,有两个关键问题制约着 RAG 的发展。首先,新型 RAG 算法之间越来越缺乏全面、公平的比较。其次,LlamaIndex 和 LangChain 等开源工具采用了高级抽象,导致缺乏透明度,限制了开发新型算法和评估指标的能力。为了缩小这一差距,我们引入了 RAGLAB,这是一个模块化、面向研究的开源库。RAGLAB 重现了 6 种现有算法,为研究 RAG 算法提供了一个全面的生态系统。利用 RAGLAB,我们在 10 个基准中对 6 种 RAG 算法进行了公平比较。借助 RAGLAB,研究人员可以有效地比较各种算法的性能,并开发新型算法。

21.Reading with Intent

标题:用心阅读

author:Benjamin Reichman, Kartik Talamadupula, Toshish Jawale, Larry Heck

date Time:2024-08-20

paper pdf:http://arxiv.org/pdf/2408.11189v1

摘要:

检索增强生成(RAG)系统通过整合维基百科、内部文档、科学论文或开放式互联网等外部信息源来增强知识语言模型。依靠开放互联网作为知识来源的 RAG 系统必须应对人类生成内容的复杂性。人与人之间的交流远不止是文字上的交流。意图、语调和内涵都会改变所传达内容的含义。最近在现实世界中部署的 RAG 系统在理解人类交流的这些细微差别方面遇到了一些困难。这些系统面临的一个重大挑战是如何处理讽刺语言。虽然构成这些 RAG 系统骨干的大语言模型 (LLM) 能够检测讽刺,但目前它们并不总是将这些检测结果用于后续的文本处理。为了解决这些问题,在本文中,我们从 Natural Question 的维基百科检索语料库中合成了讽刺性段落。然后,我们测试了这些段落对 RAG 管道中检索器和阅读器部分性能的影响。我们引入了一个提示系统,旨在增强模型在出现讽刺时解释和生成响应的能力,从而提高系统的整体性能。最后,我们进行了消解研究,以验证我们的方法的有效性,证明了 RAG 系统在处理讽刺内容方面的改进。

22.Retrieval-Augmented Generation Meets Data-Driven Tabula Rasa Approach for Temporal Knowledge Graph Forecasting

标题:时态知识图谱预测的检索增强生成与数据驱动的 Tabula Rasa 方法相结合

author:Geethan Sannidhi, Sagar Srinivas Sakhinana, Venkataramana Runkana

publish:Paper was accepted at ACM KDD -2024 – Undergraduate Consortium.

Please find the link: https://kdd2024.kdd.org/undergraduate-consortium/

date Time:2024-08-18

paper pdf:http://arxiv.org/pdf/2408.13273v1

摘要:

像 OpenAI ChatGPT 和 Google Gemini 这样的预训练大型语言模型(PLLM)在时序知识图谱(tKG)预测方面面临着事实回忆不准确、幻觉、偏差和未来数据泄露等挑战。为了解决这些问题,我们推出了 sLA-tKGF(用于 tKG 预测的小规模语言助手),它利用检索增强生成(RAG)辅助、定制训练的小规模语言模型,通过从头开始的 tabula rasa 方法进行有效的 tKG 预测。我们的框架利用来自 tKG 的相关历史数据、网络搜索结果和 PLLM 生成的文本描述构建知识注入提示,以了解目标时间之前的历史实体关系。它利用这些注入知识的外部提示,加深对特定语境语义和时间信息的理解和推理,从而零距离提示小规模语言模型,更准确地预测 tKG 中的未来事件。它通过理解随时间变化的趋势,减少了幻觉,减轻了分布转移的挑战。因此,它能对未来事件进行更准确、更有语境基础的预测,同时将计算需求降至最低。严谨的实证研究证明了我们的框架的稳健性、可扩展性以及在基准数据集上的一流(SOTA)性能,并提供了可解释和可信的 tKG 预测。

23.Agentic Retrieval-Augmented Generation for Time Series Analysis

标题:用于时间序列分析的代理检索-增强生成

author:Chidaksh Ravuru, Sagar Srinivas Sakhinana, Venkataramana Runkana

publish:Paper was accepted for Undergraduate Consortium at ACM KDD, 2024.

Please find the link: https://kdd2024.kdd.org/undergraduate-consortium/

date Time:2024-08-18

paper pdf:http://arxiv.org/pdf/2408.14484v1

摘要:

时间序列建模对许多应用都至关重要,然而,在从历史背景中学习预测特定任务结果时,它面临着复杂的时空依赖性和分布变化等挑战。为了应对这些挑战,我们提出了一种使用代理检索-增强生成(RAG)框架进行时间序列分析的新方法。该框架采用分层多代理架构,其中主代理负责协调专门的子代理,并将最终用户请求委托给相关的子代理。子代理利用较小的预训练语言模型(SLM),通过指令调整和直接偏好优化进行微调,从而为特定的时间序列任务定制语言模型,并从包含历史模式和趋势相关知识的提示池共享资源库中检索相关提示,以改进对新数据的预测。我们提出的模块化多代理 RAG 方法比针对特定任务的定制方法在基准数据集上更有效地应对了复杂的挑战,从而提供了灵活性,并在主要时间序列任务中实现了最先进的性能。

24.Extracting polygonal footprints in off-nadir images with Segment Anything Model

标题:利用 "分段任意模型 "提取离轴图像中的多边形脚印

author:Kai Li, Jingbo Chen, Yupeng Deng, Yu Meng, Diyou Liu, Junxian Ma, Chenhao Wang

date Time:2024-08-16

paper pdf:http://arxiv.org/pdf/2408.08645v1

摘要:

偏离天空的航空图像中的建筑物足迹提取(BFE)通常依赖于屋顶分割和屋顶到足迹的偏移预测,然后通过偏移对屋顶到足迹进行下药。然而,由于预测给出的掩模质量不高,这种多阶段推理的结果并不适用于数据生产。为了解决这个问题,我们在本文中提出了 OBMv2,它同时支持端到端和可提示多边形足迹预测。与 OBM 不同的是,OBMv2 使用新提出的自偏移注意(SOFA)来弥补平房和摩天大楼的性能差距,实现了真正的端到端足迹多边形预测,而无需后处理。在此基础上,我们还开发了更多的新方法,如非最大值抑制(NMS)和距离非最大值抑制(DNMS)。为了充分利用屋顶掩模、建筑掩模和偏移中包含的信息,我们提出了用于足迹预测的多层次信息体系(MISS),有了它,OBMv2 即使在预测不足的情况下也能预测足迹。此外,为了从同一模型中提取信息,我们受到自然语言处理中的检索-增强生成(RAG)的启发,提出了 "RAG in BFE "问题。为了验证所提方法的有效性,我们在开放数据集 BONAI 和 OmniCity-view3 上进行了实验。此外,还在惠州测试集上进行了泛化测试。代码可在\url{https://github.com/likaiucas/OBM}上获取。

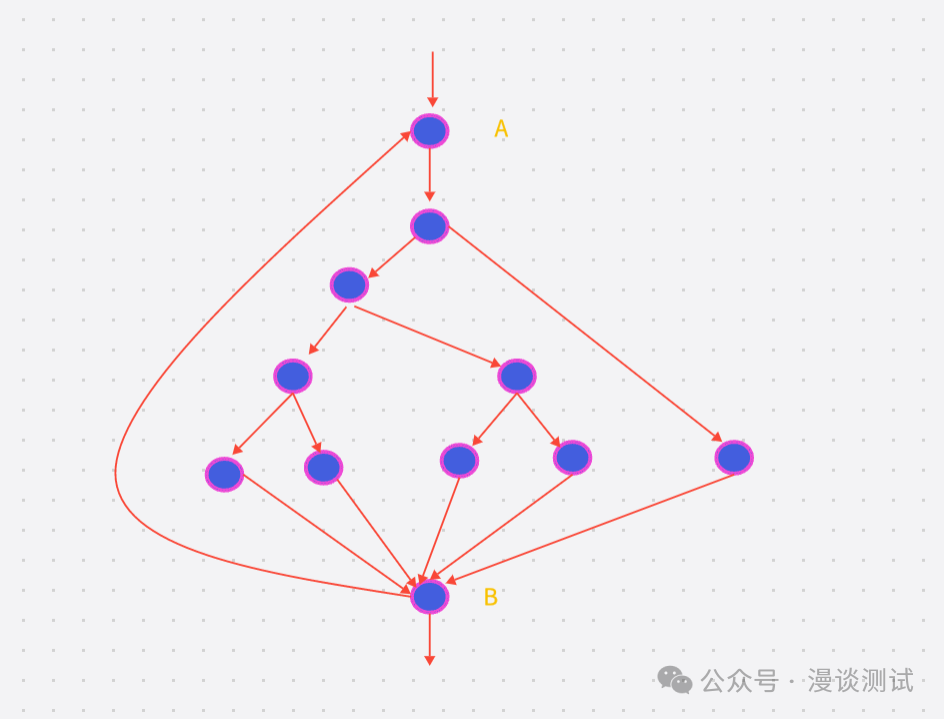

25.CommunityKG-RAG: Leveraging Community Structures in Knowledge Graphs for Advanced Retrieval-Augmented Generation in Fact-Checking

标题:CommunityKG-RAG:利用知识图谱中的社群结构实现事实核查中的高级检索-增强生成

author:Rong-Ching Chang, Jiawei Zhang

date Time:2024-08-16

paper pdf:http://arxiv.org/pdf/2408.08535v1

摘要:

尽管大语言模型(LLMs)和检索增强生成(RAG)系统取得了进步,但由于缺乏与实体关系和社区结构的整合,它们的有效性往往受到阻碍,从而限制了它们为事实检查提供上下文丰富且准确的信息检索的能力。我们介绍了 CommunityKG-RAG(社区知识图谱-检索增强生成),这是一种新颖的零点框架,它将知识图谱(KG)中的社区结构与 RAG 系统集成在一起,以增强事实检查过程。CommunityKG-RAG 无需额外培训即可适应新领域和新查询,它利用知识图谱中社区结构的多跳特性,显著提高了信息检索的准确性和相关性。我们的实验结果表明,CommunityKG-RAG 的性能优于传统方法,提供了一种稳健、可扩展和高效的解决方案,代表了事实检查领域的重大进步。